Configuration de la communication entre nœuds

Les nœuds d’une configuration de cluster communiquent entre eux à l’aide des mécanismes de communication inter-nœuds suivants :

- Les nœuds qui se trouvent au sein du réseau (même sous-réseau) communiquent entre eux via le panneau arrière du cluster. Le fond de panier doit être configuré de manière explicite. Les étapes détaillées sont les suivantes.

- Sur les réseaux, le pilotage des paquets s’effectue via un tunnel GRE et les autres communications de nœud à nœud sont acheminées entre les nœuds selon les besoins.

Important

- À partir de la version 11.0, toutes les versions d’un cluster peuvent inclure des nœuds provenant de différents réseaux.

- À partir de la version 13.0 build 58.3, le pilotage GRE est pris en charge sur les cartes réseau Fortville dans un cluster L3.

Pour configurer le backplane du cluster, procédez comme suit pour chaque nœud

- Identifiez l’interface réseau que vous souhaitez utiliser pour le fond de panier.

- Connectez un câble Ethernet ou optique entre l’interface réseau sélectionnée et le commutateur du panneau arrière du cluster.

Par exemple, pour utiliser l’interface 1/2 comme interface de fond de panier pour le nœud 4, connectez un câble entre l’interface 1/2 du nœud 4 et le commutateur de fond de panier.

Points importants à prendre en compte lors de la configuration du backplane du cluster

-

N’utilisez pas l’interface de gestion (0/x) de l’appliance comme interface de fond de panier. Dans un cluster, l’interface 0/1/x se lit comme suit :

0 -> ID de nœud 0 1/x -> Interface Citrix ADC

-

N’utilisez pas les interfaces de fond de panier pour les plans de données client ou serveur.

- Citrix recommande d’utiliser le canal Link Aggregate (LA) pour le fond de panier du cluster.

Remarque :

Après avoir dissocié une interface du canal LA, assurez-vous de définir une taille MTU appropriée pour l’interface indépendante.

-

Dans un cluster à deux nœuds, où le fond de panier est connecté dos à dos, le cluster est opérationnel hors service dans l’une des conditions suivantes :

- L’un des nœuds est redémarré.

- L’interface de fond de panier de l’un des nœuds est désactivée.

Citrix vous recommande donc de dédier un commutateur distinct au backplane, afin que l’autre nœud du cluster et le trafic ne soient pas affectés. Vous ne pouvez pas étendre le cluster à l’aide d’un lien dos à dos. Vous pouvez rencontrer une interruption de l’environnement de production lorsque vous augmentez la taille des nœuds du cluster.

-

Les interfaces du backplane de tous les nœuds d’un cluster doivent être connectées au même commutateur et liées au même VLAN L2.

-

Si vous avez plusieurs clusters avec le même ID d’instance de cluster, assurez-vous que les interfaces du backplane de chaque cluster sont liées à un VLAN différent.

-

L’interface du backplane est toujours surveillée, quels que soient les paramètres de surveillance HA de cette interface.

-

L’état de l’usurpation d’adresse MAC sur les différentes plateformes de virtualisation peut affecter le mécanisme de pilotage du panneau arrière du cluster. Assurez-vous donc que l’état approprié est configuré :

- XenServer - Désactiver l’usurpation d’adresse MAC

- Hyper-V - Activer l’usurpation d’adresse MAC

- VMware ESX : activez l’usurpation d’adresse MAC (assurez-vous également que les « transmissions falsifiées » sont activées)

-

Le MTU du fond de panier du cluster est automatiquement mis à jour. Toutefois, si des trames jumbo sont configurées sur le cluster, la MTU du backplane du cluster doit être configurée de manière explicite. La valeur doit être définie sur 78 + X, où X est la MTU maximale des plans de données client et serveur. Par exemple, si le MTU d’un plan de données serveur est 7500 et celui du plan de données client est 8922. Le MTU d’un backplane d’un cluster doit être défini sur 78 + 8922 = 9000. Pour définir ce MTU, utilisez la commande suivante :

> set interface <backplane_interface> -mtu <value> -

La MTU pour les interfaces du commutateur de fond de panier doit être supérieure ou égale à 1 578 octets. Cela s’applique si le cluster possède des fonctionnalités telles que le MBF, les stratégies L2, les ACL, le routage dans les déploiements CLAG et VPath.

Remarque :

La taille MTU par défaut pour une interface de fond de panier est 1578. Pour rétablir la valeur par défaut de la taille du MTU, vous devez utiliser la commande

unset interface <backplane_interface> -mtu.

Support de tunnel basé sur UDP pour les clusters L2 et L3

À partir de la version 13.0 build 36.x de Citrix ADC, les clusters Citrix ADC L2 et L3 peuvent diriger le trafic à l’aide d’un tunneling basé sur UDP. Il est défini pour les communications entre deux nœuds d’un cluster. En utilisant le paramètre « mode tunnel », vous pouvez définir le mode tunnel GRE ou UDP à partir de la commande add and set cluster node.

Dans un déploiement de cluster L3, les paquets entre les nœuds Citrix ADC sont échangés via un tunnel GRE non chiffré qui utilise les adresses NSIP des nœuds source et de destination pour le routage. Lorsque cet échange a lieu sur Internet, en l’absence d’un tunnel IPsec, le NSIP est exposé sur Internet et peut entraîner des problèmes de sécurité.

Important

Citrix recommande à ses clients d’établir leur propre solution IPsec lorsqu’ils utilisent un cluster L3.

Le tableau suivant vous aide à classer la prise en charge des tunnels en fonction des différents déploiements.

| Types de direction | AWS | Microsoft Azure | Sur site |

|---|---|---|---|

| MAC | Non pris en charge | Non pris en charge | Pris en charge |

| Tunnel GRE | Pris en charge | Non pris en charge | Pris en charge |

| Tunnel UDP | Pris en charge | Pris en charge | Pris en charge |

Important

Dans un cluster L3, le mode tunnel est défini sur GRE par défaut.

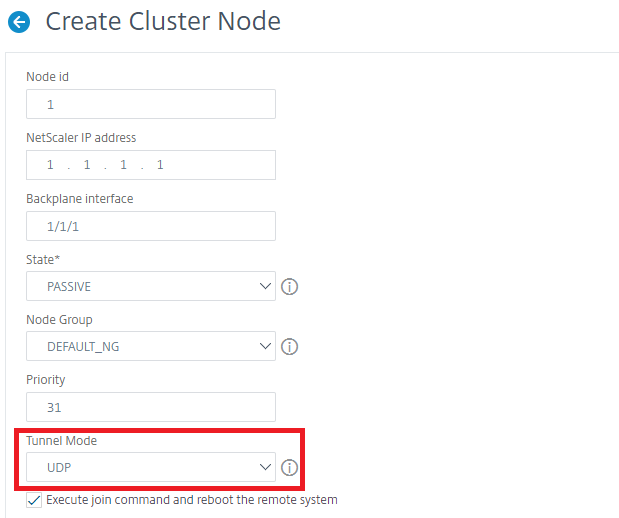

Configuration d’un tunnel basé sur UDP

Vous pouvez ajouter un nœud de cluster en définissant les paramètres de l’ID du nœud et en mentionnant l’état. Configurez le fond de panier en fournissant le nom de l’interface et sélectionnez le mode tunnel de votre choix (GRE ou UDP).

Remarque :

Vous devez configurer le mode tunnel à partir de l’adresse IP du cluster.

Procédures CLI

Pour activer le mode tunnel UDP à l’aide de l’interface de ligne de commande.

À l’invite de commandes, tapez :

add cluster node <nodeId>@ [-state <state>] [-backplane <interface_name>] [-tunnelmode <tunnelmode>]set cluster node <nodeId>@ [-state <state>] [-tunnelmode <tunnelmode>]

Remarque

Les valeurs possibles pour le mode tunnel sont NONE, GRE, UDP.

Exemple

add cluster node 1 –state ACTIVE –backplane 1/1/1 -tunnelmode UDPset cluster node 1 –state ACTIVE –tunnelmode UDP

Procédures GUI

Pour activer le mode tunnel UDP à l’aide de l’interface graphique.

-

Accédez à Système > Cluster > Nœuds.

-

Sur la page Nœuds de cluster, cliquez sur Ajouter.

-

Dans le nœud Create Cluster, définissez le paramètre Mode tunnel sur UDP et cliquez sur Créer.

-

Cliquez sur Fermer.