Scalabilité

L’optimisation TCP étant gourmande en ressources, une seule appliance NetScaler, même haut de gamme, peut ne pas être en mesure de supporter des débits Gi-LAN élevés. Pour étendre la capacité de votre réseau, vous pouvez déployer des appliances NetScaler dans une formation de clusters N+1. Dans un déploiement en cluster, les appliances NetScaler fonctionnent ensemble comme une seule image système. Le trafic client est réparti entre les nœuds du cluster à l’aide d’un commutateur externe.

Topologie

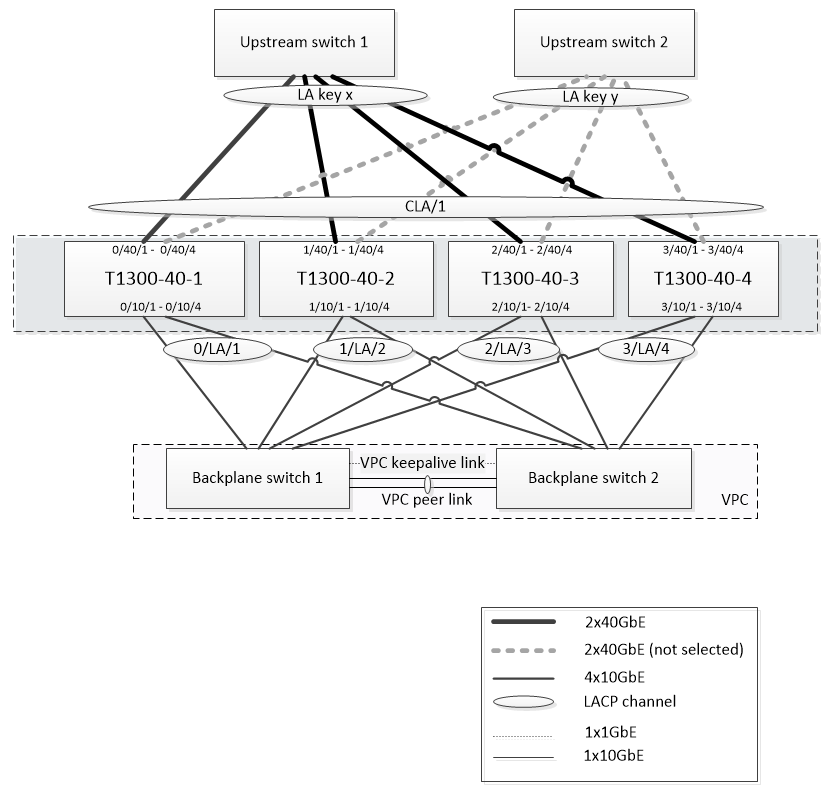

La figure 1 est un exemple de cluster composé de quatre nœuds T1300-40G.

La configuration illustrée à la Figure 1 possède les propriétés suivantes :

- Tous les nœuds du cluster appartiennent au même réseau (également appelé cluster L2).

- Le trafic du plan de données et du fond de panier est géré par différents commutateurs.

- En supposant que le débit Gi-LAN est de 200 Gbit/s et qu’une appliance T1300-40G peut supporter un débit de 80 Gbit/s, nous avons besoin de trois appliances T1300-40G. Pour assurer la redondance en cas de défaillance d’un seul nœud de cluster, nous déployons quatre appliances au total.

- Chaque nœud recevra jusqu’à 67 Gbit/s de trafic (50 Gbit/s dans des conditions de fonctionnement normales et 67 Gbit/s en cas de défaillance d’un nœud de cluster). Il a donc besoin de connexions de 2 x 40 Gbit/s au commutateur en amont. Pour assurer la redondance en cas de panne d’un commutateur, nous déployons deux commutateurs en amont et doublons le nombre de connexions.

- L’agrégation de liens de cluster (CLAG) est utilisée pour répartir le trafic entre les nœuds du cluster. Un seul CLAG gère à la fois le trafic client et serveur. La redondance des liens est activée sur le CLAG, de sorte qu’un seul « sous-canal » est sélectionné à la fois et gère le trafic. Si une liaison échoue ou si le débit tombe en dessous du seuil spécifié, l’autre sous-canal est sélectionné.

- Le commutateur en amont effectue un équilibrage de charge symétrique des canaux de port (par exemple, l’algorithme source-dest-ip uniquement de Cisco IOS 7.0 (8) N1 (1)) afin que les flux de trafic aller et retour soient gérés par le même nœud de cluster. Cette propriété est souhaitable car elle élimine la réorganisation des paquets, qui dégraderait les performances du protocole TCP.

- Cinquante pour cent du trafic de données devrait être dirigé vers le backplane, ce qui signifie que chaque nœud sera dirigé jusqu’à 34 Gbit/s vers les autres nœuds du cluster (25 Gbit/s dans des conditions de fonctionnement normales et 34 Gbit/s en cas de défaillance d’un nœud de cluster). Ainsi, chaque nœud a besoin d’au moins 4 connexions 10G au commutateur de fond de panier. Pour assurer la redondance en cas de panne du commutateur, nous déployons deux commutateurs de fond de panier et doublons le nombre de connexions. La redondance des liens n’est actuellement pas prise en charge pour le backplane. C’est pourquoi il est préférable de disposer d’un VPC Cisco ou d’une technologie équivalente pour obtenir une redondance au niveau du commutateur.

- La taille MTU des paquets dirigés est de 1 578 octets. Les commutateurs du backplane doivent donc prendre en charge un MTU supérieur à 1 500 octets.

Remarque : La conception illustrée à la figure 1 s’applique également aux appareils T1120 et T1310. Pour le T1310, nous utiliserions des interfaces 40 GbE pour les connexions du fond de panier, car il ne dispose pas de ports 10 GbE.

Remarque : Bien que ce document utilise Cisco VPC comme exemple, si vous travaillez avec des commutateurs autres que Cisco, d’autres solutions équivalentes peuvent être utilisées, telles que le MLAG de Juniper.

Remarque : Bien que d’autres topologies telles que ECMP au lieu de CLAG soient possibles, elles ne sont actuellement pas prises en charge pour ce cas d’utilisation particulier.

Configuration de l’optimisation TCP dans un cluster NetScaler T1000

Une fois l’installation physique, la connectivité physique, l’installation du logiciel et la gestion des licences terminées, vous pouvez procéder à la configuration réelle du cluster. Les configurations décrites ci-dessous s’appliquent au cluster représenté à la figure 1.

Remarque : Pour plus d’informations sur la configuration du cluster, consultez la section Configuration d’un cluster NetScaler.

Supposons que les quatre nœuds T1300 de la figure 1 ont les adresses NSIP suivantes :

Quatre nœuds T1300 avec adresse NSIP :

T1300-40-1: 10.102.29.60

T1300-40-2: 10.102.29.70

T1300-40-3: 10.102.29.80

T1300-40-4: 10.102.29.90

Le cluster sera géré via l’adresse IP du cluster (CLIP), qui est supposée être 10.78.16.61.

Configuration du cluster

Pour commencer à configurer le cluster illustré à la Figure 1, ouvrez une session sur le premier dispositif que vous souhaitez ajouter au cluster (par exemple, T1300-40-1) et procédez comme suit.

-

À l’invite de commandes, saisissez les commandes suivantes :

Commande :

> add cluster instance 1 > add cluster node 0 10.102.29.60 -state ACTIVE > add ns ip 10.102.29.61 255.255.255.255 -type clip > enable cluster instance 1 > save ns config > reboot –warm -

Après le redémarrage de l’appliance, connectez-vous à l’adresse IP du cluster (CLIP) et ajoutez le reste des nœuds au cluster :

Commande :

> add cluster node 1 10.102.29.70 -state ACTIVE > add cluster node 2 10.102.29.80 -state ACTIVE > add cluster node 3 10.102.29.90 –state ACTIVE > save ns config -

Connectez-vous à l’adresse NSIP de chacun des nœuds nouvellement ajoutés et rejoignez le cluster :

Commande :

> join cluster -clip 10.102.29.61 -password nsroot > save ns config > reboot –warm -

Après le redémarrage des nœuds, procédez à la configuration du fond de panier. Sur l’adresse IP du cluster, entrez les commandes suivantes pour créer un canal LACP pour le lien du backplane de chaque nœud du cluster :

Commande :

> set interface 0/10/[1-8] –lacpkey 1 –lacpmode ACTIVE > set interface 1/10/[1-8] –lacpkey 2 –lacpmode ACTIVE > set interface 2/10/[1-8] –lacpkey 3 –lacpmode ACTIVE > set interface 3/10/[1-8] –lacpkey 4 –lacpmode ACTIVE -

De même, configurez LA et VPC dynamiques sur les commutateurs de fond de panier. Assurez-vous que la MTU des interfaces du commutateur de fond de panier est d’au moins 1 578 octets.

-

Vérifiez que les canaux sont opérationnels :

Commande :

> show channel 0/LA/1 > show channel 1/LA/2 > show channel 2/LA/3 > show channel 3/LA/4 -

Configurez les interfaces de fond de panier du nœud de cluster.

Commande :

> set cluster node 0 -backplane 0/LA/1 > set cluster node 1 -backplane 1/LA/2 > set cluster node 2 -backplane 2/LA/3 > set cluster node 3 –backplane 3/LA/4 -

Vérifiez l’état du cluster et vérifiez que le cluster est opérationnel :

> show cluster instance > show cluster node

Pour plus d’informations sur la configuration du cluster, voir Configuration d’un cluster NetScaler

Répartition du trafic entre les nœuds de cluster

Après avoir créé le cluster NetScaler, déployez Cluster Link Aggrégation (CLAG) pour répartir le trafic entre les nœuds du cluster. Un seul lien CLAG gérera à la fois le trafic client et serveur.

Sur l’adresse IP du cluster, exécutez les commandes suivantes pour créer le groupe CLAG (Cluster Link Aggrégation) illustré à la Figure 1 :

Commande :

> set interface 0/40/[1-4] -lacpMode active -lacpKey 5 -lagType Cluster

> set interface 1/40/[1-4] -lacpMode active -lacpKey 5 -lagType Cluster

> set interface 2/40/[1-4] -lacpMode active -lacpKey 5 -lagType Cluster

> set interface 3/40/[1-4] -lacpMode active -lacpKey 5 -lagType Cluster

Configurez l’agrégation de liens dynamiques sur les commutateurs externes.

Activez ensuite la redondance des liens comme suit :

Code :

> set channel CLA/1 -linkRedundancy ON -lrMinThroughput 240000

Enfin, vérifiez l’état de la chaîne en entrant :

Commande :

> show channel CLA/1

Le canal doit être UP et le débit réel devrait être 320000.

Pour plus d’informations sur l’agrégation de liens de clusters, consultez les rubriques suivantes :

Parce que nous allons utiliser le transfert basé sur Mac (MBF), configurez un jeu de liens et le lier au groupe CLAG comme suit :

Commande :

> add linkset LS/1

> bind linkset LS/1 -ifnum CLA/1

Pour plus d’informations sur les jeux de liens, consultez les rubriques suivantes :

Configuration du VLAN et des adresses IP

Nous utiliserons la configuration IP par bandes, ce qui signifie que les adresses IP sont actives sur tous les nœuds (paramètre par défaut). Voir Configurations rayées, partiellement rayées et tachetées pour plus d’informations sur cette rubrique.

-

Ajouter les SNIP d’entrée et de sortie :

Commande :

> add ns ip 172.16.30.254 255.255.255.0 –type SNIP > add ns ip 172.16.31.254 255.255.255.0 –type SNIP > add ns ip6 fd00:172:16:30::254/112 –type SNIP > add ns ip6 fd00:172:16:31::254/112 –type SNIP -

Ajoutez les VLAN d’entrée et de sortie correspondants :

Commande :

> add vlan 30 -aliasName wireless > add vlan 31 -aliasName internet -

Liez des VLAN avec des adresses IP et un jeu de liens :

Commande :

> bind vlan 31 -ifnum LS/1 -tagged > bind vlan 30 -ifnum LS/1 -tagged > bind vlan 30 -IPAddress 172.16.30.254 255.255.255.0 > bind vlan 31 -IPAddress 172.16.31.254 255.255.255.0 > bind vlan 30 -IPAddress fd00:172:16:30::254/112 > bind vlan 31 -IPAddress fd00:172:16:31::254/112

Plus de VLAN d’entrée et de sortie peuvent être ajoutés si nécessaire.

Configuration de l’optimisation TCP

À ce stade, nous avons appliqué toutes les commandes spécifiques au cluster. Pour terminer la configuration, suivez les étapes décrites dans Configuration de l’optimisation TCP.

Configuration du routage dynamique

Un cluster NetScaler peut être intégré à l’environnement de routage dynamique du réseau du client. Vous trouverez ci-dessous un exemple de configuration de routage dynamique utilisant le protocole de routage BGP (l’OSPF est également pris en charge).

-

À partir de l’adresse CLIP, activez le BGP et le routage dynamique sur les adresses IP d’entrée et de sortie :

Commande :

> enable ns feature bgp > set ns ip 172.16.30.254 –dynamicRouting ENABLED > set ns ip 172.16.31.254 –dynamicRouting ENABLED -

Ouvrez vtysh et configurez BGP pour le côté sortie :

Code :

> shell root@ns# vtysh ns# configure terminal ns(config)# router bgp 65531 ns(config-router)# network 10.0.0.0/24 ns(config-router)# neighbor 172.16.31.100 remote-as 65530 ns(config-router)# neighbor 172.16.31.100 update-source 172.16.31.254 ns(config-router)# exit ns(config)# ns route-install propagate ns(config)# ns route-install default ns(config)# ns route-install bgp ns(config)# exit -

Configurez l’homologue BGP côté sortie pour annoncer la route par défaut vers le cluster NetScaler. Par exemple :

Commande :

router bgp 65530 bgp router-id 172.16.31.100 network 0.0.0.0/0 neighbor 172.16.31.254 remote-as 65531 -

Suivez les étapes similaires pour configurer le côté entrée.

-

À partir de vtysh, vérifiez que la configuration est propagée à tous les nœuds du cluster en saisissant :

Commande :

ns# show running-config -

Enfin, connectez-vous à l’adresse NSIP de chaque nœud de cluster et vérifiez les routes annoncées par le pair BGP :

Commande :

> show route | grep BGP