Einrichten der Kommunikation zwischen Knoten

Die Knoten in einem Cluster-Setup kommunizieren miteinander, indem sie die folgenden Kommunikationsmechanismen zwischen den Knoten verwenden:

- Knoten, die sich innerhalb des Netzwerks befinden (dasselbe Subnetz), kommunizieren über die Cluster-Backplane miteinander. Die Backplane muss explizit eingerichtet werden. Im Folgenden finden Sie die detaillierten Schritte.

- Netzwerkübergreifend erfolgt die Steuerung der Pakete über einen GRE-Tunnel, und die andere Kommunikation von Knoten zu Knoten wird je nach Bedarf über die Knoten geleitet.

Wichtig:

- Ab Version 11.0 aller Builds kann ein Cluster Knoten aus verschiedenen Netzwerken enthalten.

- Ab Version 13.0 Build 58.3 wird GRE-Steering auf Fortville-NICs in einem L3-Cluster unterstützt.

Gehen Sie für jeden Knoten wie folgt vor, um die Cluster-Backplane einzurichten

- Identifizieren Sie die Netzwerkschnittstelle, die Sie für die Backplane verwenden möchten.

- Schließen Sie ein Ethernet- oder optisches Kabel von der ausgewählten Netzwerkschnittstelle an den Cluster-Backplane-Switch an.

Um beispielsweise die Schnittstelle 1/2 als Backplane-Schnittstelle für Knoten 4 zu verwenden, schließen Sie ein Kabel von der 1/2-Schnittstelle von Knoten 4 an den Backplane-Switch an.

Wichtige Punkte, die beim Einrichten der Cluster-Backplane zu beachten sind

-

Verwenden Sie nicht die Verwaltungsschnittstelle (0/x) der Appliance als Backplane-Schnittstelle. In einem Cluster wird die Schnittstelle 0/1/x gelesen als:

0 -> Knoten-ID 0 1/x -> NetScaler-Schnittstelle

-

Verwenden Sie keine Backplane-Schnittstellen für die Client- oder Serverdatenebenen.

- Citrix empfiehlt, den Link Aggregat-Kanal (LA) für die Cluster-Backplane zu verwenden.

Hinweis:

Nachdem Sie die Bindung einer Schnittstelle vom LA-Kanal aufgehoben haben, stellen Sie sicher, dass Sie eine angemessene MTU-Größe für die ungebundene Schnittstelle festlegen.

-

In einem Cluster mit zwei Knoten, in dem die Rückwandplatine Back-to-back verbunden ist, ist der Cluster unter einer der folgenden Bedingungen operativ DOWN:

- Einer der Knoten wird neu gestartet.

- Die Backplane-Schnittstelle eines der Knoten ist deaktiviert.

Daher empfiehlt Citrix, dass Sie einen separaten Switch für die Backplane verwenden, damit der andere Clusterknoten und der Datenverkehr nicht beeinträchtigt werden. Sie können den Cluster nicht mit einem Back-to-Back-Link skalieren. Es kann zu Ausfallzeiten in der Produktionsumgebung kommen, wenn Sie die Clusterknoten skalieren.

-

Die Backplane-Schnittstellen aller Knoten eines Clusters müssen an denselben Switch angeschlossen und an dasselbe L2-VLAN gebunden sein.

-

Wenn Sie mehrere Cluster mit derselben Cluster-Instance-ID haben, stellen Sie sicher, dass die Backplane-Schnittstellen jedes Clusters an ein anderes VLAN gebunden sind.

-

Die Backplane-Schnittstelle wird immer überwacht, unabhängig von den HA-Monitoring-Einstellungen dieser Schnittstelle.

-

Der Zustand des MAC-Spoofings auf den verschiedenen Virtualisierungsplattformen kann sich auf den Steuerungsmechanismus auf der Cluster-Backplane auswirken. Stellen Sie daher sicher, dass der entsprechende Status konfiguriert ist:

- XenServer - MAC-Spoofing deaktivieren

- Hyper-V − MAC-Spoofing aktivieren

- VMware ESX − MAC-Spoofing aktivieren (stellen Sie außerdem sicher, dass “Forged Transmits” aktiviert ist)

-

Die MTU für die Cluster-Backplane wird automatisch aktualisiert. Wenn Jumbo-Frames jedoch auf dem Cluster konfiguriert sind, muss die MTU der Cluster-Backplane explizit konfiguriert werden. Der Wert muss auf 78 + X festgelegt werden, wobei X die maximale MTU der Client- und Serverdatenebenen ist. Zum Beispiel, wenn die MTU einer Serverdatenebene 7500 und der Client-Datenebene 8922 beträgt. Die MTU einer Cluster-Backplane muss auf 78 + 8922 = 9000 festgelegt werden. Verwenden Sie den folgenden Befehl, um diese MTU festzulegen:

> set interface <backplane_interface> -mtu <value> -

Die MTU für die Schnittstellen des Backplane-Switches muss größer oder gleich 1.578 Byte angegeben werden. Dies ist anwendbar, wenn der Cluster über Funktionen wie MBF, L2-Richtlinien, ACLs, Routing in CLAG-Bereitstellungen und vPath verfügt.

Hinweis:

Die Standard-MTU-Größe für eine Backplane-Schnittstelle ist 1578. Um die MTU-Größe auf den Standardwert zurückzusetzen, müssen Sie den

unset interface <backplane_interface> -mtuBefehl verwenden.

UDP-basierte Tunnelunterstützung für L2- und L3-Cluster

Ab NetScaler Version 13.0 Build 36.x können NetScaler L2- und L3-Cluster den Datenverkehr mithilfe von UDP-basiertem Tunneling steuern. Es ist für die Kommunikation zwischen den Knoten zwischen zwei Knoten in einem Cluster definiert. Mithilfe des Parameters “Tunnelmodus” können Sie den GRE- oder UDP-Tunnelmodus über den Befehl zum Hinzufügen und Festlegen von Clusterknoten festlegen.

In einer L3-Cluster-Bereitstellung werden Pakete zwischen NetScaler-Knoten über einen unverschlüsselten GRE-Tunnel ausgetauscht, der die NSIP-Adressen der Quell- und Zielknoten für das Routing verwendet. Wenn dieser Austausch über das Internet erfolgt und kein IPsec-Tunnel vorhanden ist, ist das NSIPs im Internet verfügbar, was zu Sicherheitsproblemen führen kann.

Wichtig:

Citrix empfiehlt Kunden, ihre eigene IPsec-Lösung einzurichten, wenn sie einen L3-Cluster verwenden.

Die folgende Tabelle hilft Ihnen dabei, die Tunnelunterstützung anhand verschiedener Bereitstellungen zu kategorisieren.

| Lenkungstypen | AWS | Microsoft Azure | Vor Ort |

|---|---|---|---|

| MAC | Nicht unterstützt | Nicht unterstützt | Unterstützt |

| GRE Tunnel | Unterstützt | Nicht unterstützt | Unterstützt |

| UDP-Tunnel | Unterstützt | Unterstützt | Unterstützt |

Wichtig:

In einem L3-Cluster ist der Tunnelmodus standardmäßig auf GRE eingestellt.

Konfiguration eines UDP-basierten Tunnels

Sie können einen Clusterknoten hinzufügen, indem Sie die Parameter der Knoten-ID festlegen und den Status angeben. Konfigurieren Sie die Backplane, indem Sie den Schnittstellennamen angeben, und wählen Sie den Tunnelmodus Ihrer Wahl (GRE oder UDP).

Hinweis:

Sie müssen den Tunnelmodus von der Cluster-IP-Adresse aus konfigurieren.

CLI-Verfahren

Um den UDP-Tunnelmodus mithilfe der CLI zu aktivieren.

Geben Sie in der Befehlszeile Folgendes ein:

add cluster node <nodeId>@ [-state <state>] [-backplane <interface_name>] [-tunnelmode <tunnelmode>]set cluster node <nodeId>@ [-state <state>] [-tunnelmode <tunnelmode>]

Hinweis:

Mögliche Werte für den Tunnelmodus sind NONE, GRE, UDP.

Beispiel

add cluster node 1 –state ACTIVE –backplane 1/1/1 -tunnelmode UDPset cluster node 1 –state ACTIVE –tunnelmode UDP

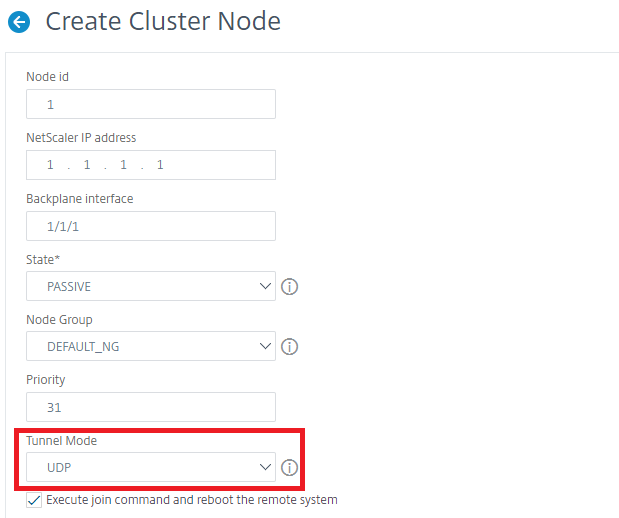

GUI-Verfahren

Um den UDP-Tunnelmodus mithilfe der GUI zu aktivieren.

-

Navigieren Sie zu System > Cluster > Knoten.

-

Klicken Sie auf der Seite Clusterknoten auf Hinzufügen.

-

Stellen Sie im Create Cluster Nodeden Parameter Tunnel Mode auf UDP ein und klicken Sie auf Create.

-

Klicken Sie auf Schließen.