-

-

Quelle est la place d'une appliance NetScaler dans le réseau ?

-

Comment un NetScaler communique avec les clients et les serveurs

-

Accélérez le trafic équilibré de charge en utilisant la compression

-

-

Solution native pour le cloud NetScaler

-

Déployer une instance NetScaler VPX

-

Optimisez les performances de NetScaler VPX sur VMware ESX, Linux KVM et Citrix Hypervisors

-

Améliorez les performances SSL-TPS sur les plateformes de cloud public

-

Configurer le multithreading simultané pour NetScaler VPX sur les clouds publics

-

Installation d'une instance NetScaler VPX sur un serveur bare metal

-

Installation d'une instance NetScaler VPX sur Citrix Hypervisor

-

Installation d'une instance NetScaler VPX sur le cloud VMware sur AWS

-

Installation d'une instance NetScaler VPX sur des serveurs Microsoft Hyper-V

-

Installation d'une instance NetScaler VPX sur la plateforme Linux-KVM

-

Provisioning de l'appliance virtuelle NetScaler à l'aide d'OpenStack

-

Provisioning de l'appliance virtuelle NetScaler à l'aide du Virtual Machine Manager

-

Configuration des appliances virtuelles NetScaler pour utiliser l'interface réseau SR-IOV

-

Configuration des appliances virtuelles NetScaler pour utiliser l'interface réseau PCI Passthrough

-

Provisioning de l'appliance virtuelle NetScaler à l'aide du programme virsh

-

Provisioning de l'appliance virtuelle NetScaler avec SR-IOV sur OpenStack

-

Déployer une instance NetScaler VPX sur AWS

-

Serveurs d'équilibrage de charge dans différentes zones de disponibilité

-

Déployer une paire HA VPX dans la même zone de disponibilité AWS

-

Haute disponibilité dans différentes zones de disponibilité AWS

-

Déployez une paire VPX haute disponibilité avec des adresses IP privées dans différentes zones AWS

-

Protégez AWS API Gateway à l'aide du pare-feu d'applications Web NetScaler

-

Configurer une instance NetScaler VPX pour utiliser l'interface réseau SR-IOV

-

Configurer une instance NetScaler VPX pour utiliser la mise en réseau améliorée avec AWS ENA

-

Déployer une instance NetScaler VPX sur Microsoft Azure

-

Architecture réseau pour les instances NetScaler VPX sur Microsoft Azure

-

Configurer plusieurs adresses IP pour une instance autonome NetScaler VPX

-

Configurer une configuration haute disponibilité avec plusieurs adresses IP et cartes réseau

-

Déployez une paire de haute disponibilité NetScaler sur Azure avec ALB en mode IP flottant désactivé

-

Configurer une instance NetScaler VPX pour utiliser le réseau accéléré Azure

-

Configurez les nœuds HA-INC à l'aide du modèle de haute disponibilité NetScaler avec Azure ILB

-

Installation d'une instance NetScaler VPX sur la solution Azure VMware

-

Configurer une instance autonome NetScaler VPX sur la solution Azure VMware

-

Configurer une configuration de haute disponibilité NetScaler VPX sur la solution Azure VMware

-

Configurer le serveur de routage Azure avec la paire NetScaler VPX HA

-

Ajouter des paramètres de mise à l'échelle automatique Azure

-

Configurer GSLB sur une configuration haute disponibilité active en veille

-

Configurer des pools d'adresses (IIP) pour un dispositif NetScaler Gateway

-

Scripts PowerShell supplémentaires pour le déploiement Azure

-

Déployer une instance NetScaler VPX sur Google Cloud Platform

-

Déployer une paire haute disponibilité VPX sur Google Cloud Platform

-

Déployer une paire VPX haute disponibilité avec des adresses IP privées sur Google Cloud Platform

-

Installation d'une instance NetScaler VPX sur Google Cloud VMware Engine

-

Support de dimensionnement VIP pour l'instance NetScaler VPX sur GCP

-

-

Automatisez le déploiement et les configurations de NetScaler

-

Solutions pour les fournisseurs de services de télécommunication

-

Trafic du plan de contrôle de l'équilibrage de charge basé sur les protocoles Diameter, SIP et SMPP

-

Utilisation de la bande passante avec la fonctionnalité de redirection du cache

-

Optimisation du protocole TCP avec NetScaler

-

-

Authentification, autorisation et audit du trafic des applications

-

Fonctionnement de l'authentification, de l'autorisation et de l'audit

-

Composants de base de la configuration de l'authentification, de l'autorisation et de l'audit

-

-

Autorisation de l'accès des utilisateurs aux ressources de l'application

-

NetScaler en tant que proxy du service de fédération Active Directory

-

NetScaler Gateway sur site en tant que fournisseur d'identité pour Citrix Cloud

-

Prise en charge de la configuration de l'attribut de cookie SameSite

-

Résoudre les problèmes liés à l'authentification et à l'autorisation

-

-

-

-

Configuration de l'expression de stratégie avancée : mise en route

-

Expressions de stratégie avancées : utilisation des dates, des heures et des nombres

-

Expressions de stratégie avancées : analyse des données HTTP, TCP et UDP

-

Expressions de stratégie avancées : analyse des certificats SSL

-

Expressions de stratégie avancées : adresses IP et MAC, débit, ID VLAN

-

Expressions de stratégie avancées : fonctions d'analyse de flux

-

-

-

-

Protection basée sur la grammaire SQL pour les charges utiles HTML et JSON

-

Protection basée sur la grammaire par injection de commandes pour la charge utile HTML

-

Règles de relaxation et de refus pour la gestion des attaques par injection HTML SQL

-

Prise en charge du pare-feu d'application pour Google Web Toolkit

-

Vérifications de protection XML

-

Articles sur les alertes de signatures

-

-

Traduire l'adresse IP de destination d'une requête vers l'adresse IP d'origine

-

-

Prise en charge de la configuration de NetScaler dans un cluster

-

-

-

Groupes de nœuds pour les configurations repérées et partiellement entrelacées

-

Désactivation de la direction sur le fond de panier du cluster

-

Suppression d'un nœud d'un cluster déployé à l'aide de l'agrégation de liens de cluster

-

Surveillance de la configuration du cluster à l'aide de la MIB SNMP avec lien SNMP

-

Surveillance des échecs de propagation des commandes dans un déploiement de cluster

-

Liaison d'interface VRRP dans un cluster actif à nœud unique

-

Scénarios de configuration et d'utilisation du cluster

-

Migration d'une configuration HA vers une configuration de cluster

-

Interfaces communes pour le client et le serveur et interfaces dédiées pour le fond de panier

-

Commutateur commun pour le client, le serveur et le fond de panier

-

Commutateur commun pour client et serveur et commutateur dédié pour fond de panier

-

Services de surveillance dans un cluster à l'aide de la surveillance des chemins

-

Opérations prises en charge sur des nœuds de cluster individuels

-

-

-

Configurer les enregistrements de ressources DNS

-

Créer des enregistrements MX pour un serveur d'échange de messagerie

-

Créer des enregistrements NS pour un serveur faisant autorité

-

Créer des enregistrements NAPTR pour le domaine des télécommunications

-

Créer des enregistrements PTR pour les adresses IPv4 et IPv6

-

Créer des enregistrements SOA pour les informations faisant autorité

-

Créer des enregistrements TXT pour contenir du texte descriptif

-

Configurer NetScaler en tant que résolveur de stubs non validant et sensible à la sécurité

-

Prise en charge des trames Jumbo pour le DNS pour gérer les réponses de grande taille

-

Configurer la mise en cache négative des enregistrements DNS

-

-

Équilibrage de charge de serveur global

-

Configurez les entités GSLB individuellement

-

Synchronisation de la configuration dans une configuration GSLB

-

Cas d'utilisation : déploiement d'un groupe de services Autoscale basé sur l'adresse IP

-

-

Remplacer le comportement de proximité statique en configurant les emplacements préférés

-

Configuration de la sélection des services GSLB à l'aide du changement de contenu

-

Configurer GSLB pour les requêtes DNS avec des enregistrements NAPTR

-

Exemple de configuration parent-enfant complète à l'aide du protocole d'échange de métriques

-

-

Équilibrer la charge du serveur virtuel et des états de service

-

Protection d'une configuration d'équilibrage de charge contre les défaillances

-

-

Configuration des serveurs virtuels d'équilibrage de charge sans session

-

Réécriture des ports et des protocoles pour la redirection HTTP

-

Insérer l'adresse IP et le port d'un serveur virtuel dans l'en-tête de requête

-

Utiliser une adresse IP source spécifiée pour la communication principale

-

Définir une valeur de délai d'expiration pour les connexions client inactives

-

Utiliser un port source d'une plage de ports spécifiée pour les communications en arrière-plan

-

Configurer la persistance de l'adresse IP source pour la communication principale

-

-

Paramètres d'équilibrage de charge avancés

-

Protégez les applications sur les serveurs protégés contre les pics de trafic

-

Activer le nettoyage des connexions de serveur virtuel et de service

-

Activer ou désactiver la session de persistance sur les services TROFS

-

Activer la vérification de l'état TCP externe pour les serveurs virtuels UDP

-

Maintenir la connexion client pour plusieurs demandes client

-

Utiliser l'adresse IP source du client lors de la connexion au serveur

-

Définissez une limite sur le nombre de demandes par connexion au serveur

-

Définir une valeur de seuil pour les moniteurs liés à un service

-

Définir une valeur de délai d'attente pour les connexions client inactives

-

Définir une valeur de délai d'attente pour les connexions de serveur inactives

-

Définir une limite sur l'utilisation de la bande passante par les clients

-

Conserver l'identificateur VLAN pour la transparence du VLAN

-

Configurer les moniteurs dans une configuration d'équilibrage de charge

-

Configurer l'équilibrage de charge pour les protocoles couramment utilisés

-

Cas d'utilisation 3 : configurer l'équilibrage de charge en mode de retour direct du serveur

-

Cas d'utilisation 4 : Configuration des serveurs LINUX en mode DSR

-

Cas d'utilisation 5 : configurer le mode DSR lors de l'utilisation de TOS

-

Cas d'utilisation 7 : Configurer l'équilibrage de charge en mode DSR à l'aide d'IP sur IP

-

Cas d'utilisation 8 : Configurer l'équilibrage de charge en mode à un bras

-

Cas d'utilisation 9 : Configurer l'équilibrage de charge en mode en ligne

-

Cas d'utilisation 10 : Équilibrage de charge des serveurs de systèmes de détection d'intrusion

-

Cas d'utilisation 11 : Isolation du trafic réseau à l'aide de stratégies d'écoute

-

Cas d'utilisation 12 : configurer Citrix Virtual Desktops pour l'équilibrage de charge

-

Cas d'utilisation 14 : Assistant ShareFile pour l'équilibrage de charge Citrix ShareFile

-

Cas d'utilisation 15 : configurer l'équilibrage de charge de couche 4 sur l'appliance NetScaler

-

-

-

Configuration pour générer le trafic de données NetScaler FreeBSD à partir d'une adresse SNIP

-

-

Déchargement et accélération SSL

-

Prise en charge du protocole TLSv1.3 tel que défini dans la RFC 8446

-

Matrice de prise en charge des certificats de serveur sur l'appliance ADC

-

Prise en charge du module de sécurité matérielle Thales Luna Network

-

-

-

Authentification et autorisation pour les utilisateurs système

-

Configuration des utilisateurs, des groupes d'utilisateurs et des stratégies de commande

-

Réinitialisation du mot de passe administrateur par défaut (nsroot)

-

Configuration de l'authentification des utilisateurs externes

-

Authentification basée sur une clé SSH pour les administrateurs NetScaler

-

Authentification à deux facteurs pour les utilisateurs système

-

-

-

Points à prendre en compte pour une configuration haute disponibilité

-

Synchronisation des fichiers de configuration dans une configuration haute disponibilité

-

Restriction du trafic de synchronisation haute disponibilité vers un VLAN

-

Configuration de nœuds haute disponibilité dans différents sous-réseaux

-

Limitation des basculements causés par les moniteurs de routage en mode non INC

-

Gestion des messages Heartbeat à haute disponibilité sur une appliance NetScaler

-

Supprimer et remplacer un NetScaler dans une configuration de haute disponibilité

-

This content has been machine translated dynamically.

Dieser Inhalt ist eine maschinelle Übersetzung, die dynamisch erstellt wurde. (Haftungsausschluss)

Cet article a été traduit automatiquement de manière dynamique. (Clause de non responsabilité)

Este artículo lo ha traducido una máquina de forma dinámica. (Aviso legal)

此内容已经过机器动态翻译。 放弃

このコンテンツは動的に機械翻訳されています。免責事項

이 콘텐츠는 동적으로 기계 번역되었습니다. 책임 부인

Este texto foi traduzido automaticamente. (Aviso legal)

Questo contenuto è stato tradotto dinamicamente con traduzione automatica.(Esclusione di responsabilità))

This article has been machine translated.

Dieser Artikel wurde maschinell übersetzt. (Haftungsausschluss)

Ce article a été traduit automatiquement. (Clause de non responsabilité)

Este artículo ha sido traducido automáticamente. (Aviso legal)

この記事は機械翻訳されています.免責事項

이 기사는 기계 번역되었습니다.책임 부인

Este artigo foi traduzido automaticamente.(Aviso legal)

这篇文章已经过机器翻译.放弃

Questo articolo è stato tradotto automaticamente.(Esclusione di responsabilità))

Translation failed!

Solution cloud native NetScaler pour les microservices basée sur Kubernetes

À mesure que les entreprises se transforment pour innover plus rapidement et se rapprocher de leurs clients, elles réorganisent leurs processus internes et éliminent les frontières au sein de leur organisation. Ils éliminent les silos pour rassembler les compétences appropriées au sein d’une même équipe. L’un des objectifs est de créer et de fournir des applications logicielles avec rapidité, agilité et efficacité. À cet égard, de plus en plus d’entreprises adoptent des architectures d’applications modernes basées sur des microservices. À l’aide d’une architecture de microservices, vous pouvez créer des applications sous la forme d’ensembles de services faiblement couplés qui peuvent être déployés, mis à jour et dimensionnés indépendamment.

Le cloud native est une approche qui repose sur l’architecture de microservices pour créer et déployer des applications présentant les caractéristiques clés suivantes :

- Déploie des applications sous forme de microservices ou de conteneurs faiblement couplés

- Implique un très haut degré d’automatisation

- Met en œuvre des processus DevOps agiles et des flux de travail de livraison continue

- Centré sur les API pour l’interaction et la collaboration

Comment Kubernetes contribue-t-il à la transition vers le cloud natif ?

Pour fournir les niveaux d’agilité et de stabilité souhaités, les applications cloud natives nécessitent des niveaux élevés d’automatisation, de sécurité, de mise en réseau et de surveillance de l’infrastructure. Vous avez besoin d’un système d’orchestration de conteneurs capable de gérer efficacement les conteneurs à grande échelle. Kubernetes est devenue la plate-forme la plus populaire pour le déploiement et l’orchestration de conteneurs. Kubernetes résume la tâche complexe d’exécution, de déploiement et de gestion des conteneurs des développeurs et des opérateurs et planifie automatiquement les conteneurs entre un cluster de nœuds. Kubernetes et l’écosystème de la Cloud Native Computing Foundation (CNCF) vous aident à créer une plateforme pour des solutions cloud natives.

Voici certains des principaux avantages de l’utilisation de Kubernetes :

- Simplifie le déploiement des applications, qu’il s’agisse d’une infrastructure sur site, hybride ou dans un cloud public

- Accélère le développement et le déploiement d’applications

- Améliore l’agilité, la flexibilité et l’évolutivité des applications

Qu’est-ce que la solution cloud native de NetScaler ?

Pour optimiser les avantages de l’utilisation de Kubernetes en production, vous devez intégrer Kubernetes à plusieurs outils, à des composants provenant de fournisseurs et à code source ouvert. Garantir la fiabilité et la sécurité de leur application cloud native constitue un défi pour de nombreuses entreprises. En tant que fournisseur de NetScalers de pointe, NetScaler propose une solution native NetScaler cloud pour relever les défis d’un environnement de production Kubernetes.

La solution cloud native de NetScaler tire parti de la gestion avancée du trafic, de l’observabilité et des fonctionnalités de sécurité complètes de NetScalers pour garantir une fiabilité et une sécurité de niveau professionnel. Il peut fournir une visibilité complète sur le trafic des applications dans votre environnement Kubernetes, générer des commentaires immédiats et vous aider à obtenir des informations pertinentes sur les performances des applications.

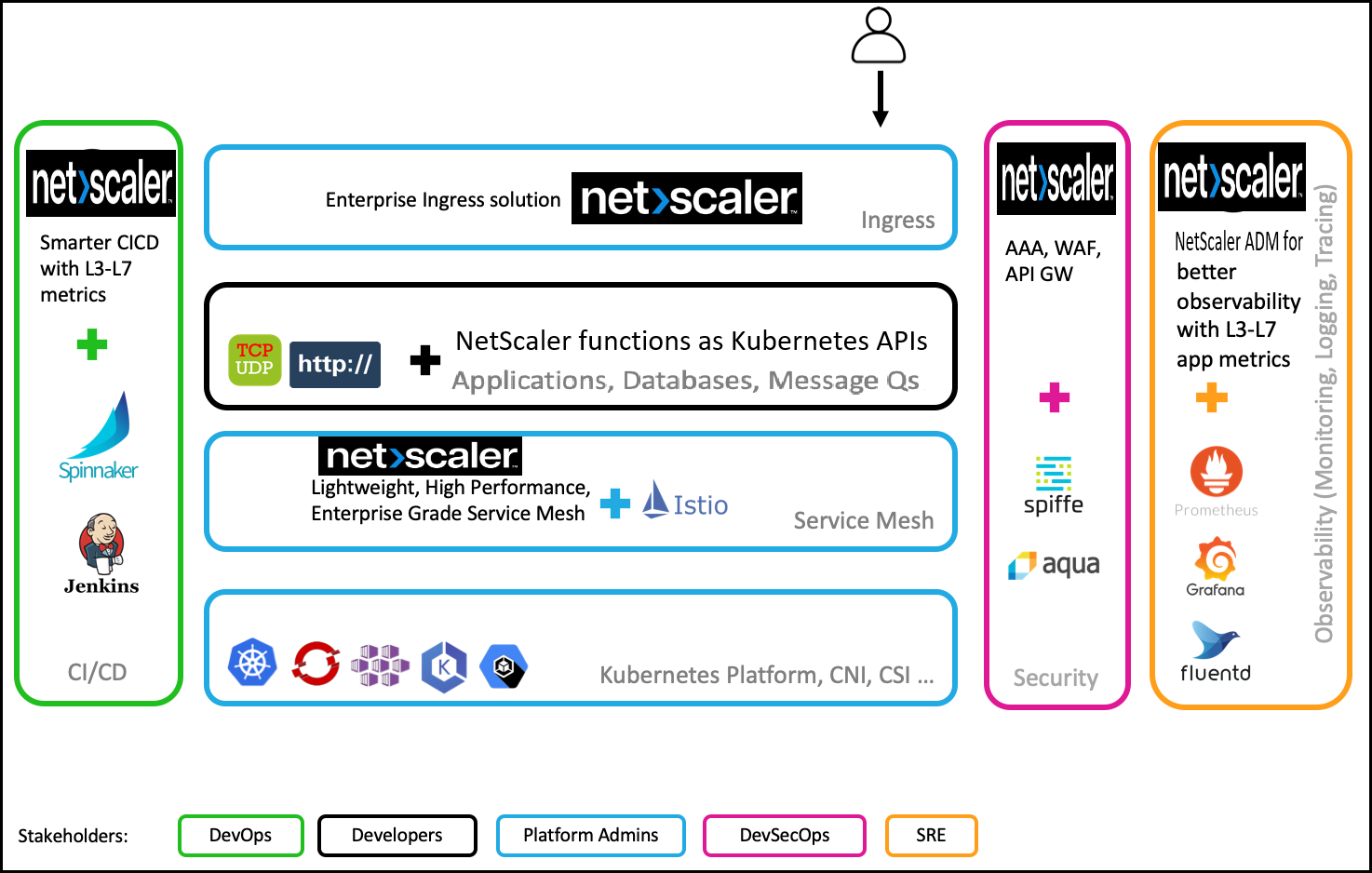

Le tableau suivant répertorie les principales exigences des différentes parties prenantes lors de la mise en œuvre d’une solution Ingress.

| Parties prenantes | Fonction du poste | Besoins |

|---|---|---|

| Administrateurs de la plateforme | Garantir la disponibilité des clusters Kubernetes | Des méthodes plus simples pour gérer les applications déployées sur plusieurs clusters, ainsi que pour la gestion des opérations et du cycle de vie des plateformes |

| DevOps | Accélérez le déploiement des applications en production | Intégration au pipeline CI/CD, prise en charge de techniques de déploiement telles que Canary et Blue-Green pour un déploiement plus rapide |

| Développeurs | Développez et testez des microservices | Méthodes d’acheminement du trafic vers le cluster Kubernetes, suivi et débogage, limitation du débit pour les applications et authentification des applications |

| SRE | Garantir la disponibilité des applications pour respecter les accords de niveau de service | Télémétrie avancée pour les applications et l’infrastructure |

| SecOps | Assurer la conformité en matière de sécurité | Trafic entrant sécurisé, protection des API, maillage de services pour une communication sécurisée entre les microservices au sein du cluster Kubernetes |

Le schéma suivant explique la solution cloud native de NetScaler et la manière dont elle répond aux différents défis auxquels sont confrontées les parties prenantes dans leur transition vers le cloud natif.

La solution cloud native de NetScaler offre les principaux avantages suivants :

- Fournit une solution Kubernetes Ingress avancée qui répond aux besoins des développeurs, des SRE, des DevOps et des administrateurs de réseaux ou de clusters.

- Élimine la nécessité de réécrire les applications existantes en fonction du trafic TCP ou UDP lors de leur migration vers un environnement Kubernetes.

- Sécurise les applications grâce aux stratégies NetScaler présentées sous forme d’API Kubernetes.

- Permet de déployer des microservices performants pour le trafic Nord-Sud et le trafic Est-Ouest.

- Fournit une vue tout-en-un de tous les microservices à l’aide du graphique de service de la console NetScaler.

- Permet un dépannage plus rapide des microservices sur différents types de trafic, notamment TCP, UDP, HTTP, HTTPS et SSL.

- Sécurise les API.

- Automatise le pipeline CI/CD pour les déploiements Canary.

- Fournit des intégrations prêtes à l’emploi avec les outils open source de la CNCF.

Pour plus d’informations sur les différentes solutions cloud natives proposées par Citrix, consultez les liens suivants :

- Solution Kubernetes Ingress

- Service mesh

- Solutions pour l’observabilité

- Passerelle API pour Kubernetes

Composants de la solution cloud native NetScaler

Le tableau suivant explique les principaux composants de la solution native cloud NetScaler :

| Composant | Description |

|---|---|

| Ingress Controller NetScaler | Ce conteneur est une implémentation du Kubernetes Ingress Controller pour gérer et acheminer le trafic vers votre cluster Kubernetes à l’aide de NetScalers (NetScaler CPX, VPX ou MPX). À l’aide de NetScaler Ingress Controller, vous pouvez configurer NetScaler CPX, VPX ou MPX conformément aux règles d’entrée et intégrer vos NetScalers à l’environnement Kubernetes. |

| Exportateur d’observabilité NetScaler | NetScaler Observability Exporter est un conteneur qui collecte des métriques et des transactions auprès de NetScalers et les transforme en formats adaptés (tels que JSON, AVRO) pour les terminaux pris en charge. Vous pouvez exporter les données collectées par NetScaler Observability Exporter vers le point de terminaison souhaité. En analysant les données exportées vers le terminal, vous pouvez obtenir des informations précieuses au niveau des microservices pour les applications fournies par proxy par NetScalers. |

| Adaptateur NetScaler xDS | L’adaptateur NetScaler xDS est un conteneur permettant d’intégrer NetScaler aux implémentations du plan de contrôle du maillage de services basées sur les API xDS (Istio, Consul, etc.). Il communique avec le plan de contrôle du maillage de service et écoute les mises à jour en agissant en tant que client gRPC pour le serveur API du plan de contrôle. Sur la base des mises à jour depuis le plan de contrôle, l’adaptateur NetScaler XDS génère la configuration NetScaler équivalente. |

| NetScaler CPX | NetScaler CPX est un contrôleur de diffusion d’applications basé sur des conteneurs qui peut être provisionné sur un hôte Docker. NetScaler CPX permet aux clients de tirer parti des fonctionnalités du moteur Docker et d’utiliser les fonctionnalités d’équilibrage de charge et de gestion du trafic NetScaler pour les applications basées sur des conteneurs. Vous pouvez déployer une ou plusieurs instances NetScaler CPX en tant qu’instances autonomes sur un hôte Docker. |

Partager

Partager

This Preview product documentation is Cloud Software Group Confidential.

You agree to hold this documentation confidential pursuant to the terms of your Cloud Software Group Beta/Tech Preview Agreement.

The development, release and timing of any features or functionality described in the Preview documentation remains at our sole discretion and are subject to change without notice or consultation.

The documentation is for informational purposes only and is not a commitment, promise or legal obligation to deliver any material, code or functionality and should not be relied upon in making Cloud Software Group product purchase decisions.

If you do not agree, select I DO NOT AGREE to exit.