-

-

Implementar una instancia de NetScaler VPX

-

Tabla de compatibilidad y pautas de uso

-

Optimice el rendimiento de NetScaler VPX en VMware ESX, Linux KVM y Citrix Hypervisors

-

Mejore el rendimiento de SSL-TPS en plataformas de nube pública

-

Configurar subprocesos múltiples simultáneos para NetScaler VPX en nubes públicas

-

Instalar una instancia de NetScaler VPX en un servidor desnudo

-

Instalar una instancia de NetScaler VPX en Citrix Hypervisor

-

Instalación de una instancia NetScaler VPX en la nube de VMware en AWS

-

Instalación de una instancia NetScaler VPX en servidores Microsoft Hyper-V

-

Instalar una instancia de NetScaler VPX en la plataforma Linux-KVM

-

Requisitos previos para instalar dispositivos virtuales NetScaler VPX en la plataforma Linux-KVM

-

Aprovisionamiento del dispositivo virtual NetScaler mediante OpenStack

-

Aprovisionamiento del dispositivo virtual NetScaler mediante Virtual Machine Manager

-

Configuración de dispositivos virtuales NetScaler para que usen la interfaz de red SR-IOV

-

Configuración de dispositivos virtuales NetScaler para que usen la interfaz de red PCI Passthrough

-

Aprovisionamiento del dispositivo virtual NetScaler mediante el programa virsh

-

Administración de las máquinas virtuales invitadas de NetScaler

-

Aprovisionamiento del dispositivo virtual NetScaler con SR-IOV en OpenStack

-

-

Implementar una instancia de NetScaler VPX en AWS

-

Configurar las funciones de IAM de AWS en la instancia de NetScaler VPX

-

Implementación de una instancia independiente NetScaler VPX en AWS

-

Servidores de equilibrio de carga en diferentes zonas de disponibilidad

-

Implementar un par de alta disponibilidad de VPX en la misma zona de disponibilidad de AWS

-

Alta disponibilidad en diferentes zonas de disponibilidad de AWS

-

Implementar un par de alta disponibilidad VPX con direcciones IP privadas en distintas zonas de AWS

-

Implementación de una instancia NetScaler VPX en AWS Outposts

-

Proteja AWS API Gateway mediante el firewall de aplicaciones web de Citrix

-

Configurar una instancia de NetScaler VPX para utilizar la interfaz de red SR-IOV

-

Configurar una instancia de NetScaler VPX para utilizar redes mejoradas con AWS ENA

-

Implementar una instancia de NetScaler VPX en Microsoft Azure

-

Arquitectura de red para instancias NetScaler VPX en Microsoft Azure

-

Configuración de varias direcciones IP para una instancia independiente NetScaler VPX

-

Configurar una configuración de alta disponibilidad con varias direcciones IP y NIC

-

Configurar una instancia de NetScaler VPX para usar redes aceleradas de Azure

-

Configure los nodos HA-INC mediante la plantilla de alta disponibilidad de NetScaler con Azure ILB

-

Instalación de una instancia NetScaler VPX en la solución Azure VMware

-

Configurar una instancia independiente de NetScaler VPX en la solución Azure VMware

-

Configurar una instalación de alta disponibilidad de NetScaler VPX en la solución Azure VMware

-

Configurar el servidor de rutas de Azure con un par de alta disponibilidad de NetScaler VPX

-

Configurar GSLB en una configuración de alta disponibilidad activa en espera

-

Configuración de grupos de direcciones (IIP) para un dispositivo NetScaler Gateway

-

Scripts de PowerShell adicionales para la implementación de Azure

-

Implementación de una instancia NetScaler VPX en Google Cloud Platform

-

Implementar un par de VPX de alta disponibilidad en Google Cloud Platform

-

Implementar un par de alta disponibilidad VPX con direcciones IP privadas en Google Cloud Platform

-

Instalar una instancia de NetScaler VPX en VMware Engine de Google Cloud

-

Compatibilidad con escalado VIP para la instancia NetScaler VPX en GCP

-

-

Automatizar la implementación y las configuraciones de NetScaler

-

-

Actualización y degradación de un dispositivo NetScaler

-

Consideraciones de actualización para configuraciones con directivas clásicas

-

Consideraciones sobre la actualización de archivos de configuración personalizados

-

Consideraciones sobre la actualización: Configuración de SNMP

-

Compatibilidad con actualización de software en servicio para alta disponibilidad

-

Soluciones para proveedores de servicios de telecomunicaciones

-

Equilibrio de carga del tráfico de plano de control basado en protocolos de diámetro, SIP y SMPP

-

Utilización del ancho de banda mediante la funcionalidad de redirección de caché

-

-

-

Autenticación, autorización y auditoría del tráfico de aplicaciones

-

Cómo funciona la autenticación, la autorización y la auditoría

-

Componentes básicos de la configuración de autenticación, autorización y auditoría

-

Autorización del acceso de los usuarios a los recursos de aplicaciones

-

NetScaler como proxy del servicio de federación de Active Directory

-

NetScaler Gateway local como proveedor de identidad de Citrix Cloud

-

Compatibilidad de configuración para el atributo de cookie SameSite

-

Configuración de autenticación, autorización y auditoría para protocolos de uso común

-

Solución de problemas relacionados con la autenticación y la autorización

-

-

-

-

Configuración de la expresión de directiva avanzada: Introducción

-

Expresiones de directivas avanzadas: trabajo con fechas, horas y números

-

Expresiones de directivas avanzadas: análisis de datos HTTP, TCP y UDP

-

Expresiones de directivas avanzadas: análisis de certificados SSL

-

Expresiones de directivas avanzadas: direcciones IP y MAC, rendimiento, ID de VLAN

-

Expresiones de directivas avanzadas: funciones de Stream Analytics

-

Ejemplos de tutoriales de directivas avanzadas para reescritura

-

-

-

Protecciones de nivel superior

-

Protección basada en gramática SQL para cargas útiles HTML y JSON

-

Protección basada en gramática por inyección de comandos para carga útil HTML

-

Reglas de relajación y denegación para gestionar ataques de inyección HTML SQL

-

Compatibilidad con palabras clave personalizadas para la carga útil HTML

-

Compatibilidad con firewall de aplicaciones para Google Web Toolkit

-

Comprobaciones de protección XML

-

-

-

Administrar un servidor virtual de redirección de caché

-

Ver estadísticas del servidor virtual de redirección de caché

-

Habilitar o inhabilitar un servidor virtual de redirección de caché

-

Resultados directos de directivas a la caché en lugar del origen

-

Realizar una copia de seguridad de un servidor virtual de redirección de caché

-

Habilitar la comprobación de estado TCP externa para servidores virtuales UDP

-

-

Traducir la dirección IP de destino de una solicitud a la dirección IP de origen

-

-

Descripción general del cluster

-

Administración del clúster de NetScaler

-

Grupos de nodos para configuraciones detectadas y parcialmente rayadas

-

Desactivación de la dirección en el plano posterior del clúster

-

Eliminar un nodo de un clúster implementado mediante la agregación de vínculos de clúster

-

Supervisión de la configuración del clúster mediante SNMP MIB con enlace SNMP

-

Supervisión de los errores de propagación de comandos en una implementación de clúster

-

Compatibilidad con logotipos preparados para IPv6 para clústeres

-

Enlace de interfaz VRRP en un clúster activo de un solo nodo

-

Casos de configuración y uso de clústeres

-

Migración de una configuración de HA a una configuración de clúster

-

Interfaces comunes para cliente y servidor e interfaces dedicadas para backplane

-

Conmutador común para cliente y servidor y conmutador dedicado para placa posterior

-

Supervisar servicios en un clúster mediante la supervisión de rutas

-

-

Configurar NetScaler como un solucionador de stubs con reconocimiento de seguridad no validante

-

Compatibilidad con tramas gigantes para DNS para gestionar respuestas de grandes tamaños

-

Configurar el almacenamiento en caché negativo de los registros DNS

-

-

Estado de servicio y servidor virtual de equilibrio de carga

-

Insertar atributos de cookie a las cookies generadas por ADC

-

Proteja una configuración de equilibrio de carga contra fallos

-

Administrar el tráfico de clientes

-

Configurar servidores virtuales de equilibrio de carga sin sesión

-

Reescritura de puertos y protocolos para la redirección HTTP

-

Insertar la dirección IP y el puerto de un servidor virtual en el encabezado de solicitud

-

Utilizar una IP de origen especificada para la comunicación de back-end

-

Establecer un valor de tiempo de espera para las conexiones de cliente inactivas

-

Gestionar el tráfico de clientes en función de la velocidad de tráfico

-

Utilizar un puerto de origen de un rango de puertos especificado para la comunicación de back-end

-

Configurar la persistencia IP de origen para la comunicación back-end

-

-

Configuración avanzada de equilibrio de carga

-

Aumenta gradualmente la carga en un nuevo servicio con un inicio lento a nivel de servidor virtual

-

Proteger aplicaciones en servidores protegidos contra los picos de tráfico

-

Habilitar la limpieza de las conexiones de servicios y servidores virtuales

-

Habilitar o inhabilitar la sesión de persistencia en los servicios TROFS

-

Habilitar la comprobación de estado TCP externa para servidores virtuales UDP

-

Mantener la conexión de cliente para varias solicitudes de cliente

-

Insertar la dirección IP del cliente en el encabezado de solicitud

-

Utilizar la dirección IP de origen del cliente al conectarse al servidor

-

Configurar el puerto de origen para las conexiones del lado del servidor

-

Establecer un límite en el número de solicitudes por conexión al servidor

-

Establecer un valor de umbral para los monitores enlazados a un servicio

-

Establecer un valor de tiempo de espera para las conexiones de clientes inactivas

-

Establecer un valor de tiempo de espera para las conexiones de servidor inactivas

-

Establecer un límite en el uso del ancho de banda por parte de los clientes

-

Conservar el identificador de VLAN para la transparencia de VLAN

-

-

Configurar monitores en una configuración de equilibrio de carga

-

Configurar el equilibrio de carga para los protocolos de uso común

-

Caso de uso 3: Configurar el equilibrio de carga en modo de Direct Server Return

-

Caso de uso 6: Configurar el equilibrio de carga en modo DSR para redes IPv6 mediante el campo TOS

-

Caso de uso 7: Configurar el equilibrio de carga en modo DSR mediante IP sobre IP

-

Caso de uso 8: Configurar el equilibrio de carga en modo de un brazo

-

Caso de uso 9: Configurar el equilibrio de carga en modo en línea

-

Caso de uso 10: Equilibrio de carga de los servidores del sistema de detección de intrusiones

-

Caso de uso 11: Aislamiento del tráfico de red mediante directivas de escucha

-

Caso de uso 12: Configurar Citrix Virtual Desktops para el equilibrio de carga

-

Caso de uso 13: Configurar Citrix Virtual Apps and Desktops para equilibrar la carga

-

Caso de uso 14: Asistente de ShareFile para equilibrar la carga Citrix ShareFile

-

Caso práctico 15: Configurar el equilibrio de carga de capa 4 en el dispositivo NetScaler

-

-

Configurar para obtener el tráfico de datos NetScaler FreeBSD desde una dirección SNIP

-

-

Compatibilidad con protocolos TLSv1.3 tal como se define en RFC 8446

-

Matriz de compatibilidad de certificados de servidor en el dispositivo ADC

-

Compatibilidad con plataformas basadas en chip SSL Intel Coleto

-

Compatibilidad con el módulo de seguridad de hardware Thales Luna Network

-

-

-

-

Configuración de un túnel de CloudBridge Connector entre dos centros de datos

-

Configuración de CloudBridge Connector entre el centro de datos y la nube de AWS

-

Configuración de un túnel de CloudBridge Connector entre un centro de datos y Azure Cloud

-

Configuración del túnel CloudBridge Connector entre Datacenter y SoftLayer Enterprise Cloud

-

Diagnóstico y solución de problemas de túnel CloudBridge Connector

-

-

Puntos a tener en cuenta para una configuración de alta disponibilidad

-

Sincronizar archivos de configuración en una configuración de alta disponibilidad

-

Restricción del tráfico de sincronización de alta disponibilidad a una VLAN

-

Configuración de nodos de alta disponibilidad en distintas subredes

-

Limitación de las conmutaciones por error causadas por monitores de ruta en modo no INC

-

Configuración del conjunto de interfaces de conmutación por error

-

Administración de mensajes de latido de alta disponibilidad en un dispositivo NetScaler

-

Quitar y reemplazar un NetScaler en una configuración de alta disponibilidad

-

This content has been machine translated dynamically.

Dieser Inhalt ist eine maschinelle Übersetzung, die dynamisch erstellt wurde. (Haftungsausschluss)

Cet article a été traduit automatiquement de manière dynamique. (Clause de non responsabilité)

Este artículo lo ha traducido una máquina de forma dinámica. (Aviso legal)

此内容已经过机器动态翻译。 放弃

このコンテンツは動的に機械翻訳されています。免責事項

이 콘텐츠는 동적으로 기계 번역되었습니다. 책임 부인

Este texto foi traduzido automaticamente. (Aviso legal)

Questo contenuto è stato tradotto dinamicamente con traduzione automatica.(Esclusione di responsabilità))

This article has been machine translated.

Dieser Artikel wurde maschinell übersetzt. (Haftungsausschluss)

Ce article a été traduit automatiquement. (Clause de non responsabilité)

Este artículo ha sido traducido automáticamente. (Aviso legal)

この記事は機械翻訳されています.免責事項

이 기사는 기계 번역되었습니다.책임 부인

Este artigo foi traduzido automaticamente.(Aviso legal)

这篇文章已经过机器翻译.放弃

Questo articolo è stato tradotto automaticamente.(Esclusione di responsabilità))

Translation failed!

Tabla de compatibilidad y pautas de uso

En este documento se enumeran los diferentes hipervisores y funciones admitidos en una instancia de NetScaler VPX. El documento también describe sus pautas de uso y las limitaciones conocidas.

Instancia VPX en Citrix Hypervisor

| Versión de Citrix Hypervisor | SysID | Modelos VPX |

|---|---|---|

| 8.2 era compatible con 13.0 64.x y versiones posteriores, 8.0, 7.6, 7.1 | 450000 | VPX 10, VPX 25, VPX 200, VPX 1000, VPX 3000, VPX 5000, VPX 8000, VPX 10 G, VPX 15 G, VPX 25 G, VPX 40 G |

Instancia VPX en hipervisor VMware ESXi

Los siguientes modelos VPX con 450010 (Sys ID) son compatibles con las versiones de VMware ESX que se muestran en la tabla.

Modelos VPX: VPX 10, VPX 25, VPX 200, VPX 1000, VPX 3000, VPX 5000, VPX 8000, VPX 10G, VPX 15G, VPX 25G, VPX 40G y VPX 100G.

| versión ESXi | Fecha de lanzamiento de ESXi (AAA/MM/DD) | Número de compilación ESXi | Versión de NetScaler VPX |

|---|---|---|---|

| Actualización 2c de ESXi 8.0 | 2024/05/21 | 23825572 | Compilaciones 13.1-53.x y posteriores |

| Actualización 2b de ESXi 8.0 | 2024/02/29 | 23305546 | compilaciones 13.1-49.15 y 13.1-52.x y posteriores |

| Actualización 2 de ESXi 8.0 | 2023/09/21 | 22380479 | compilaciones 13.1-52.x y posteriores |

| Actualización 1 de ESXi 8.0 | 2023/04/18 | 21495797 | compilaciones 13.1-45.x y posteriores |

| ESXi 8.0c | 2023/03/30 | 21493926 | compilaciones 13.1-45.x y posteriores |

| ESXi 8.0 | 2022/10/11 | 20513097 | 13.1-42.x y versiones superiores |

| Actualización 3q de ESXi 7.0 | 2024/05/21 | 23794027 | Compilaciones 13.1-53.x y posteriores |

| Actualización 3p de ESXi 7.0 | 2024/03/05 | 23307199 | compilaciones 13.1-52.x y posteriores |

| Actualización 3o de ESXi 7.0 | 2023/09/28 | 22348816 | versiones 13.1-51.x y superiores |

| Actualización 3n de ESXi 7.0 | 2023/07/06 | 21930508 | Compilaciones 13.1-49.x y superiores |

| Actualización 3m de ESXi 7.0 | 2023/05/03 | 21686933 | Compilaciones 13.1-48.x y superiores |

| Actualización 3i de ESXi 7.0 | 2022/12/08 | 20842708 | versiones 13.1-37.x y superiores |

| ESXi 7.0, actualización 3f | 2022/07/12 | 20036589 | Compilaciones 13.1-33.x y superiores |

| Actualización 3D de ESXi 7.0 | 2022/03/29 | 19482537 | versiones 13.1-27.x y superiores |

| Actualización 3c de ESXi 7.0 | 2022/01/27 | 19193900 | 13.1-21.x y versiones superiores |

| Actualización 2d de ESX 7.0 | 2021/09/14 | 18538813 | Compilaciones 13.1-9.x y superiores |

| Actualización 2a de ESX 7.0 | 2021/04/29 | 17867351 | Compilaciones 13.1-4.x y superiores |

Nota:

La compatibilidad con cada parche de ESXi se valida en la versión de NetScaler VPX especificada en la tabla anterior y se aplica a todas las versiones superiores de la versión 13.1 de NetScaler VPX.

Instancia de VPX en Microsoft Hyper-V

| Versión Hyper-V | SysID | Modelos VPX |

|---|---|---|

| 2016, 2019 | 450020 | VPX 10, VPX 25, VPX 200, VPX 1000, VPX 3000 |

Instancia VPX en Nutanix AHV

NetScaler VPX es compatible con Nutanix AHV a través de la asociación Citrix Ready. Citrix Ready es un programa de socios tecnológicos que ayuda a los proveedores de software y hardware a desarrollar e integrar sus productos con la tecnología NetScaler para el espacio de trabajo digital, las redes y el análisis.

Para obtener más información sobre un método paso a paso para implementar una instancia de NetScaler VPX en Nutanix AHV, consulte Implementación de un NetScaler VPX en Nutanix AHV.

Soporte de terceros:

Si tiene algún problema con una integración específica de un tercero (Nutanix AHV) en un entorno de NetScaler, abra un incidente de soporte directamente con el socio externo (Nutanix).

Si el socio determina que el problema parece estar relacionado con NetScaler, puede ponerse en contacto con el soporte de NetScaler para obtener más ayuda. Un recurso técnico dedicado de los socios trabaja con el soporte de NetScaler hasta que se resuelva el problema.

Para obtener más información, consulte Preguntas frecuentes sobre el programa Citrix Ready Partner.

Instancia VPX en KVM genérico

| Versión KVM genérica | SysID | Modelos VPX |

|---|---|---|

| RHEL 7.6, RHEL 8.0, RHEL 9.3 | 450070

|

VPX 10, VPX 25, VPX 200, VPX 1000, VPX 3000, VPX 5000, VPX 8000, VPX 10 G, VPX 15 G. VPX 25G, VPX 40G, VPX 100G

|

| Ubuntu 16.04, Ubuntu 18.04, RHV 4.2 |

Puntos a tener en cuenta:

Tenga en cuenta los siguientes puntos al utilizar hipervisores KVM.

-

La instancia VPX está calificada para las versiones de versión de Hypervisor mencionadas en la tabla 1—4, y no para las versiones de parche de una versión. Sin embargo, se espera que la instancia VPX funcione sin problemas con las versiones de parches de una versión compatible. Si no es así, registre un caso de asistencia para solucionar problemas y depurar.

- Antes de utilizar RHEL 7.6, siga los pasos siguientes en el host KVM:

-

Modifique /etc/default/grub y agregue

"kvm_intel.preemption_timer=0"a la variableGRUB_CMDLINE_LINUX. -

Vuelva a generar grub.cfg con el comando

"# grub2-mkconfig -o /boot/grub2/grub.cfg". -

Reinicie el equipo host.

-

-

Antes de utilizar Ubuntu 18.04, siga los pasos siguientes en el host KVM:

- Modifique /etc/default/grub y agregue

"kvm_intel.preemption_timer=0"a la variableGRUB_CMDLINE_LINUX. - Vuelva a generar grub.cfg con el comando

"# grub-mkconfig -o /boot/grub/grub.cfg “. - Reinicie el equipo host.

- Modifique /etc/default/grub y agregue

Instancia VPX en AWS

| Versión AWS | SysID | Modelos VPX |

|---|---|---|

| N/D | 450040 | VPX 10, VPX 200, VPX 1000, VPX 3000, VPX 5000, VPX BYOL, VPX 8000, VPX 10G, VPX 15G y VPX 25G solo están disponibles con BYOL con tipos de instancia EC2 (C5, M5 y C5n) |

Nota:

La oferta VPX 25G no ofrece el rendimiento de 25 G de AWS, pero puede ofrecer una tasa de transacciones SSL más alta en comparación con la oferta VPX 15G.

Instancia VPX en Azure

| Versión Azure | SysID | Modelos VPX |

|---|---|---|

| N/D | 450020 | VPX 10, VPX 200, VPX 1000, VPX 3000, VPX 5000, VPX BYOL |

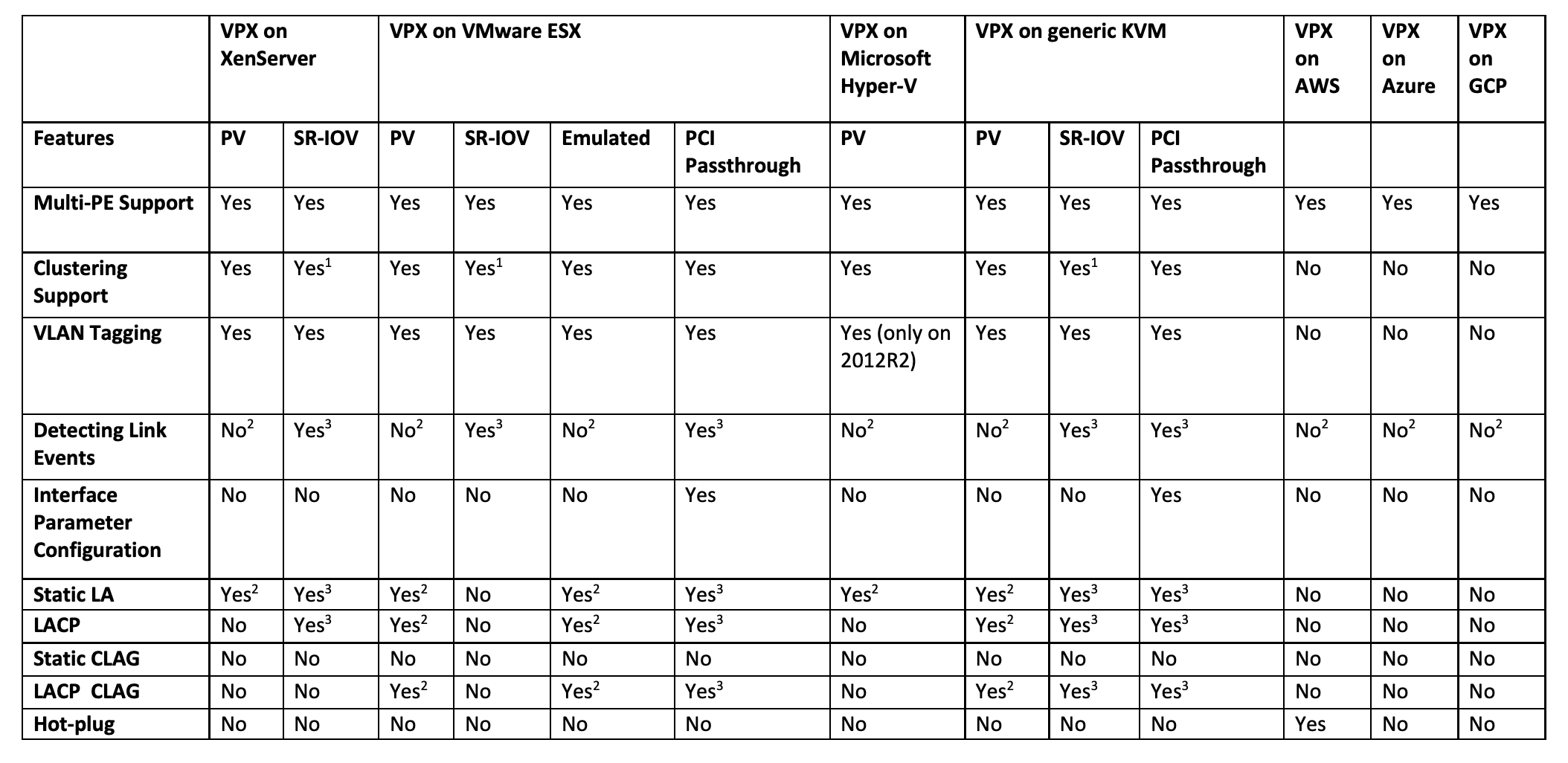

Matriz de funciones de VPX

Los números en superíndice (1, 2, 3) utilizados en la tabla anterior se refieren a los siguientes puntos con la numeración respectiva:

-

La compatibilidad con clústeres está disponible en SRIOV para las interfaces orientadas al cliente y al servidor, y no para el plano posterior.

-

Los eventos de interfaz DOWN no se registran en instancias de NetScaler VPX.

-

Para LA estática, es posible que aún se envíe tráfico en la interfaz cuyo estado físico sea DOWN.

-

Para LACP, el dispositivo del mismo nivel conoce el evento DOWN de la interfaz basado en el mecanismo de tiempo de espera de LACP.

- Tiempo de espera corto: 3 segundos

- Tiempo de espera prolongado: 90 segundos

-

En el caso de LACP, no comparta interfaces entre máquinas virtuales.

-

Para la redirección dinámica, el tiempo de convergencia depende del Protocolo de redirección, ya que no se detectan eventos de vínculo.

-

La funcionalidad Ruta estática supervisada falla si no vincula monitores a rutas estáticas porque el estado de la ruta depende del estado de la VLAN. El estado de la VLAN depende del estado del vínculo.

-

La detección de fallos parciales no se produce en alta disponibilidad si se produce un error de enlace. Una afección cerebral dividida de alta disponibilidad podría ocurrir si se produce un fallo de enlace.

-

Cuando se genera cualquier evento de enlace (desactivar/habilitar, restablecer) desde una instancia VPX, el estado físico del enlace no cambia. Para LA estática, cualquier tráfico iniciado por el par se elimina en la instancia.

-

Para que funcione la función de etiquetado de VLAN, haga lo siguiente:

En VMware ESX, establezca el ID de VLAN del grupo de puertos en 1-4095 en el vSwitch del servidor VMware ESX. Para obtener más información sobre la configuración de un ID de VLAN en el vSwitch del servidor VMware ESX, consulte Soluciones VLAN VMware ESX Server 3 802.1Q.

-

Exploradores web compatibles

| Sistema operativo | Explorador y versiones |

|---|---|

| Windows 7 | Internet Explorer: 8, 9, 10 y 11; Mozilla Firefox 3.6.25 y superior; Google Chrome: 15 y superior |

| Windows de 64 bits | Internet Explorer: 8, 9; Google Chrome: 15 y superior |

| MAC | Mozilla Firefox - 12 y superior; Safari - 5.1.3; Google Chrome: 15 y superior |

Compatibilidad con procesadores AMD para instancias de VPX

A partir de la versión 13.1 de NetScaler, la instancia de VPX admite los procesadores Intel y AMD. Los dispositivos virtuales VPX se pueden implementar en cualquier tipo de instancia que tenga dos o más núcleos virtualizados y más de 2 GB de memoria. Para obtener más información sobre los requisitos del sistema, consulte la hoja de datos de NetScaler VPX.

Plataformas VPX frente a Tabla matricial de NIC

La siguiente tabla muestra las NIC compatibles con una plataforma o nube VPX.

| Mellanox CX-3 | Mellanox CX-4 | Mellanox CX-5 | Intel 82599 SRIOV VF | Intel X710/X722/XL710 SRIOV VF | Modo de transferencia PCI Intel X710/XL710 | ||

|---|---|---|---|---|---|---|---|

| VPX (ESXi) | No | Sí | No | Sí | No | Sí | |

| VPX (Citrix Hypervisor) | NA | NA | NA | Sí | Sí | No | |

| VPX (KVM) | No | Sí | Sí | Sí | Sí | Sí | |

| VPX (Hyper-V) | NA | NA | NA | No | No | No | |

| VPX (AWS) | NA | NA | NA | Sí | NA | NA | |

| VPX (Azure) | Sí | Sí | Sí | NA | NA | NA | |

| VPX (GCP) | NA | NA | NA | NA | NA | NA | |

Directrices de uso

Siga estas pautas de uso:

- Le recomendamos que implemente una instancia VPX en los discos locales del servidor o en los volúmenes de almacenamiento basados en SAN.

Consulte la sección Consideraciones sobre la CPU de VMware ESXi en el documento Mejores prácticas de rendimiento para VMware vSphere 6.5. Aquí hay un extracto:

-

No se recomienda que las máquinas virtuales con una alta demanda de CPU o memoria se alojen en un host o clúster que esté sobrecomprometido.

-

En la mayoría de los entornos, ESXi permite niveles significativos de compromiso excesivo de CPU sin afectar el rendimiento de la máquina virtual. En un host, puede ejecutar más CPU virtuales que el número total de núcleos de procesador físicos de ese host.

-

Si un host ESXi se satura de la CPU, es decir, las máquinas virtuales y otras cargas del host exigen todos los recursos de CPU que tiene el host, las cargas de trabajo sensibles a la latencia podrían no funcionar bien. En este caso, es posible que quiera reducir la carga de la CPU, por ejemplo apagando algunas máquinas virtuales o migrándolas a un host diferente (o permitiendo que DRS las migre automáticamente).

-

Citrix recomienda la versión de compatibilidad de hardware más reciente para aprovechar los conjuntos de funciones más recientes del hipervisor ESXi para la máquina virtual. Para obtener más información sobre la compatibilidad de hardware y versiones de ESXi, consulte la documentación de VMware.

-

El NetScaler VPX es un dispositivo virtual de alto rendimiento y sensible a la latencia. Para ofrecer el rendimiento esperado, el dispositivo requiere reserva de CPU virtuales, reserva de memoria y fijación de vCPU en el host. Además, el hipersubproceso debe estar inhabilitado en el host. Si el host no cumple estos requisitos, se producen problemas como conmutación por error de alta disponibilidad, picos de CPU dentro de la instancia VPX, lentitud en el acceso a la CLI VPX, fallo del demonio de pit boss, caídas de paquetes y bajo rendimiento.

Un Hypervisor se considera sobreaprovisionado si se cumple una de las dos condiciones siguientes:

-

El número total de núcleos virtuales (CPU virtuales) aprovisionados en el host es mayor que el número total de núcleos físicos (CPU físicas).

-

El número total de máquinas virtuales aprovisionadas consume más CPU virtuales que el número total de CPU físicas.

Si una instancia está sobreaprovisionada, es posible que el hipervisor no garantice los recursos reservados (como CPU, memoria y otros) para la instancia debido a los gastos generales de programación del hipervisor, errores o limitaciones con el hipervisor. Este comportamiento puede provocar la falta de recursos de CPU para NetScaler y puede provocar los problemas mencionados en el primer punto de las Directrices de uso. Como administradores, se recomienda reducir el alquiler en el host para que el número total de CPU virtuales aprovisionadas en el host sea menor o igual al número total de CPU físicas.

Ejemplo

En el caso del hipervisor ESX, si el parámetro

%RDY%de una CPU virtual de VPX es mayor que 0 en el resultado del comandoesxtop, se dice que el host ESX tiene gastos generales de programación, lo que puede causar problemas relacionados con la latencia en la instancia VPX.En tal situación, reduzca la tenencia en el host para que

%RDY%siempre vuelva a 0. También puede ponerse en contacto con el proveedor del hipervisor para seleccionar el motivo por el que no se ha respetado la reserva de recursos realizada. - La adición en caliente solo se admite en las interfaces PV y SRIOV con NetScaler en AWS. Las instancias VPX con interfaces ENA no admiten conexión en marcha y el comportamiento de las instancias puede ser impredecible si se intenta conectar en caliente.

- La eliminación en caliente a través de la consola web de AWS o la interfaz CLI de AWS no se admite con las interfaces PV, SRIOV y ENA para NetScaler. El comportamiento de las instancias puede ser impredecible si se intenta eliminar en caliente.

Comandos para controlar el uso de la CPU del motor de paquetes

Puede utilizar dos comandos (set ns vpxparam y show ns vpxparam) para controlar el comportamiento de uso de CPU del motor de paquetes (no administrativo) de las instancias VPX en entornos de hipervisor y nube:

-

set ns vpxparam [-cpuyield (YES | NO | DEFAULT)] [-masterclockcpu1 (YES | NO)]Permitir que cada máquina virtual utilice recursos de CPU que se hayan asignado a otra máquina virtual pero que no se estén usando.

Set ns vpxparamparámetros:-cpuyield: Libere o no libere recursos de CPU asignados pero no utilizados.

-

SÍ: Permitir que otra máquina virtual utilice recursos de CPU asignados pero no utilizados.

-

NO: Reserve todos los recursos de CPU para la máquina virtual a la que se han asignado. Esta opción muestra un porcentaje más alto en entornos de hipervisores y nube para el uso de CPU VPX.

-

PREDETERMINADO: No.

Nota:

En todas las plataformas NetScaler VPX, el uso de CPU virtuales en el sistema host es del 100 por ciento. Escriba el comando

set ns vpxparam –cpuyield YESpara supeditar este uso.Si quiere configurar los nodos de clúster en “yield”, debe realizar las siguientes configuraciones adicionales en CCO:

- Si se forma un clúster, todos los nodos aparecen con “yield=Default”.

- Si se forma un clúster mediante los nodos que ya están configurados en “Yield=yes”, los nodos se agregan al clúster mediante el rendimiento “DEFAULT”.

Nota:

Si quiere establecer los nodos del clúster en “Yield=Sí”, puede configurarlos solo después de formar el clúster, pero no antes de que se forme el clúster.

-masterclockcpu1: Puede mover la fuente de reloj principal de la CPU0 (CPU de administración) a la CPU1. Este parámetro tiene las siguientes opciones:

-

SÍ: Permita que la VM mueva la fuente de reloj principal de la CPU0 a la CPU1.

-

NO: La máquina virtual utiliza CPU0 para la fuente de reloj principal. De forma predeterminada, CPU0 es la principal fuente de reloj.

-

-

show ns vpxparamMuestra los parámetros de

vpxparamactuales.

Otras referencias

-

Para obtener productos Citrix Ready, visite Citrix Ready Marketplace.

-

Para obtener asistencia sobre los productos Citrix Ready, consulte la página de preguntas frecuentes.

-

Para ver las versiones de hardware de VMware ESX, consulte Actualización de VMware Tools.

Compartir

Compartir

En este artículo

- Instancia VPX en Citrix Hypervisor

- Instancia VPX en hipervisor VMware ESXi

- Instancia de VPX en Microsoft Hyper-V

- Instancia VPX en Nutanix AHV

- Instancia VPX en KVM genérico

- Instancia VPX en AWS

- Instancia VPX en Azure

- Matriz de funciones de VPX

- Exploradores web compatibles

- Compatibilidad con procesadores AMD para instancias de VPX

- Plataformas VPX frente a Tabla matricial de NIC

- Directrices de uso

- Comandos para controlar el uso de la CPU del motor de paquetes

- Otras referencias

This Preview product documentation is Cloud Software Group Confidential.

You agree to hold this documentation confidential pursuant to the terms of your Cloud Software Group Beta/Tech Preview Agreement.

The development, release and timing of any features or functionality described in the Preview documentation remains at our sole discretion and are subject to change without notice or consultation.

The documentation is for informational purposes only and is not a commitment, promise or legal obligation to deliver any material, code or functionality and should not be relied upon in making Cloud Software Group product purchase decisions.

If you do not agree, select I DO NOT AGREE to exit.