-

-

Quelle est la place d'une appliance NetScaler dans le réseau ?

-

Comment un NetScaler communique avec les clients et les serveurs

-

Accélérez le trafic équilibré de charge en utilisant la compression

-

-

Déployer une instance NetScaler VPX

-

Optimisez les performances de NetScaler VPX sur VMware ESX, Linux KVM et Citrix Hypervisors

-

Prise en charge de l'augmentation de l'espace disque NetScaler VPX

-

Améliorez les performances SSL-TPS sur les plateformes de cloud public

-

Configurer le multithreading simultané pour NetScaler VPX sur les clouds publics

-

Installation d'une instance NetScaler VPX sur un serveur bare metal

-

Installation d'une instance NetScaler VPX sur Citrix Hypervisor

-

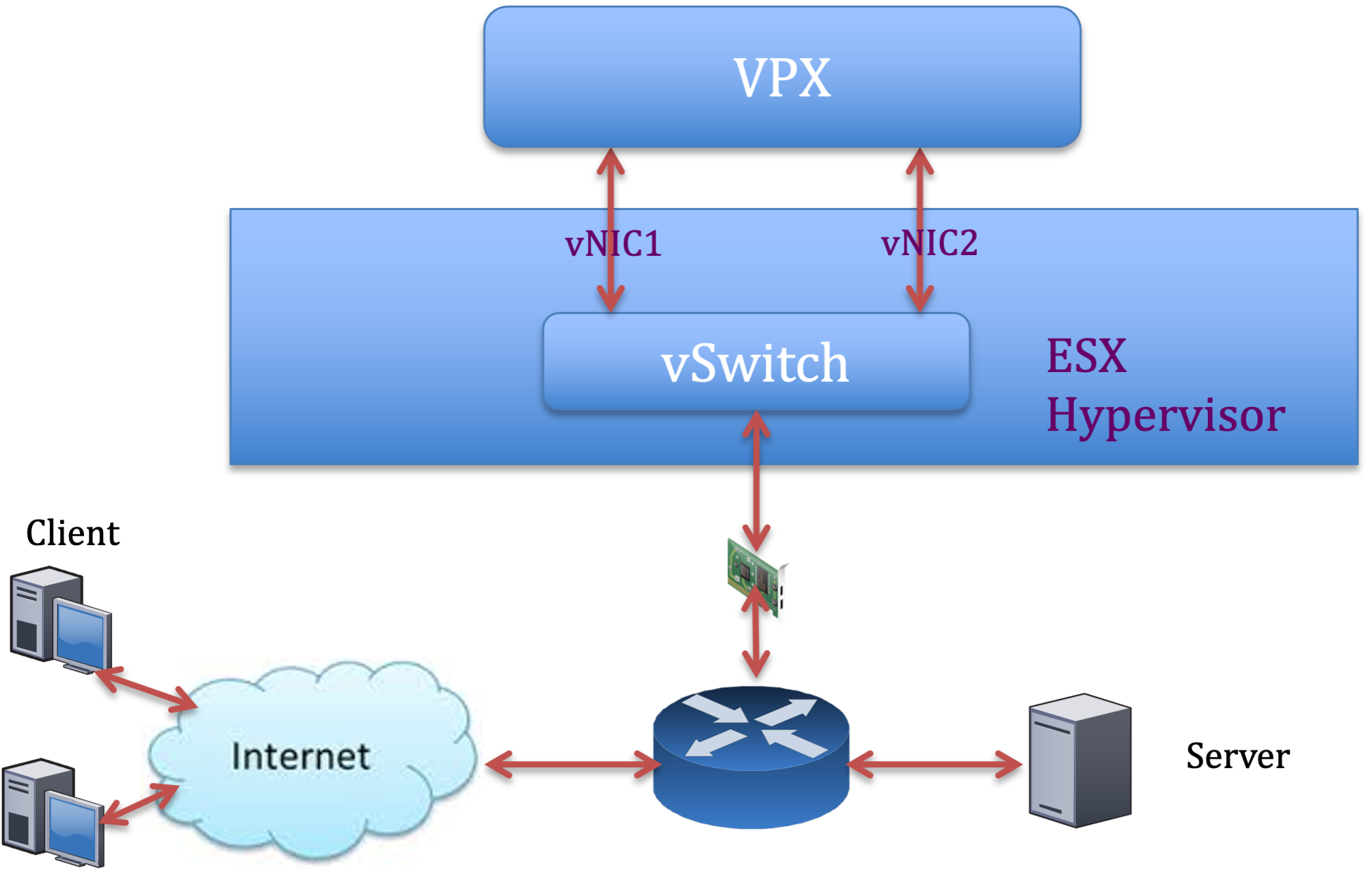

Installation d'une instance NetScaler VPX sur VMware ESX

-

Configurer NetScaler VPX pour utiliser l'interface réseau VMXNET3

-

Configurer NetScaler VPX pour utiliser l'interface réseau SR-IOV

-

Configurer NetScaler VPX pour utiliser Intel QAT pour l'accélération SSL en mode SR-IOV

-

Migration du NetScaler VPX de E1000 vers les interfaces réseau SR-IOV ou VMXNET3

-

Configurer NetScaler VPX pour utiliser l'interface réseau PCI passthrough

-

-

Installation d'une instance NetScaler VPX sur le cloud VMware sur AWS

-

Installation d'une instance NetScaler VPX sur des serveurs Microsoft Hyper-V

-

Installation d'une instance NetScaler VPX sur la plateforme Linux-KVM

-

Provisioning de l'appliance virtuelle NetScaler à l'aide d'OpenStack

-

Provisioning de l'appliance virtuelle NetScaler à l'aide du Virtual Machine Manager

-

Configuration des appliances virtuelles NetScaler pour utiliser l'interface réseau SR-IOV

-

Configuration des appliances virtuelles NetScaler pour utiliser l'interface réseau PCI Passthrough

-

Provisioning de l'appliance virtuelle NetScaler à l'aide du programme virsh

-

Provisioning de l'appliance virtuelle NetScaler avec SR-IOV sur OpenStack

-

Déployer une instance NetScaler VPX sur AWS

-

Serveurs d'équilibrage de charge dans différentes zones de disponibilité

-

Déployer une paire HA VPX dans la même zone de disponibilité AWS

-

Haute disponibilité dans différentes zones de disponibilité AWS

-

Déployez une paire VPX haute disponibilité avec des adresses IP privées dans différentes zones AWS

-

Protégez AWS API Gateway à l'aide du pare-feu d'applications Web NetScaler

-

Configurer une instance NetScaler VPX pour utiliser l'interface réseau SR-IOV

-

Configurer une instance NetScaler VPX pour utiliser la mise en réseau améliorée avec AWS ENA

-

Déployer une instance NetScaler VPX sur Microsoft Azure

-

Architecture réseau pour les instances NetScaler VPX sur Microsoft Azure

-

Configurer plusieurs adresses IP pour une instance autonome NetScaler VPX

-

Configurer une configuration haute disponibilité avec plusieurs adresses IP et cartes réseau

-

Déployez une paire de haute disponibilité NetScaler sur Azure avec ALB en mode IP flottant désactivé

-

Configurer une instance NetScaler VPX pour utiliser le réseau accéléré Azure

-

Configurez les nœuds HA-INC à l'aide du modèle de haute disponibilité NetScaler avec Azure ILB

-

Installation d'une instance NetScaler VPX sur la solution Azure VMware

-

Configurer une instance autonome NetScaler VPX sur la solution Azure VMware

-

Configurer une configuration de haute disponibilité NetScaler VPX sur la solution Azure VMware

-

Configurer le serveur de routage Azure avec la paire NetScaler VPX HA

-

Ajouter des paramètres de mise à l'échelle automatique Azure

-

Configurer GSLB sur une configuration haute disponibilité active en veille

-

Configurer des pools d'adresses (IIP) pour un dispositif NetScaler Gateway

-

Scripts PowerShell supplémentaires pour le déploiement Azure

-

Déployer une instance NetScaler VPX sur Google Cloud Platform

-

Déployer une paire haute disponibilité VPX sur Google Cloud Platform

-

Déployer une paire VPX haute disponibilité avec des adresses IP privées sur Google Cloud Platform

-

Installation d'une instance NetScaler VPX sur Google Cloud VMware Engine

-

Support de dimensionnement VIP pour l'instance NetScaler VPX sur GCP

-

-

Automatisez le déploiement et les configurations de NetScaler

-

Solutions pour les fournisseurs de services de télécommunication

-

Trafic du plan de contrôle de l'équilibrage de charge basé sur les protocoles Diameter, SIP et SMPP

-

Utilisation de la bande passante avec la fonctionnalité de redirection du cache

-

Optimisation du protocole TCP avec NetScaler

-

-

Authentification, autorisation et audit du trafic des applications

-

Fonctionnement de l'authentification, de l'autorisation et de l'audit

-

Composants de base de la configuration de l'authentification, de l'autorisation et de l'audit

-

-

Autorisation de l'accès des utilisateurs aux ressources de l'application

-

NetScaler en tant que proxy du service de fédération Active Directory

-

NetScaler Gateway sur site en tant que fournisseur d'identité pour Citrix Cloud

-

Prise en charge de la configuration de l'attribut de cookie SameSite

-

Résoudre les problèmes liés à l'authentification et à l'autorisation

-

-

-

-

Configurer une expression de stratégie avancée : pour démarrer

-

Expressions de stratégie avancées : utilisation de dates, d'heures et de chiffres

-

Expressions de stratégie avancées : analyse des données HTTP, TCP et UDP

-

Expressions de politique avancées : analyse des certificats SSL

-

Expressions de stratégie avancées : adresses IP et MAC, débit, identifiants VLAN

-

Expressions politiques avancées : fonctions d'analyse des flux

-

Exemples didacticiels de politiques avancées pour la réécriture

-

-

-

-

-

Protection basée sur la grammaire SQL pour les charges utiles HTML et JSON

-

Protection basée sur la grammaire par injection de commandes pour la charge utile HTML

-

Règles de relaxation et de refus pour la gestion des attaques par injection HTML SQL

-

Prise en charge du pare-feu d'application pour Google Web Toolkit

-

Vérifications de protection XML

-

Cas d'utilisation - Liaison de la stratégie Web App Firewall à un serveur virtuel VPN

-

Articles sur les alertes de signatures

-

-

Traduire l'adresse IP de destination d'une requête vers l'adresse IP d'origine

-

-

Prise en charge de la configuration de NetScaler dans un cluster

-

-

-

Groupes de nœuds pour les configurations repérées et partiellement entrelacées

-

Désactivation de la direction sur le fond de panier du cluster

-

Suppression d'un nœud d'un cluster déployé à l'aide de l'agrégation de liens de cluster

-

Surveillance de la configuration du cluster à l'aide de la MIB SNMP avec lien SNMP

-

Surveillance des échecs de propagation des commandes dans un déploiement de cluster

-

Liaison d'interface VRRP dans un cluster actif à nœud unique

-

Scénarios de configuration et d'utilisation du cluster

-

Migration d'une configuration HA vers une configuration de cluster

-

Interfaces communes pour le client et le serveur et interfaces dédiées pour le fond de panier

-

Commutateur commun pour le client, le serveur et le fond de panier

-

Commutateur commun pour client et serveur et commutateur dédié pour fond de panier

-

Services de surveillance dans un cluster à l'aide de la surveillance des chemins

-

Opérations prises en charge sur des nœuds de cluster individuels

-

-

-

Configurer les enregistrements de ressources DNS

-

Créer des enregistrements MX pour un serveur d'échange de messagerie

-

Créer des enregistrements NS pour un serveur faisant autorité

-

Créer des enregistrements NAPTR pour le domaine des télécommunications

-

Créer des enregistrements PTR pour les adresses IPv4 et IPv6

-

Créer des enregistrements SOA pour les informations faisant autorité

-

Créer des enregistrements TXT pour contenir du texte descriptif

-

Configurer NetScaler en tant que résolveur de stubs non validant et sensible à la sécurité

-

Prise en charge des trames Jumbo pour le DNS pour gérer les réponses de grande taille

-

Configurer la mise en cache négative des enregistrements DNS

-

Cas d'utilisation : configuration de la fonction de gestion automatique des clés DNSSEC

-

Cas d'utilisation : comment révoquer une clé active compromise

-

-

Équilibrage de charge de serveur global

-

Configurez les entités GSLB individuellement

-

Synchronisation de la configuration dans une configuration GSLB

-

Cas d'utilisation : déploiement d'un groupe de services Autoscale basé sur l'adresse IP

-

-

Remplacer le comportement de proximité statique en configurant les emplacements préférés

-

Configuration de la sélection des services GSLB à l'aide du changement de contenu

-

Configurer GSLB pour les requêtes DNS avec des enregistrements NAPTR

-

Exemple de configuration parent-enfant complète à l'aide du protocole d'échange de métriques

-

-

Équilibrer la charge du serveur virtuel et des états de service

-

Protection d'une configuration d'équilibrage de charge contre les défaillances

-

-

Configuration des serveurs virtuels d'équilibrage de charge sans session

-

Réécriture des ports et des protocoles pour la redirection HTTP

-

Insérer l'adresse IP et le port d'un serveur virtuel dans l'en-tête de requête

-

Utiliser une adresse IP source spécifiée pour la communication principale

-

Définir une valeur de délai d'expiration pour les connexions client inactives

-

Utiliser un port source d'une plage de ports spécifiée pour les communications en arrière-plan

-

Configurer la persistance de l'adresse IP source pour la communication principale

-

-

Paramètres d'équilibrage de charge avancés

-

Protégez les applications sur les serveurs protégés contre les pics de trafic

-

Activer le nettoyage des connexions de serveur virtuel et de service

-

Activer ou désactiver la session de persistance sur les services TROFS

-

Activer la vérification de l'état TCP externe pour les serveurs virtuels UDP

-

Maintenir la connexion client pour plusieurs demandes client

-

Utiliser l'adresse IP source du client lors de la connexion au serveur

-

Définissez une limite sur le nombre de demandes par connexion au serveur

-

Définir une valeur de seuil pour les moniteurs liés à un service

-

Définir une valeur de délai d'attente pour les connexions client inactives

-

Définir une valeur de délai d'attente pour les connexions de serveur inactives

-

Définir une limite sur l'utilisation de la bande passante par les clients

-

Conserver l'identificateur VLAN pour la transparence du VLAN

-

Configurer les moniteurs dans une configuration d'équilibrage de charge

-

Configurer l'équilibrage de charge pour les protocoles couramment utilisés

-

Cas d'utilisation 3 : configurer l'équilibrage de charge en mode de retour direct du serveur

-

Cas d'utilisation 4 : Configuration des serveurs LINUX en mode DSR

-

Cas d'utilisation 5 : configurer le mode DSR lors de l'utilisation de TOS

-

Cas d'utilisation 7 : Configurer l'équilibrage de charge en mode DSR à l'aide d'IP sur IP

-

Cas d'utilisation 8 : Configurer l'équilibrage de charge en mode à un bras

-

Cas d'utilisation 9 : Configurer l'équilibrage de charge en mode en ligne

-

Cas d'utilisation 10 : Équilibrage de charge des serveurs de systèmes de détection d'intrusion

-

Cas d'utilisation 11 : Isolation du trafic réseau à l'aide de stratégies d'écoute

-

Cas d'utilisation 12 : configurer Citrix Virtual Desktops pour l'équilibrage de charge

-

Cas d'utilisation 14 : Assistant ShareFile pour l'équilibrage de charge Citrix ShareFile

-

Cas d'utilisation 15 : configurer l'équilibrage de charge de couche 4 sur l'appliance NetScaler

-

-

-

Configuration pour générer le trafic de données NetScaler FreeBSD à partir d'une adresse SNIP

-

-

-

Déchargement et accélération SSL

-

Matrice de prise en charge des certificats de serveur sur l'appliance ADC

-

Prise en charge du module de sécurité matérielle Thales Luna Network

-

-

-

Authentification et autorisation pour les utilisateurs système

-

Configuration des utilisateurs, des groupes d'utilisateurs et des stratégies de commande

-

Réinitialisation du mot de passe administrateur par défaut (nsroot)

-

Configuration de l'authentification des utilisateurs externes

-

Authentification basée sur une clé SSH pour les administrateurs NetScaler

-

Authentification à deux facteurs pour les utilisateurs système

-

-

-

Points à prendre en compte pour une configuration haute disponibilité

-

Synchronisation des fichiers de configuration dans une configuration haute disponibilité

-

Restriction du trafic de synchronisation haute disponibilité vers un VLAN

-

Configuration de nœuds haute disponibilité dans différents sous-réseaux

-

Limitation des basculements causés par les moniteurs de routage en mode non INC

-

Gestion des messages Heartbeat à haute disponibilité sur une appliance NetScaler

-

Supprimer et remplacer un NetScaler dans une configuration de haute disponibilité

-

This content has been machine translated dynamically.

Dieser Inhalt ist eine maschinelle Übersetzung, die dynamisch erstellt wurde. (Haftungsausschluss)

Cet article a été traduit automatiquement de manière dynamique. (Clause de non responsabilité)

Este artículo lo ha traducido una máquina de forma dinámica. (Aviso legal)

此内容已经过机器动态翻译。 放弃

このコンテンツは動的に機械翻訳されています。免責事項

이 콘텐츠는 동적으로 기계 번역되었습니다. 책임 부인

Este texto foi traduzido automaticamente. (Aviso legal)

Questo contenuto è stato tradotto dinamicamente con traduzione automatica.(Esclusione di responsabilità))

This article has been machine translated.

Dieser Artikel wurde maschinell übersetzt. (Haftungsausschluss)

Ce article a été traduit automatiquement. (Clause de non responsabilité)

Este artículo ha sido traducido automáticamente. (Aviso legal)

この記事は機械翻訳されています.免責事項

이 기사는 기계 번역되었습니다.책임 부인

Este artigo foi traduzido automaticamente.(Aviso legal)

这篇文章已经过机器翻译.放弃

Questo articolo è stato tradotto automaticamente.(Esclusione di responsabilità))

Translation failed!

Optimisez les performances de NetScaler VPX sur VMware ESX, Linux KVM et Citrix Hypervisors

Les performances de NetScaler VPX varient considérablement en fonction de l’hyperviseur, des ressources système allouées et des configurations de l’hôte. Pour atteindre les performances souhaitées, suivez d’abord les recommandations de la fiche technique VPX, puis optimisez-la davantage en utilisant les meilleures pratiques fournies dans ce document.

Instance NetScaler VPX sur des hyperviseurs VMware ESX

Cette section contient des détails sur les options et les paramètres configurables, ainsi que d’autres suggestions qui vous aideront à optimiser les performances de l’instance NetScaler VPX sur les hyperviseurs VMware ESX.

- Configuration recommandée sur les hôtes ESX

- NetScaler VPX avec interfaces réseau E1000

- NetScaler VPX avec interfaces réseau VMXNET3

- NetScaler VPX avec interfaces réseau relais SR-IOV et PCI

Configuration recommandée sur les hôtes ESX

Pour obtenir des performances élevées pour VPX avec les interfaces réseau E1000, VMXNET3, SR-IOV et PCI passthrough, suivez ces recommandations :

- Le nombre total de processeurs virtuels (vCPU) provisionnés sur l’hôte ESX doit être inférieur ou égal au nombre total de processeurs physiques (PCPU) sur l’hôte ESX.

-

L’affinité NUMA (Non-Uniform Memory Access) et l’affinité CPU doivent être définies pour l’hôte ESX pour obtenir de bons résultats.

— Pour trouver l’affinité NUMA d’une Vmnic, connectez-vous à l’hôte localement ou à distance, et tapez :

#vsish -e get /net/pNics/vmnic7/properties | grep NUMA Device NUMA Node: 0 <!--NeedCopy-->- Pour définir l’affinité NUMA et vCPU pour une machine virtuelle, consultez la documentation VMware.

NetScaler VPX avec interfaces réseau E1000

Effectuez les paramètres suivants sur l’hôte VMware ESX :

- Sur l’hôte VMware ESX, créez deux cartes réseau virtuelles à partir d’un commutateur pNIC. Plusieurs vNIC créent plusieurs threads de réception (Rx) sur l’hôte ESX. Cela augmente le débit Rx de l’interface pNIC.

- Activez les VLAN au niveau du groupe de ports vSwitch pour chaque carte réseau virtuelle que vous avez créée.

- Pour augmenter le débit de transmission vNIC (Tx), utilisez un thread Tx distinct dans l’hôte ESX par vNIC. Utilisez la commande ESX suivante :

-

Pour ESX version 5.5 :

esxcli system settings advanced set –o /Net/NetTxWorldlet –i <!--NeedCopy--> -

Pour ESX version 6.0 et ultérieure :

esxcli system settings advanced set -o /Net/NetVMTxType –i 1 <!--NeedCopy-->

-

-

Pour augmenter encore le débit de la carte réseau vNIC Tx, utilisez un thread d’achèvement Tx et une file d’attente de threads Rx par périphérique (NIC) distincts. Utilisez la commande ESX suivante :

esxcli system settings advanced set -o /Net/NetNetqRxQueueFeatPairEnable -i 0 <!--NeedCopy-->

Remarque :

Assurez-vous de redémarrer l’hôte VMware ESX pour appliquer les paramètres mis à jour.

Deux cartes réseau virtuelles par déploiement de PNIC

Voici un exemple de commande de topologie et de configuration pour le modèle de déploiement de deux cartes réseau virtuelles par pNIC qui offre de meilleures performances réseau.

Exemple de configuration de NetScaler VPX :

Pour réaliser le déploiement illustré dans l’exemple de topologie précédent, effectuez la configuration suivante sur l’instance NetScaler VPX :

-

Côté client, liez le SNIP (1.1.1.2) à l’interface réseau 1/1 et activez le mode de balise VLAN.

bind vlan 2 -ifnum 1/1 –tagged bind vlan 2 -IPAddress 1.1.1.2 255.255.255.0 <!--NeedCopy--> -

Côté serveur, liez le SNIP (2.2.2.2) à l’interface réseau 1/1 et activez le mode de balise VLAN.

bind vlan 3 -ifnum 1/2 –tagged bind vlan 3 -IPAddress 2.2.2.2 255.255.255.0 <!--NeedCopy--> -

Ajoutez un serveur virtuel HTTP (1.1.1.100) et liez-le à un service (2.2.2.100).

add lb vserver v1 HTTP 1.1.1.100 80 -persistenceType NONE -Listenpolicy None -cltTimeout 180 add service s1 2.2.2.100 HTTP 80 -gslb NONE -maxClient 0 -maxReq 0 -cip DISABLED -usip NO -useproxyport YES -sp ON -cltTimeout 180 -svrTimeout 360 -CKA NO -TCPB NO -CMP NO bind lb vserver v1 s1 <!--NeedCopy-->

Remarque :

Assurez-vous d’inclure les deux entrées suivantes dans la table de routage :

- Sous-réseau 1.1.1.0/24 avec passerelle pointant vers SNIP 1.1.1.2

- Sous-réseau 2.2.2.0/24 avec passerelle pointant vers SNIP 2.2.2.2

NetScaler VPX avec interfaces réseau VMXNET3

Pour obtenir des performances élevées pour VPX avec les interfaces réseau VMXNET3, effectuez les paramètres suivants sur l’hôte VMware ESX :

- Créez deux vNIC à partir d’un commutateur virtuel PNIC. Plusieurs vNIC créent plusieurs threads Rx dans l’hôte ESX. Cela augmente le débit Rx de l’interface pNIC.

- Activez les VLAN au niveau du groupe de ports vSwitch pour chaque carte réseau virtuelle que vous avez créée.

- Pour augmenter le débit de transmission vNIC (Tx), utilisez un thread Tx distinct dans l’hôte ESX par vNIC. Utilisez les commandes ESX suivantes :

- Pour ESX version 5.5 :

esxcli system settings advanced set –o /Net/NetTxWorldlet –i <!--NeedCopy-->- Pour ESX version 6.0 et ultérieure :

esxcli system settings advanced set -o /Net/NetVMTxType –i 1 <!--NeedCopy-->

Sur l’hôte VMware ESX, effectuez la configuration suivante :

- Sur l’hôte VMware ESX, créez deux cartes réseau virtuelles à partir d’un vSwitch PNIC. Plusieurs vNIC créent plusieurs threads Tx et Rx dans l’hôte ESX. Cela augmente le débit Tx et Rx de l’interface pNIC.

- Activez les VLAN au niveau du groupe de ports vSwitch pour chaque carte réseau virtuelle que vous avez créée.

-

Pour augmenter le débit Tx d’une vNIC, utilisez un thread d’achèvement Tx et une file d’attente de threads Rx par périphérique (NIC) distincts. Utilisez la commande suivante :

esxcli system settings advanced set -o /Net/NetNetqRxQueueFeatPairEnable -i 0 <!--NeedCopy--> -

Configurez une machine virtuelle pour qu’elle utilise un thread de transmission par vNIC, en ajoutant le paramètre suivant à la configuration de la machine virtuelle :

ethernetX.ctxPerDev = "1" <!--NeedCopy--> -

Configurez une machine virtuelle pour utiliser jusqu’à 8 threads de transmission par vNIC, en ajoutant le paramètre suivant à la configuration de la machine virtuelle :

ethernetX.ctxPerDev = "3" <!--NeedCopy-->Remarque :

L’augmentation du nombre de threads de transmission par vNIC nécessite davantage de ressources CPU (jusqu’à 8) sur l’hôte ESX. Assurez-vous que des ressources CPU suffisantes sont disponibles avant de définir les paramètres précédents.

Pour plus d’informations, consultez la section Meilleures pratiques pour le réglage des performances des charges de travail Telco et NFV dans vSphere

Remarque :

Assurez-vous de redémarrer l’hôte VMware ESX pour appliquer les paramètres mis à jour.

Vous pouvez configurer VMXNET3 en tant que deux cartes réseau virtuelles par déploiement PNIC . Pour plus d’informations, consultez la section Deux cartes réseau virtuelles par déploiement de pNIC.

Configuration de la prise en charge des files d’attente multiples et du flux RSS sur les appareils VMware ESX pour VMXNET3

Par défaut, le périphérique VMXNET3 ne prend en charge que 8 files d’attente Rx et Tx. Lorsque le nombre de vCPU sur le VPX dépasse 8, le nombre de files d’attente Rx et Tx configurées pour une interface VMXNET3 passe à 1 par défaut. Vous pouvez configurer jusqu’à 19 files d’attente Rx et Tx pour les périphériques VMXNET3 en modifiant certaines configurations sur ESX. Cette option augmente les performances et la distribution uniforme des paquets sur les vCPU de l’instance VPX.

Remarque :

À partir de la version 13.1 build 48.x de NetScaler, le NetScaler VPX prend en charge jusqu’à 19 files d’attente Rx et Tx sur ESX pour les appareils VMXNET3.

Pré-requis :

Pour configurer jusqu’à 19 files d’attente Rx et Tx sur les appareils ESX pour VMXNET3, assurez-vous que les conditions préalables suivantes sont remplies :

- La version de NetScaler VPX est 13.1 build 48.X et versions ultérieures.

- NetScaler VPX est configuré avec une machine virtuelle de version matérielle 17 ou ultérieure, prise en charge par VMware ESX 7.0 et versions ultérieures.

Configurez les interfaces VMXNET3 pour prendre en charge plus de 8 files d’attente Rx et Tx :

- Ouvrez le fichier de configuration de la machine virtuelle (.vmx).

-

Spécifiez le nombre de files d’attente Rx et TX en configurant les valeurs

ethernetX.maxTxQueuesetethernetX.maxRxQueues(X étant le nombre de cartes réseau virtuelles à configurer). Le nombre maximum de files d’attente configurées ne doit pas être supérieur au nombre de vCPU de la machine virtuelle.Remarque :

L’augmentation du nombre de files d’attente augmente également la surcharge du processeur sur l’hôte ESX. Par conséquent, assurez-vous que des ressources CPU suffisantes sont disponibles sur l’hôte ESX avant d’augmenter les files d’attente. Vous pouvez augmenter le nombre maximum de files d’attente prises en charge, dans les scénarios où le nombre de files d’attente est considéré comme un obstacle aux performances. Dans ces situations, nous recommandons d’augmenter progressivement le nombre de files d’attente. Par exemple, de 8 à 12, puis à 16, puis à 20, et ainsi de suite. Évaluez les performances à chaque réglage, plutôt que de les augmenter directement jusqu’à la limite maximale.

NetScaler VPX avec interfaces réseau relais SR-IOV et PCI

Pour obtenir des performances élevées pour VPX avec des interfaces réseau SR-IOV et PCI passthrough, reportez-vous à la section Configuration recommandée sur les hôtes ESX.

Consignes d’utilisation de l’hyperviseur VMware ESXi

-

Nous vous recommandons de déployer une instance VPX sur les disques locaux du serveur ou sur des volumes de stockage SAN.

Consultez la section Considérations relatives au processeur VMware ESXi dans le document Meilleures pratiques en matière de performances pour VMware vSphere 6.5. Voici un extrait :

-

Il n’est pas recommandé de déployer des machines virtuelles sollicitant beaucoup de CPU ou de mémoire sur un hôte ou un cluster surchargé.

-

Dans la plupart des environnements, ESXi permet des niveaux significatifs de surcharge du processeur sans affecter les performances des machines virtuelles. Sur un hôte, vous pouvez exécuter plus de processeurs virtuels que le nombre total de cœurs de processeur physiques de cet hôte.

-

Si un hôte ESXi devient saturé en processeur, c’est-à-dire que les machines virtuelles et les autres charges sur l’hôte exigent toutes les ressources CPU dont dispose l’hôte, les charges de travail sensibles à la latence risquent de ne pas fonctionner correctement. Dans ce cas, réduisez la charge du processeur, par exemple, en éteignant certaines machines virtuelles ou en les migrant vers un autre hôte (ou en autorisant DRS à les migrer automatiquement).

-

NetScaler recommande d’utiliser la dernière version de compatibilité matérielle pour bénéficier des derniers ensembles de fonctionnalités de l’hyperviseur ESXi pour la machine virtuelle. Pour plus d’informations sur la compatibilité entre le matériel et les versions d’ESXi, consultez la documentation VMware.

-

Le NetScaler VPX est une appliance virtuelle haute performance sensible à la latence. Pour atteindre les performances attendues, l’appliance nécessite la réservation du processeur virtuel, la réservation de la mémoire et l’épinglage du processeur virtuel sur l’hôte. En outre, l’hyper thread doit être désactivé sur l’hôte. Si l’hôte ne répond pas à ces exigences, les problèmes suivants peuvent survenir :

- Basculement à haute disponibilité

- Pic de processeur au sein de l’instance VPX

- Lenteur lors de l’accès à la CLI VPX

- Crash du démon Pit Boss

- Gouttes de paquets

- Débit faible

-

Un Hypervisor est considéré comme surapprovisionné si l’une des deux conditions suivantes est remplie :

-

Le nombre total de cœurs virtuels (vCPU) provisionnés sur l’hôte est supérieur au nombre total de cœurs physiques (PCPU).

-

Le nombre total de machines virtuelles provisionnées consomme plus de vCPU que le nombre total de processeurs physiques.

Si une instance est surapprovisionnée, il se peut que l’hyperviseur ne garantisse pas les ressources réservées (telles que le processeur, la mémoire et autres) pour l’instance en raison des surcharges de planification de l’hyperviseur, des bogues ou des limitations avec l’hyperviseur. Ce comportement peut entraîner un manque de ressources CPU pour NetScaler et peut entraîner les problèmes mentionnés au premier point de la section Directives d’utilisation. Nous recommandons aux administrateurs de réduire la location de l’hôte afin que le nombre total de processeurs virtuels provisionnés sur l’hôte soit inférieur ou égal au nombre total de processeurs virtuels.

Exemple :

Pour l’hyperviseur ESX, si le paramètre

%RDY%d’un processeur virtuel VPX est supérieur à 0 dans la sortie de commandeesxtop, l’hôte ESX est réputé avoir des frais de planification, ce qui peut entraîner des problèmes liés à la latence pour l’instance VPX.Dans ce cas, réduisez la location sur l’hôte afin que

%RDY%revienne toujours à 0. Vous pouvez également contacter le fournisseur de l’hyperviseur pour déterminer les raisons pour lesquelles la réservation de ressources n’a pas été honorée.

-

Commandes pour contrôler l’utilisation du processeur du moteur de paquets

Vous pouvez utiliser deux commandes (set ns vpxparam et show ns vpxparam) pour contrôler le comportement d’utilisation du processeur du moteur de paquets (hors gestion) des instances VPX dans les environnements d’hyperviseur et de cloud :

-

set ns vpxparam [-cpuyield (YES | NO | DEFAULT)] [-masterclockcpu1 (YES | NO)]Autorisez chaque machine virtuelle à utiliser les ressources du processeur allouées à une autre machine virtuelle mais qui ne sont pas utilisées.

Paramètres

Set ns vpxparam:-cpuyield : libère ou ne libère pas des ressources CPU allouées mais inutilisées.

-

OUI : autorise l’utilisation des ressources CPU allouées mais inutilisées par une autre machine virtuelle.

-

NON : réservez toutes les ressources du processeur pour la machine virtuelle à laquelle elles ont été allouées. Cette option affiche un pourcentage plus élevé dans les environnements d’hyperviseur et de cloud pour l’utilisation du processeur VPX.

-

DEFAULT : Non.

Remarque :

Sur toutes les plateformes NetScaler VPX, l’utilisation du processeur virtuel sur le système hôte est de 100 %. Utilisez la commande

set ns vpxparam –cpuyield YESpour annuler cette utilisation.Si vous souhaitez définir les nœuds du cluster sur « rendement », vous devez effectuer les configurations supplémentaires suivantes sur CCO :

- Si un cluster est formé, tous les nœuds sont définis sur « YIELD=default ».

- Si un cluster est formé à l’aide des nœuds déjà définis sur « Yield=YES », les nœuds sont ajoutés au cluster en utilisant le rendement « DEFAULT ».

Remarque :

Si vous souhaitez définir les nœuds du cluster sur « YIELD=YES », vous pouvez configurer uniquement après la formation du cluster, mais pas avant la formation du cluster.

-masterclockcpu1 : Vous pouvez déplacer la source d’horloge principale de CPU0 (CPU de gestion) vers CPU1. Ce paramètre a les options suivantes :

-

OUI : Autorisez la machine virtuelle à déplacer la source d’horloge principale de CPU0 vers CPU1.

-

NON : VM utilise CPU0 pour la source d’horloge principale. Par défaut, CPU0 est la principale source d’horloge.

-

-

show ns vpxparamCette commande affiche les paramètres

vpxparamactuels.

Instance NetScaler VPX sur la plateforme Linux-KVM

Cette section contient des détails sur les options et paramètres configurables, ainsi que d’autres suggestions qui vous aideront à optimiser les performances de l’instance NetScaler VPX sur la plate-forme Linux-KVM.

- Paramètres de performance pour KVM

- NetScaler VPX avec interfaces réseau photovoltaïque

- NetScaler VPX avec interfaces réseau relais SR-IOV et Fortville PCIe

Paramètres de performance pour KVM

Effectuez les paramètres suivants sur l’hôte KVM :

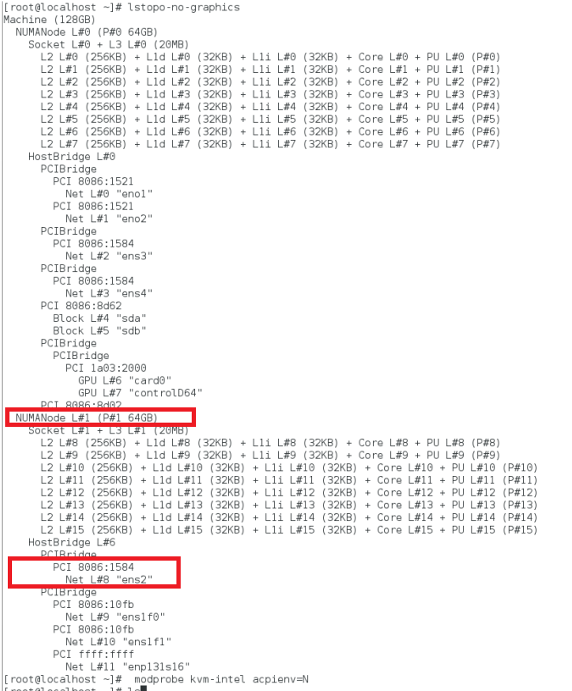

Recherchez le domaine NUMA de la carte réseau à l’aide de la lstopo commande :

Assurez-vous que la mémoire du VPX et du processeur est épinglée au même emplacement. Dans la sortie suivante, la carte réseau 10G « ens2” est liée au domaine NUMA #1.

Allouez la mémoire VPX du domaine NUMA.

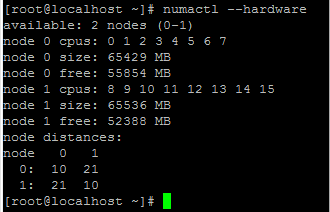

La numactl commande indique le domaine NUMA à partir duquel la mémoire est allouée. Dans la sortie suivante, environ 10 Go de RAM sont alloués à partir du nœud NUMA #0.

Pour modifier le mappage des nœuds NUMA, procédez comme suit.

-

Modifiez le .xml du VPX sur l’hôte.

/etc/libvirt/qemu/<VPX_name>.xml <!--NeedCopy--> -

Ajoutez la balise suivante :

<numatune> <memory mode="strict" nodeset="1"/> This is the NUMA domain name </numatune> <!--NeedCopy--> -

Arrêtez le VPX.

-

Exécutez la commande suivante :

virsh define /etc/libvirt/qemu/<VPX_name>.xml <!--NeedCopy-->Cette commande met à jour les informations de configuration de la machine virtuelle avec les mappages de nœuds NUMA.

-

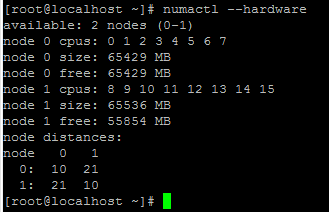

Mettez le VPX sous tension. Vérifiez ensuite la sortie de la

numactl –hardwarecommande sur l’hôte pour voir les allocations de mémoire mises à jour pour le VPX.

Épinglez les vCPU de VPX aux cœurs physiques.

-

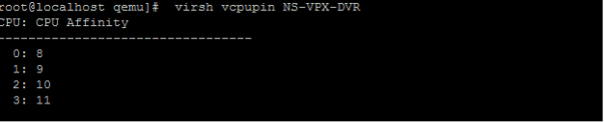

Pour afficher les mappages vCPU vers PCPU d’un VPX, tapez la commande suivante

virsh vcpupin <VPX name> <!--NeedCopy-->

Les vCPU 0—4 sont mappés sur les cœurs physiques 8 à 11.

-

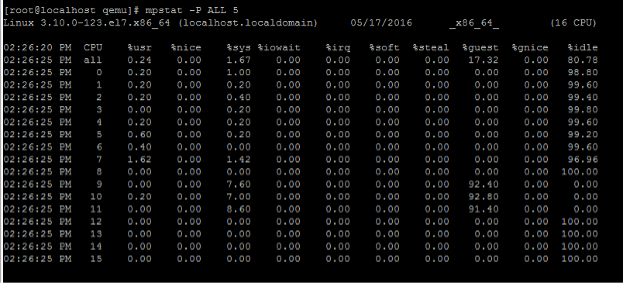

Pour afficher l’utilisation actuelle du PCPU, tapez la commande suivante :

mpstat -P ALL 5 <!--NeedCopy-->

Dans cette sortie, 8 correspond au processeur de gestion et 9 à 11 aux moteurs de paquets.

-

Pour changer le vCPU en épinglage PCPU, il existe deux options.

-

Modifiez-le au moment de l’exécution après le démarrage du VPX à l’aide de la commande suivante :

virsh vcpupin <VPX name> <vCPU id> <pCPU number> virsh vcpupin NetScaler-VPX-XML 0 8 virsh vcpupin NetScaler-VPX-XML 1 9 virsh vcpupin NetScaler-VPX-XML 2 10 virsh vcpupin NetScaler-VPX-XML 3 11 <!--NeedCopy--> -

Pour apporter des modifications statiques au VPX, modifiez le

.xmlfichier comme précédemment avec les balises suivantes :-

Modifiez le fichier .xml du VPX sur l’hôte

/etc/libvirt/qemu/<VPX_name>.xml <!--NeedCopy--> -

Ajoutez la balise suivante :

<vcpu placement='static' cpuset='8-11'>4</vcpu> <cputune> <vcpupin vcpu='0' cpuset='8'/> <vcpupin vcpu='1' cpuset='9'/> <vcpupin vcpu='2' cpuset='10'/> <vcpupin vcpu='3' cpuset='11'/> </cputune> <!--NeedCopy--> -

Arrêtez le VPX.

-

Mettez à jour les informations de configuration de la machine virtuelle avec les mappages de nœuds NUMA à l’aide de la commande suivante :

virsh define /etc/libvirt/qemu/ <VPX_name>.xml <!--NeedCopy--> -

Mettez le VPX sous tension. Vérifiez ensuite la sortie de la

virsh vcpupin <VPX name>commande sur l’hôte pour voir l’épinglage du processeur mis à jour.

-

-

Éliminez les frais généraux d’interruption de l’hôte.

-

Détectez VM_EXITS à l’aide de la

kvm_statcommande.Au niveau de l’hyperviseur, les interruptions de l’hôte sont mappées sur les mêmes processeurs sur lesquels les vCPU du VPX sont épinglés. Cela peut entraîner le retrait périodique des processeurs virtuels sur le VPX.

Pour trouver les sorties de machine virtuelle effectuées par les machines virtuelles exécutant l’hôte, utilisez la

kvm_statcommande.[root@localhost ~]# kvm_stat -1 | grep EXTERNAL kvm_exit(EXTERNAL_INTERRUPT) 1728349 27738 [root@localhost ~]# <!--NeedCopy-->Une valeur supérieure de l’ordre de 1+M indique un problème.

Si une seule machine virtuelle est présente, la valeur attendue est comprise entre 30 et 100 K. Tout ce qui dépasse peut indiquer qu’un ou plusieurs vecteurs d’interruption d’hôte sont mappés sur le même processeur.

-

Détectez les interruptions de l’hôte et migrez les interruptions de l’hôte.

Lorsque vous exécutez la

concatenatecommande pour le fichier « /proc/interrupts », elle affiche tous les mappages d’interruption de l’hôte. Si un ou plusieurs IRQ actifs sont mappés sur le même PCPU, le compteur correspondant est incrémenté.Déplacez toutes les interruptions qui se chevauchent avec les processeurs de votre NetScaler VPX vers les processeurs non utilisés :

echo 0000000f > /proc/irq/55/smp_affinity 0000000f - - > it is a bitmap, LSBs indicates that IRQ 55 can only be scheduled on pCPUs 0 – 3 <!--NeedCopy--> -

Désactivez la balance IRQ.

Désactivez le démon d’équilibrage de l’IRQ, de sorte qu’aucune replanification ne se produise à la volée.

service irqbalance stop service irqbalance show - To check the status service irqbalance start - Enable if needed <!--NeedCopy-->Assurez-vous d’exécuter la commande

kvm_statpour vous assurer qu’il n’y a pas beaucoup de compteurs.

NetScaler VPX avec interfaces réseau photovoltaïque

Vous pouvez configurer des interfaces réseau de para-virtualisation (PV), SR-IOV et PCIe passthrough en tant que déploiement de deux cartes réseau virtuelles par pNIC . Pour plus d’informations, consultez la section Deux cartes réseau virtuelles par déploiement de pNIC.

Pour des performances optimales des interfaces PV (virtio), procédez comme suit :

- Identifiez le domaine NUMA auquel appartient le slot/NIC PCIe.

- La mémoire et le processeur virtuel du VPX doivent être épinglés au même domaine NUMA.

- Le thread Vhost doit être lié aux processeurs du même domaine NUMA.

Liez les threads de l’hôte virtuel aux processeurs correspondants :

-

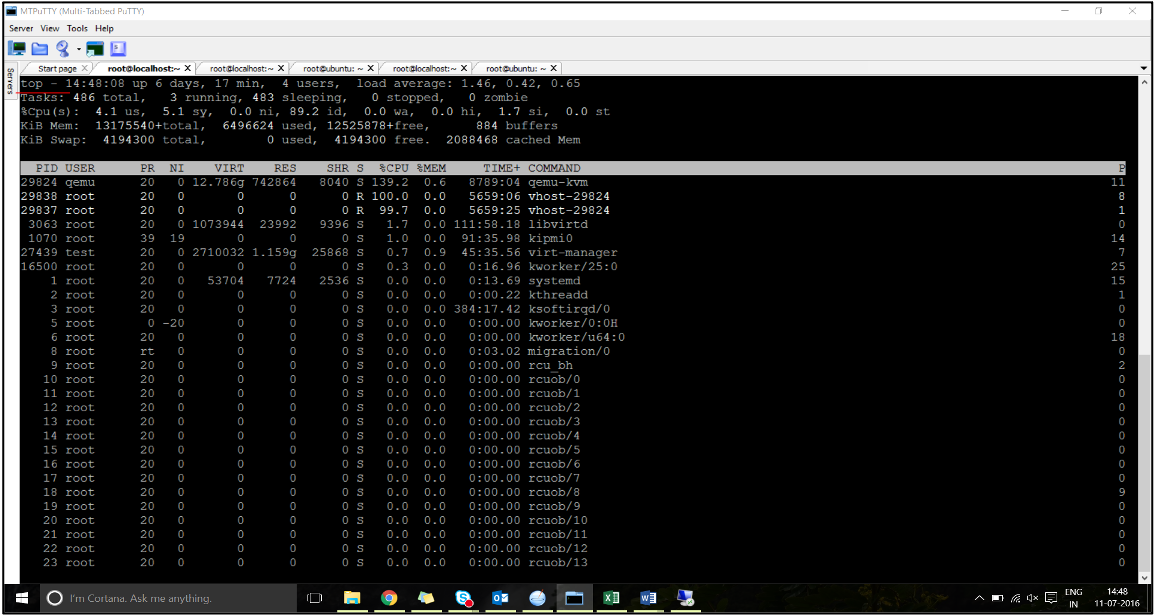

Une fois le trafic démarré, exécutez la

topcommande sur l’hôte.

- Identifiez l’affinité du processus hôte virtuel (nommé sous le nom

vhost-<pid-of-qemu>). -

Liez les processus vHost aux cœurs physiques du domaine NUMA identifié précédemment à l’aide de la commande suivante :

taskset –pc <core-id> <process-id> <!--NeedCopy-->Exemple :

taskset –pc 12 29838 <!--NeedCopy--> -

Les cœurs de processeur correspondant au domaine NUMA peuvent être identifiés à l’aide de la commande suivante :

[root@localhost ~]# virsh capabilities | grep cpu <cpu> </cpu> <cpus num='8'> <cpu id='0' socket_id='0' core_id='0' siblings='0'/> <cpu id='1' socket_id='0' core_id='1' siblings='1'/> <cpu id='2' socket_id='0' core_id='2' siblings='2'/> <cpu id='3' socket_id='0' core_id='3' siblings='3'/> <cpu id='4' socket_id='0' core_id='4' siblings='4'/> <cpu id='5' socket_id='0' core_id='5' siblings='5'/> <cpu id='6' socket_id='0' core_id='6' siblings='6'/> <cpu id='7' socket_id='0' core_id='7' siblings='7'/> </cpus> <cpus num='8'> <cpu id='8' socket_id='1' core_id='0' siblings='8'/> <cpu id='9' socket_id='1' core_id='1' siblings='9'/> <cpu id='10' socket_id='1' core_id='2' siblings='10'/> <cpu id='11' socket_id='1' core_id='3' siblings='11'/> <cpu id='12' socket_id='1' core_id='4' siblings='12'/> <cpu id='13' socket_id='1' core_id='5' siblings='13'/> <cpu id='14' socket_id='1' core_id='6' siblings='14'/> <cpu id='15' socket_id='1' core_id='7' siblings='15'/> </cpus> <cpuselection/> <cpuselection/> <!--NeedCopy-->

Liez le processus QEMU au cœur physique correspondant :

- Identifiez les cœurs physiques sur lesquels le processus QEMU est exécuté. Pour plus d’informations, reportez-vous à la sortie précédente.

-

Liez le processus QEMU aux mêmes cœurs physiques auxquels vous liez les vCPU, à l’aide de la commande suivante :

taskset –pc 8-11 29824 <!--NeedCopy-->

NetScaler VPX avec interfaces réseau relais SR-IOV et Fortville PCIe

Pour des performances optimales des interfaces réseau relais SR-IOV et Fortville PCIe, procédez comme suit :

- Identifiez le domaine NUMA auquel appartient le slot/NIC PCIe.

- La mémoire et le processeur virtuel du VPX doivent être épinglés au même domaine NUMA.

Exemple de fichier XML VPX pour vCPU et épinglage de mémoire pour Linux KVM :

<domain type='kvm'>

<name>NetScaler-VPX</name>

<uuid>138f7782-1cd3-484b-8b6d-7604f35b14f4</uuid>

<memory unit='KiB'>8097152</memory>

<currentMemory unit='KiB'>8097152</currentMemory>

<vcpu placement='static'>4</vcpu>

<cputune>

<vcpupin vcpu='0' cpuset='8'/>

<vcpupin vcpu='1' cpuset='9'/>

<vcpupin vcpu='2' cpuset='10'/>

<vcpupin vcpu='3' cpuset='11'/>

</cputune>

<numatune>

<memory mode='strict' nodeset='1'/>

</numatune>

</domain>

<!--NeedCopy-->

Instance NetScaler VPX sur Citrix Hypervisors

Cette section contient des détails sur les options et paramètres configurables, ainsi que d’autres suggestions qui vous aident à optimiser les performances de l’instance NetScaler VPX sur les hyperviseurs Citrix.

- Paramètres de performance pour Citrix Hypervisors

- NetScaler VPX avec interfaces réseau SR-IOV

- NetScaler VPX avec interfaces para-virtualisées

Paramètres de performance pour Citrix Hypervisors

Recherchez le domaine NUMA de la carte réseau à l’aide de la commande « xl » :

xl info -n

<!--NeedCopy-->

Épinglez les vCPU de VPX aux cœurs physiques.

xl vcpu-pin <Netsclaer VM Name> <vCPU id> <physical CPU id>

<!--NeedCopy-->

Vérifiez la liaison des vCPU.

xl vcpu-list

<!--NeedCopy-->

Allouez plus de 8 processeurs virtuels aux machines virtuelles NetScaler.

Pour configurer plus de 8 processeurs virtuels, exécutez les commandes suivantes à partir de la console Citrix Hypervisor :

xe vm-param-set uuid=your_vms_uuid VCPUs-max=16

xe vm-param-set uuid=your_vms_uuid VCPUs-at-startup=16

<!--NeedCopy-->

NetScaler VPX avec interfaces réseau SR-IOV

Pour des performances optimales des interfaces réseau SR-IOV, procédez comme suit :

- Identifiez le domaine NUMA auquel l’emplacement PCIe ou la carte réseau est lié.

- Épinglez la mémoire et le processeur virtuel du VPX au même domaine NUMA.

- Liez le vCPU Domain-0 au processeur restant.

NetScaler VPX avec interfaces para-virtualisées

Pour des performances optimales, deux cartes réseau virtuelles par PNIC et une configuration vNIC par pNIC sont recommandées, comme dans d’autres environnements PV.

Pour obtenir des performances optimales des interfaces para-virtualisées (netfront), procédez comme suit :

- Identifiez le domaine NUMA auquel appartient le slot PCIe ou la carte réseau.

- Épinglez la mémoire et le processeur virtuel du VPX au même domaine NUMA.

- Liez le vCPU Domain-0 au processeur restant du même domaine NUMA.

- Épinglez les threads Rx/Tx hôtes de vNIC aux vCPU du domaine 0.

Épinglez les threads hôtes aux vCPU Domain-0 :

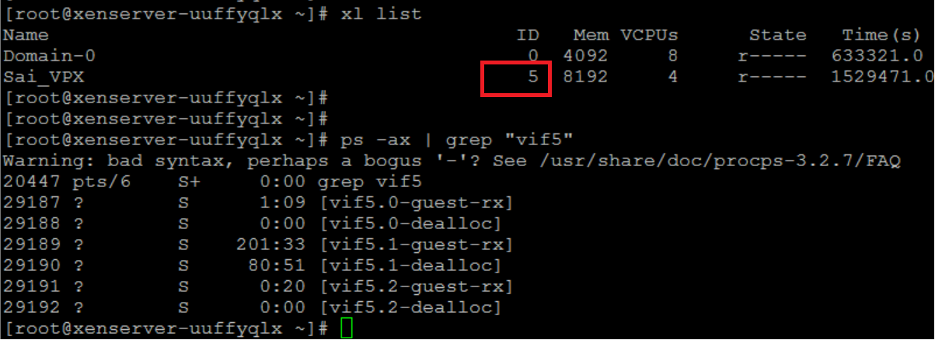

- Recherchez l’ID Xen du VPX à l’aide de la

xl listcommande sur le shell hôte Citrix Hypervisor. -

Identifiez les threads hôtes à l’aide de la commande suivante :

ps -ax | grep vif <Xen-ID> <!--NeedCopy-->Dans l’exemple suivant, ces valeurs indiquent :

- vif5.0 - Les threads de la première interface allouée à VPX dans XenCenter (interface de gestion).

- vif5.1 - Les threads de la deuxième interface assignée à VPX, etc.

-

Épinglez les threads aux vCPU du domaine 0 à l’aide de la commande suivante :

taskset –pc <core-id> <process-id> <!--NeedCopy-->Exemple :

taskset -pc 1 29189 <!--NeedCopy-->

Partager

Partager

This Preview product documentation is Cloud Software Group Confidential.

You agree to hold this documentation confidential pursuant to the terms of your Cloud Software Group Beta/Tech Preview Agreement.

The development, release and timing of any features or functionality described in the Preview documentation remains at our sole discretion and are subject to change without notice or consultation.

The documentation is for informational purposes only and is not a commitment, promise or legal obligation to deliver any material, code or functionality and should not be relied upon in making Cloud Software Group product purchase decisions.

If you do not agree, select I DO NOT AGREE to exit.