-

-

-

サポート・マトリックスと使用ガイドライン

-

VMware ESX、Linux KVM、およびCitrix HypervisorでNetScaler ADC VPXのパフォーマンスを最適化する

-

-

-

NetScalerアプライアンスのアップグレードとダウングレード

-

-

-

-

-

-

-

-

-

-

-

-

This content has been machine translated dynamically.

Dieser Inhalt ist eine maschinelle Übersetzung, die dynamisch erstellt wurde. (Haftungsausschluss)

Cet article a été traduit automatiquement de manière dynamique. (Clause de non responsabilité)

Este artículo lo ha traducido una máquina de forma dinámica. (Aviso legal)

此内容已经过机器动态翻译。 放弃

このコンテンツは動的に機械翻訳されています。免責事項

이 콘텐츠는 동적으로 기계 번역되었습니다. 책임 부인

Este texto foi traduzido automaticamente. (Aviso legal)

Questo contenuto è stato tradotto dinamicamente con traduzione automatica.(Esclusione di responsabilità))

This article has been machine translated.

Dieser Artikel wurde maschinell übersetzt. (Haftungsausschluss)

Ce article a été traduit automatiquement. (Clause de non responsabilité)

Este artículo ha sido traducido automáticamente. (Aviso legal)

この記事は機械翻訳されています.免責事項

이 기사는 기계 번역되었습니다.책임 부인

Este artigo foi traduzido automaticamente.(Aviso legal)

这篇文章已经过机器翻译.放弃

Questo articolo è stato tradotto automaticamente.(Esclusione di responsabilità))

Translation failed!

サポート・マトリックスと使用ガイドライン

このドキュメントでは、NetScaler VPXインスタンスでサポートされているさまざまなハイパーバイザーと機能について説明します。また、使用上のガイドラインと既知の制限事項についても説明します。

Citrix Hypervisor 上の VPX インスタンス

| Citrix Hypervisor のバージョン | SysID | VPX モデル |

|---|---|---|

| 8.2 は 13.0 64.x 以降をサポート、8.0、7.6、7.1 | 450000 | VPX 10、VPX 25、VPX 200、VPX 1000、VPX 3000、VPX 5000、VPX 8000、VPX 10G、VPX 15G、VPX 25G、VPX 40G |

VMware ESXi ハイパーバイザー上の VPX インスタンス

450010(システムID)を備えた以下のVPXモデルは、表に記載されているVMware ESXのバージョンをサポートします。

VPX モデル:VPX 10、VPX 25、VPX 200、VPX 1000、VPX 3000、VPX 5000、VPX 8000、VPX 10G、VPX 15G、VPX 25G、VPX 40G、VPX 100G。

| ESXi バージョン | ESXi のリリース日 (年/月/日) | ESXi ビルド番号 | NetScaler VPXバージョン |

|---|---|---|---|

| ESXi 8.0 update 2c | 2024/05/21 | 23825572 | 13.1-53.x およびそれ以降のビルド |

| ESXi 8.0 アップデート 2b | 2024/02/29 | 23305546 | 13.1-49.15、および 13.1-52.x 以降のビルド |

| ESXi 8.0 アップデート 2 | 2023/09/21 | 22380479 | 13.1-52.x およびそれ以降のビルド |

| ESXi 8.0 アップデート 1 | 2023/04/18 | 21495797 | 13.1-45.x およびそれ以降のビルド |

| ESXi 8.0c | 2023/03/30 | 21493926 | 13.1-45.x およびそれ以降のビルド |

| ESXi 8.0 | 2022/10/11 | 20513097 | 13.1-42.x およびそれ以降のビルド |

| ESXi 7.0 アップデート第 3 四半期 | 2024/05/21 | 23794027 | 13.1-53.x およびそれ以降のビルド |

| ESXi 7.0 update 3p | 2024/03/05 | 23307199 | 13.1-52.x およびそれ以降のビルド |

| ESXi 7.0 update 3o | 2023/09/28 | 22348816 | 13.1-51.x およびそれ以降のビルド |

| ESXi 7.0 update 3n | 2023/07/06 | 21930508 | 13.1-49.x およびそれ以降のビルド |

| ESXi 7.0 update 3m | 2023/05/03 | 21686933 | 13.1-48.x およびそれ以降のビルド |

| ESXi 7.0 update 3i | 2022/12/08 | 20842708 | 13.1-37.x およびそれ以降のビルド |

| ESXi 7.0 update 3f | 2022/07/12 | 20036589 | 13.1-33.x およびそれ以降のビルド |

| ESXi 7.0 update 3d | 2022/03/29 | 19482537 | 13.1-27.x およびそれ以降のビルド |

| ESXi 7.0 update 3c | 2022/01/27 | 19193900 | 13.1-21.x およびそれ以降のビルド |

| ESX 7.0 update 2d | 2021/09/14 | 18538813 | 13.1-9.x およびそれ以降のビルド |

| ESX 7.0 update 2a | 2021/04/29 | 17867351 | 13.1-4.x およびそれ以降のビルド |

注:

各ESXiパッチサポートは、前の表で指定されているNetScaler VPXバージョンで検証されており、NetScaler VPX 13.1バージョンのすべての上位ビルドに適用されます。

Microsoft Hyper-V上のVPXインスタンス

| Hyper-V版 | SysID | VPX モデル |

|---|---|---|

| 2016, 2019 | 450020 | VPX 10、VPX 25、VPX 200、VPX 1000、VPX 3000 |

Nutanix AHV の VPX インスタンス

NetScaler VPXは、Citrix Readyパートナーシップを通じてNutanix AHVでサポートされています。Citrix Readyは、ソフトウェアおよびハードウェアのベンダーが自社製品を開発し、デジタルワークスペース、ネットワーキング、および分析用のNetScalerテクノロジーと統合するのを支援するテクノロジーパートナープログラムです。

NetScaler VPXインスタンスをNutanix AHVにデプロイする段階的な方法の詳細については、「Nutanix AHVへのNetScaler VPX デプロイ」を参照してください。

サードパーティサポート:

NetScaler環境での特定のサードパーティ(Nutanix AHV)の統合で問題が発生した場合は、サードパーティパートナー(Nutanix)に直接サポートインシデントをオープンしてください。

パートナーが問題がNetScalerにあると判断した場合、パートナーはNetScalerサポートに連絡してさらにサポートを受けることができます。問題が解決するまで、パートナーからの専任技術リソースがNetScalerサポートと協力します。

詳しくは、「 Citrix Readyパートナープログラムに関するよくある質問」を参照してください。

汎用 KVM 上の VPX インスタンス

| 汎用 KVM バージョン | SysID | VPX モデル |

|---|---|---|

| レール 7.6、レール 8.0、レール 9.3 | 450070

|

VPX 10、VPX 25、VPX 200、VPX 1000、VPX 3000、VPX 5000、VPX 8000、VPX 10G、VPX 15G。VPX 25G, VPX 40G, VPX 100G

|

| Ubuntu 16.04、Ubuntu 18.04、RHV 4.2 |

注意事項:

KVM ハイパーバイザーを使用するときは、次の点を考慮してください。

-

VPXインスタンスは、表1-4に記載されているHypervisor リリースバージョンに対して認定されており、バージョン内のパッチリリースには適していません。ただし、VPXインスタンスは、サポートされているバージョンのパッチリリースとシームレスに動作することが期待されます。そうでない場合は、トラブルシューティングとデバッグのためのサポートケースを記録します。

- RHEL 7.6 を使用する前に、KVM ホストで以下のステップを完了します。

-

/etc/default/grubを編集して

"kvm_intel.preemption_timer=0"をGRUB_CMDLINE_LINUX変数に追加します。 -

コマンド

"# grub2-mkconfig -o /boot/grub2/grub.cfg"でgrub.cfgを再生成します。 -

ホストマシンを再起動します。

-

-

Ubuntu 18.04 を使用する前に、KVM ホストで以下のステップを完了してください。

- /etc/default/grubを編集して

"kvm_intel.preemption_timer=0"をGRUB_CMDLINE_LINUX変数に追加します。 - コマンド

"# grub-mkconfig -o /boot/grub/grub.cfg “でgrub.cfgを再生成します。 - ホストマシンを再起動します。

- /etc/default/grubを編集して

AWS 上の VPX インスタンス

| AWS バージョン | SysID | VPX モデル |

|---|---|---|

| - | 450040 | VPX 10、VPX 200、VPX 1000、VPX 3000、VPX 5000、VPX BYOL、VPX 8000、VPX 10G、VPX 15G、VPX 25G は、EC2 インスタンスタイプ(C5、M5、および C5n)での BYOL でのみ使用できます。 |

注:

VPX 25Gオファリングは、AWSでは25Gのスループットを提供しませんが、VPX 15Gオファリングと比較してより高いSSLトランザクションレートを提供できます。

Azure 上の VPX インスタンス

| Azure バージョン | SysID | VPX モデル |

|---|---|---|

| - | 450020 | VPX 10、VPX 200、VPX 1000、VPX 3000、VPX 5000、VPX BYOL |

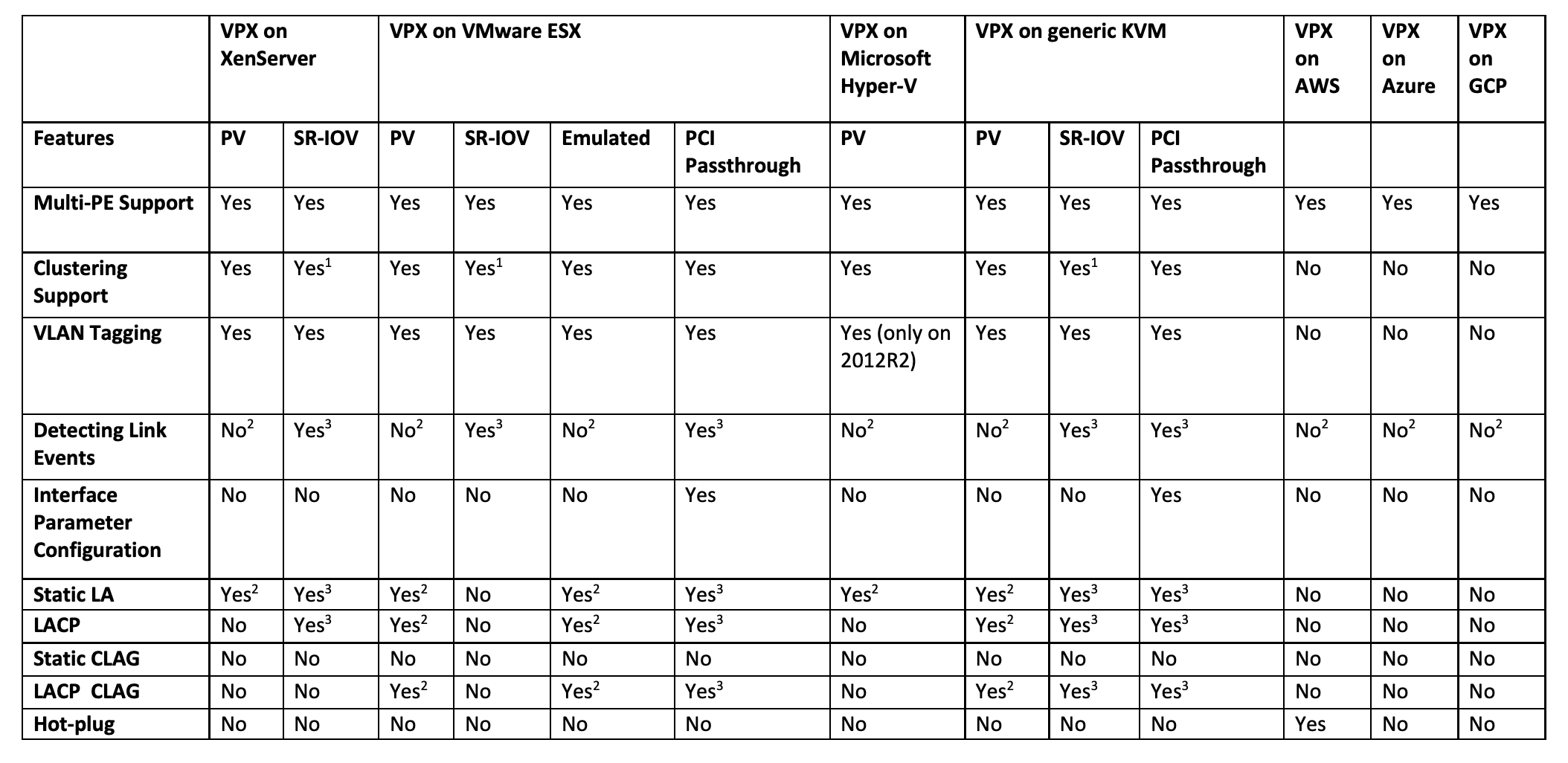

VPX 機能マトリックス

前の表で使用されている上付き番号 (1、2、3) は、それぞれの番号付けで次の点を指します。

-

SRIOV では、バックプレーンではなく、クライアント側およびサーバ側インターフェイス用のクラスタリングサポートを利用できます。

-

インターフェイスダウンイベントはNetScaler VPXインスタンスには記録されません。

-

スタティック LA の場合、物理ステータスが DOWN のインターフェイスでトラフィックが送信される場合もあります。

-

LACP の場合、ピアデバイスは LACP タイムアウトメカニズムに基づいてインターフェイス DOWN イベントを認識します。

- 短いタイムアウト:3秒

- 長いタイムアウト:90秒

-

LACP では、VM 間でインターフェイスを共有しないでください。

-

ダイナミックルーティングの場合、リンクイベントが検出されないため、コンバージェンス時間はルーティングプロトコルによって異なります。

-

モニタ対象スタティックルート機能は、ルータの状態が VLAN ステータスに依存するため、モニタをスタティックルートにバインドしないと失敗します。VLAN ステータスは、リンクステータスによって異なります。

-

リンク障害がある場合、高可用性では部分的な障害検出は行われません。リンク障害があると、高可用性の分割脳の状態が発生する可能性があります。

-

VPXインスタンスからリンクイベント(無効/有効化、リセット)が生成された場合、リンクの物理ステータスは変わりません。静的 LA の場合、ピアによって開始されたトラフィックはすべてインスタンスでドロップされます。

-

VLAN タギング機能を機能させるには、次の手順を実行します。

VMware ESX で、VMware ESX サーバの vSwitch でポートグループの VLAN ID を 1 ~ 4095 に設定します。VMware ESX サーバの vSwitch での VLAN ID の設定の詳細については、「 VMware ESX Server 3 802.1Q VLAN ソリューション」を参照してください。

-

サポートされているブラウザー

| オペレーティングシステム | ブラウザとバージョン |

|---|---|

| Windows 7 | Internet Explorer-8, 9, 10, 11; Mozilla Firefox 3.6.25 以降; Google Chrome-15以降 |

| Windows 64ビット | Internet Explorer-8、9; Google Chrome-15 以降 |

| MAC | Mozilla Firefox-12以降; Safari-5.1.3; Google Chrome-15以降 |

VPXインスタンスのAMDプロセッササポート

NetScalerリリース13.1以降、VPXインスタンスはIntel プロセッサーとAMDプロセッサーの両方をサポートしています。VPX仮想アプライアンスは、2つ以上の仮想コアと2 GBを超えるメモリを備えた任意のインスタンスタイプにデプロイできます。システム要件の詳細については、 NetScaler VPXのデータシートを参照してください。

VPXプラットフォームとNIC マトリックステーブル

次の表は、VPXプラットフォームまたはクラウドでサポートされているNICの一覧です。

| Mellanox CX-3 | Mellanox CX-4 | Mellanox CX-5 | Intel 82599 SRIOV VF | Intel X710/X722/XL710 SRIOV VF | Intel X710/XL710 PCI-Passthrough Mode | ||

|---|---|---|---|---|---|---|---|

| VPX (ESXi) | いいえ | はい | いいえ | はい | いいえ | はい | |

| VPX (Citrix Hypervisor) | - | - | - | はい | はい | いいえ | |

| VPX (KVM) | いいえ | はい | はい | はい | はい | はい | |

| VPX (Hyper-V) | - | - | - | いいえ | いいえ | いいえ | |

| VPX (AWS) | - | - | - | はい | - | - | |

| VPX (Azure) | はい | はい | はい | - | - | - | |

| VPX (GCP) | - | - | - | - | - | - | |

使用ガイドライン

使用上のガイドラインに従ってください。

- VPXインスタンスは、サーバーのローカルディスクまたはSANベースのストレージボリュームにデプロイすることをお勧めします。

『 VMware vSphere 6.5 のパフォーマンスのベストプラクティス』ドキュメントの「VMware ESXi CPU に関する考慮事項 」セクションを参照してください。ここに抽出があります:

-

CPU/メモリの需要が高い仮想マシンを、オーバーコミットの多いホストまたはクラスターに配置することはお勧めしません。

-

ほとんどの環境では、ESXiは、仮想マシンのパフォーマンスに影響を与えることなく、かなりのレベルのCPUオーバーコミットメントを許可します。ホストでは、そのホスト内の物理プロセッサコアの総数よりも多くの vCPU を実行できます。

-

ESXi ホストが CPU 飽和状態になった場合、つまり、仮想マシンおよびホスト上のその他の負荷がホストにあるすべての CPU リソースを要求すると、レイテンシの影響を受けやすいワークロードがうまく動作しない可能性があります。この場合、一部の仮想マシンをパワーオフしたり、仮想マシンを別のホストに移行したりする (または DRS による自動移行を許可する) など、CPU の負荷を軽減することができます。

-

仮想マシンでESXi Hypervisorの最新の機能セットを利用するには、最新のハードウェア互換性バージョンを使用することをお勧めします。ハードウェアと ESXi バージョンの互換性の詳細については、 VMware のドキュメントを参照してください。

-

NetScaler VPXは、レイテンシーに敏感で高性能な仮想アプライアンスです。期待されるパフォーマンスを実現するには、アプライアンスに vCPU 予約、メモリ予約、ホストでの vCPU ピン接続が必要です。また、ホスト上でハイパースレッディングを無効にする必要があります。ホストがこれらの要件を満たさない場合、高可用性フェイルオーバー、VPXインスタンス内のCPUスパイク、VPX CLIへのアクセスにおける低速化、ピットボスデーモンのクラッシュ、パケットドロップ、低スループットなどの問題が発生します。

Hypervisor は、次の 2 つの条件のいずれかが満たされると、過剰プロビジョニングと見なされます:

-

ホストにプロビジョニングされた仮想コア (vCPU) の総数が、物理コア (pCPU) の総数を超えています。

-

プロビジョニングされた仮想マシンの合計数は、pCPU の合計数よりも多くの vCPU を消費します。

インスタンスが過剰プロビジョニングされている場合、ハイパーバイザーのスケジューリングオーバーヘッド、バグ、またはハイパーバイザーの制限により、ハイパーバイザーがインスタンスのリザーブドリソース(CPU、メモリなど)を保証しない場合があります。この動作により、NetScaler CPUリソースが不足し、 使用ガイドラインの最初のポイントで説明されている問題が発生する可能性があります。管理者は、ホスト上でプロビジョニングされる vCPU の総数が pCPU の総数より少なくなるように、ホストのテナント数を減らすことをお勧めします。

例

ESXハイパーバイザーの場合、

esxtopコマンド出力でVPX vCPUの%RDY%パラメータが0より大きい場合、ESXホストにスケジューリングオーバーヘッドがあると言われ、VPXインスタンスのレイテンシー関連の問題が発生する可能性があります。このような状況では、

%RDY%が常に0に戻るように、ホストのテナンシーを減らします。または、ハイパーバイザーベンダーに連絡して、リソース予約が完了していない理由をトリアージします。 - ホットアドは、AWS上のNetScalerを使用するPVおよびSRIOVインターフェイスでのみサポートされます。ENAインターフェイスを持つVPXインスタンスはホットプラグをサポートしていないため、ホットプラグを試みるとインスタンスの動作が予測できない場合があります。

- AWS ウェブコンソールまたは AWS CLI インターフェイスを介したホット削除は、NetScaler の PV、SRIOV、および ENA インターフェイスではサポートされていません。ホット削除を試みると、インスタンスの動作が予測できなくなる可能性があります。

パケットエンジンの CPU 使用率を制御するコマンド

ハイパーバイザーおよびクラウド環境における VPX インスタンスのパケットエンジン(非管理)CPU 使用率の動作を制御するには、2 つのコマンド(set ns vpxparamおよびshow ns vpxparam)を使用できます:

-

set ns vpxparam [-cpuyield (YES | NO | DEFAULT)] [-masterclockcpu1 (YES | NO)]各 VM が、別の VM に割り当てられているが、使用されていない CPU リソースの使用を許可します。

Set ns vpxparamパラメータ:-cpuyield: 割り当てられているが未使用の CPU リソースを解放または解放しません。

-

はい:割り当てられているが未使用の CPU リソースを別の VM で使用できるようにします。

-

いいえ:割り当てられている VM のすべての CPU リソースを予約します。このオプションは、ハイパーバイザーおよびクラウド環境でVPX CPU使用率が高い割合を示します。

-

デフォルト:いいえ。

注:

すべてのNetScaler VPXプラットフォームで、ホストシステム上のvCPU使用率は 100% です。

set ns vpxparam –cpuyield YESコマンドを入力して、この使用方法を上書きします。クラスタノードを「yield」に設定する場合は、CCO で次の追加設定を実行する必要があります:

- クラスタが形成されると、すべてのノードに「yield=Default」が表示されます。

- すでに「yield=Yes」に設定されたノードを使用してクラスターが形成されている場合、ノードは「DEFAULT」のイールドを使用してクラスターに追加されます。

注:

クラスタノードを「yield=YES」に設定する場合は、クラスタの形成後にのみ構成でき、クラスタが形成される前には設定できません。

-masterclockcpu1: メインクロックソースを CPU0 (管理 CPU) から CPU1 に移動できます。このパラメータには、次のオプションがあります。

-

はい:仮想マシンがメインクロックソースを CPU0 から CPU1 に移動できるようにします。

-

いいえ:VM はメインクロックソースに CPU0 を使用します。デフォルトでは、CPU0 がメインクロックソースです。

-

-

show ns vpxparam現在の

vpxparam設定を表示します。

その他の参考文献

-

Citrix Ready製品については、 Citrix Ready Marketplaceにアクセスしてください

-

Citrix Ready製品サポートについては、 よくある質問ページを参照してください。

-

VMware ESX ハードウェアバージョンについては、 VMware Tools のアップグレードを参照してください。

共有

共有

この記事の概要

- Citrix Hypervisor 上の VPX インスタンス

- VMware ESXi ハイパーバイザー上の VPX インスタンス

- Microsoft Hyper-V上のVPXインスタンス

- Nutanix AHV の VPX インスタンス

- 汎用 KVM 上の VPX インスタンス

- AWS 上の VPX インスタンス

- Azure 上の VPX インスタンス

- VPX 機能マトリックス

- サポートされているブラウザー

- VPXインスタンスのAMDプロセッササポート

- VPXプラットフォームとNIC マトリックステーブル

- 使用ガイドライン

- パケットエンジンの CPU 使用率を制御するコマンド

- その他の参考文献

This Preview product documentation is Cloud Software Group Confidential.

You agree to hold this documentation confidential pursuant to the terms of your Cloud Software Group Beta/Tech Preview Agreement.

The development, release and timing of any features or functionality described in the Preview documentation remains at our sole discretion and are subject to change without notice or consultation.

The documentation is for informational purposes only and is not a commitment, promise or legal obligation to deliver any material, code or functionality and should not be relied upon in making Cloud Software Group product purchase decisions.

If you do not agree, select I DO NOT AGREE to exit.