-

Bereitstellen einer NetScaler VPX- Instanz

-

Optimieren der Leistung von NetScaler VPX auf VMware ESX, Linux KVM und Citrix Hypervisors

-

Unterstützung für die Erhöhung des NetScaler VPX-Speicherplatzes

-

NetScaler VPX-Konfigurationen beim ersten Start der NetScaler-Appliance in der Cloud anwenden

-

Verbessern der SSL-TPS-Leistung auf Public-Cloud-Plattformen

-

Gleichzeitiges Multithreading für NetScaler VPX in öffentlichen Clouds konfigurieren

-

Installieren einer NetScaler VPX Instanz auf einem Bare-Metal-Server

-

Installieren einer NetScaler VPX-Instanz auf Citrix Hypervisor

-

Installieren einer NetScaler VPX-Instanz auf VMware ESX

-

NetScaler VPX für die Verwendung der VMXNET3-Netzwerkschnittstelle konfigurieren

-

NetScaler VPX für die Verwendung der SR-IOV-Netzwerkschnittstelle konfigurieren

-

Migration des NetScaler VPX von E1000 zu SR-IOV- oder VMXNET3-Netzwerkschnittstellen

-

NetScaler VPX für die Verwendung der PCI-Passthrough-Netzwerkschnittstelle konfigurieren

-

-

Installieren einer NetScaler VPX-Instanz in der VMware Cloud auf AWS

-

Installieren einer NetScaler VPX-Instanz auf Microsoft Hyper-V-Servern

-

Installieren einer NetScaler VPX-Instanz auf der Linux-KVM-Plattform

-

Voraussetzungen für die Installation virtueller NetScaler VPX-Appliances auf der Linux-KVM-Plattform

-

Provisioning der virtuellen NetScaler-Appliance mit OpenStack

-

Provisioning der virtuellen NetScaler-Appliance mit Virtual Machine Manager

-

Konfigurieren virtueller NetScaler-Appliances für die Verwendung der SR-IOV-Netzwerkschnittstelle

-

Provisioning der virtuellen NetScaler-Appliance mit dem virsh-Programm

-

Provisioning der virtuellen NetScaler-Appliance mit SR-IOV auf OpenStack

-

-

Bereitstellen einer NetScaler VPX-Instanz auf AWS

-

Bereitstellen einer eigenständigen NetScaler VPX-Instanz auf AWS

-

Bereitstellen eines VPX-HA-Paar in derselben AWS-Verfügbarkeitszone

-

Bereitstellen eines VPX Hochverfügbarkeitspaars mit privaten IP-Adressen in verschiedenen AWS-Zonen

-

Schützen von AWS API Gateway mit NetScaler Web Application Firewall

-

Konfigurieren einer NetScaler VPX-Instanz für die Verwendung der SR-IOV-Netzwerkschnittstelle

-

Konfigurieren einer NetScaler VPX-Instanz für die Verwendung von Enhanced Networking mit AWS ENA

-

Bereitstellen einer NetScaler VPX Instanz unter Microsoft Azure

-

Netzwerkarchitektur für NetScaler VPX-Instanzen auf Microsoft Azure

-

Mehrere IP-Adressen für eine eigenständige NetScaler VPX-Instanz konfigurieren

-

Hochverfügbarkeitssetup mit mehreren IP-Adressen und NICs konfigurieren

-

Hochverfügbarkeitssetup mit mehreren IP-Adressen und NICs über PowerShell-Befehle konfigurieren

-

NetScaler-Hochverfügbarkeitspaar auf Azure mit ALB im Floating IP-Deaktiviert-Modus bereitstellen

-

Konfigurieren Sie eine NetScaler VPX-Instanz für die Verwendung von Azure Accelerated Networking

-

Konfigurieren Sie HA-INC-Knoten mithilfe der NetScaler-Hochverfügbarkeitsvorlage mit Azure ILB

-

NetScaler VPX-Instanz auf der Azure VMware-Lösung installieren

-

Eigenständige NetScaler VPX-Instanz auf der Azure VMware-Lösung konfigurieren

-

NetScaler VPX-Hochverfügbarkeitssetups auf Azure VMware-Lösung konfigurieren

-

Konfigurieren von GSLB in einem Active-Standby-Hochverfügbarkeitssetup

-

Konfigurieren von Adresspools (IIP) für eine NetScaler Gateway Appliance

-

Erstellen Sie ein Support-Ticket für die VPX-Instanz in Azure

-

NetScaler VPX-Instanz auf der Google Cloud Platform bereitstellen

-

Bereitstellen eines VPX-Hochverfügbarkeitspaars auf der Google Cloud Platform

-

VPX-Hochverfügbarkeitspaars mit privaten IP-Adressen auf der Google Cloud Platform bereitstellen

-

NetScaler VPX-Instanz auf Google Cloud VMware Engine bereitstellen

-

Unterstützung für VIP-Skalierung für NetScaler VPX-Instanz auf GCP

-

-

Bereitstellung und Konfigurationen von NetScaler automatisieren

-

Lösungen für Telekommunikationsdienstleister

-

Authentifizierung, Autorisierung und Überwachung des Anwendungsverkehrs

-

Wie Authentifizierung, Autorisierung und Auditing funktionieren

-

Grundkomponenten der Authentifizierung, Autorisierung und Audit-Konfiguration

-

Web Application Firewall-Schutz für virtuelle VPN-Server und virtuelle Authentifizierungsserver

-

Lokales NetScaler Gateway als Identitätsanbieter für Citrix Cloud

-

Authentifizierungs-, Autorisierungs- und Überwachungskonfiguration für häufig verwendete Protokolle

-

-

-

-

Erweiterte Richtlinienausdrücke konfigurieren: Erste Schritte

-

Erweiterte Richtlinienausdrücke: Arbeiten mit Datum, Uhrzeit und Zahlen

-

Erweiterte Richtlinienausdrücke: Analysieren von HTTP-, TCP- und UDP-Daten

-

Erweiterte Richtlinienausdrücke: Analysieren von SSL-Zertifikaten

-

Erweiterte Richtlinienausdrücke: IP- und MAC-Adressen, Durchsatz, VLAN-IDs

-

Erweiterte Richtlinienausdrücke: Stream-Analytics-Funktionen

-

Zusammenfassende Beispiele für fortgeschrittene politische Ausdrücke

-

Tutorial-Beispiele für erweiterte Richtlinien für das Umschreiben

-

-

-

Anwendungsfall — Binden der Web App Firewall-Richtlinie an einen virtuellen VPN-Server

-

-

-

-

Verwalten eines virtuellen Cache-Umleitungsservers

-

Statistiken für virtuelle Server zur Cache-Umleitung anzeigen

-

Aktivieren oder Deaktivieren eines virtuellen Cache-Umleitungsservers

-

Direkte Richtlinieneinschläge auf den Cache anstelle des Ursprungs

-

Verwalten von Clientverbindungen für einen virtuellen Server

-

Externe TCP-Integritätsprüfung für virtuelle UDP-Server aktivieren

-

-

Übersetzen die Ziel-IP-Adresse einer Anfrage in die Ursprungs-IP-Adresse

-

-

Verwalten des NetScaler Clusters

-

Knotengruppen für gepunktete und teilweise gestreifte Konfigurationen

-

Entfernen eines Knotens aus einem Cluster, der mit Cluster-Link-Aggregation bereitgestellt wird

-

Überwachen von Fehlern bei der Befehlsausbreitung in einer Clusterbereitstellung

-

VRRP-Interface-Bindung in einem aktiven Cluster mit einem einzigen Knoten

-

-

Konfigurieren von NetScaler als nicht-validierenden sicherheitsbewussten Stub-Resolver

-

Jumbo-Frames Unterstützung für DNS zur Handhabung von Reaktionen großer Größen

-

Zwischenspeichern von EDNS0-Client-Subnetzdaten bei einer NetScaler-Appliance im Proxymodus

-

Anwendungsfall — Konfiguration der automatischen DNSSEC-Schlüsselverwaltungsfunktion

-

Anwendungsfall — wie man einen kompromittierten aktiven Schlüssel widerruft

-

-

GSLB-Entitäten einzeln konfigurieren

-

Anwendungsfall: Bereitstellung einer Domänennamen-basierten Autoscale-Dienstgruppe

-

Anwendungsfall: Bereitstellung einer IP-Adressbasierten Autoscale-Dienstgruppe

-

-

-

IP-Adresse und Port eines virtuellen Servers in den Request-Header einfügen

-

Angegebene Quell-IP für die Back-End-Kommunikation verwenden

-

Quellport aus einem bestimmten Portbereich für die Back-End-Kommunikation verwenden

-

Quell-IP-Persistenz für Back-End-Kommunikation konfigurieren

-

Lokale IPv6-Linkadressen auf der Serverseite eines Load Balancing-Setups

-

Erweiterte Load Balancing-Einstellungen

-

Allmählich die Belastung eines neuen Dienstes mit virtuellem Server-Level erhöhen

-

Anwendungen vor Verkehrsspitzen auf geschützten Servern schützen

-

Bereinigung von virtuellen Server- und Dienstverbindungen ermöglichen

-

Persistenzsitzung auf TROFS-Diensten aktivieren oder deaktivieren

-

Externe TCP-Integritätsprüfung für virtuelle UDP-Server aktivieren

-

Standortdetails von der Benutzer-IP-Adresse mit der Geolocation-Datenbank abrufen

-

Quell-IP-Adresse des Clients beim Verbinden mit dem Server verwenden

-

Limit für die Anzahl der Anfragen pro Verbindung zum Server festlegen

-

Festlegen eines Schwellenwerts für die an einen Dienst gebundenen Monitore

-

Grenzwert für die Bandbreitenauslastung durch Clients festlegen

-

-

-

Lastausgleichs für häufig verwendete Protokolle konfigurieren

-

Anwendungsfall 5: DSR-Modus beim Verwenden von TOS konfigurieren

-

Anwendungsfall 6: Lastausgleich im DSR-Modus für IPv6-Netzwerke mit dem TOS-Feld konfigurieren

-

Anwendungsfall 7: Konfiguration des Lastenausgleichs im DSR-Modus mithilfe von IP Over IP

-

Anwendungsfall 8: Lastausgleich im Einarmmodus konfigurieren

-

Anwendungsfall 9: Lastausgleich im Inlinemodus konfigurieren

-

Anwendungsfall 10: Lastausgleich von Intrusion-Detection-System-Servern

-

Anwendungsfall 11: Netzwerkverkehr mit Listenrichtlinien isolieren

-

Anwendungsfall 12: Citrix Virtual Desktops für den Lastausgleich konfigurieren

-

Anwendungsfall 13: Konfiguration von Citrix Virtual Apps and Desktops für den Lastausgleich

-

Anwendungsfall 14: ShareFile-Assistent zum Lastausgleich Citrix ShareFile

-

Anwendungsfall 15: Konfiguration des Layer-4-Lastenausgleichs auf der NetScaler Appliance

-

-

SSL-Offload und Beschleunigung

-

Unterstützungsmatrix für Serverzertifikate auf der ADC-Appliance

-

Unterstützung für Intel Coleto SSL-Chip-basierte Plattformen

-

Unterstützung für Thales Luna Network Hardwaresicherheitsmodul

-

-

-

CloudBridge Connector-Tunnels zwischen zwei Rechenzentren konfigurieren

-

CloudBridge Connector zwischen Datacenter und AWS Cloud konfigurieren

-

CloudBridge Connector Tunnels zwischen einem Rechenzentrum und Azure Cloud konfigurieren

-

CloudBridge Connector Tunnels zwischen Datacenter und SoftLayer Enterprise Cloud konfigurieren

-

-

Konfigurationsdateien in einem Hochverfügbarkeitssetup synchronisieren

-

Hochverfügbarkeitsknoten in verschiedenen Subnetzen konfigurieren

-

Beschränken von Failovers, die durch Routenmonitore im Nicht-INC-Modus verursacht werden

-

HA-Heartbeat-Meldungen auf einer NetScaler-Appliance verwalten

-

NetScaler in einem Hochverfügbarkeitssetup entfernen und ersetzen

This content has been machine translated dynamically.

Dieser Inhalt ist eine maschinelle Übersetzung, die dynamisch erstellt wurde. (Haftungsausschluss)

Cet article a été traduit automatiquement de manière dynamique. (Clause de non responsabilité)

Este artículo lo ha traducido una máquina de forma dinámica. (Aviso legal)

此内容已经过机器动态翻译。 放弃

このコンテンツは動的に機械翻訳されています。免責事項

이 콘텐츠는 동적으로 기계 번역되었습니다. 책임 부인

Este texto foi traduzido automaticamente. (Aviso legal)

Questo contenuto è stato tradotto dinamicamente con traduzione automatica.(Esclusione di responsabilità))

This article has been machine translated.

Dieser Artikel wurde maschinell übersetzt. (Haftungsausschluss)

Ce article a été traduit automatiquement. (Clause de non responsabilité)

Este artículo ha sido traducido automáticamente. (Aviso legal)

この記事は機械翻訳されています.免責事項

이 기사는 기계 번역되었습니다.책임 부인

Este artigo foi traduzido automaticamente.(Aviso legal)

这篇文章已经过机器翻译.放弃

Questo articolo è stato tradotto automaticamente.(Esclusione di responsabilità))

Translation failed!

Schrittweise die Last eines neuen Dienstes mit langsamem Start auf virtueller Serverebene erhöhen

Sie können die NetScaler Appliance so konfigurieren, dass die Auslastung eines Dienstes (die Anzahl der Anforderungen, die der Dienst pro Sekunde erhält) schrittweise erhöht, nachdem der Dienst entweder zu einer Lastenausgleichskonfiguration hinzugefügt wurde oder eine Statusänderung von DOWN zu UP vorgenommen hat (in diesem Dokument lautet der Begriff “neuer Dienst” wird für beide Situationen verwendet). Sie können die Last entweder manuell mit Lastwerten und Intervallen Ihrer Wahl erhöhen (manueller langsamer Start) oder die Appliance so konfigurieren, dass sie die Last in einem bestimmten Intervall erhöht (automatischer langsamer Start), bis der Dienst so viele Anforderungen erhält wie die anderen Dienste in der Konfiguration. Während der Anlaufphase für den neuen Dienst verwendet die Appliance die konfigurierte Load-Balancing-Methode.

Diese Funktion ist nicht weltweit verfügbar. Es muss für jeden virtuellen Server konfiguriert werden. Die Funktion ist nur für virtuelle Server verfügbar, die eine der folgenden Lastausgleichsmethoden verwenden:

- Round Robin

- Geringste Verbindung

- Geringste Reaktionszeit

- Geringste Bandbreite

- Wenigste Pakete

- LRTM (Methode mit der geringsten Reaktionszeit)

- Benutzerdefiniertes Laden

Für diese Funktion müssen Sie die folgenden Parameter festlegen:

-

Die Rate neuer Serviceanfragen. Dies ist der Betrag, um den die Anzahl oder der Prozentsatz der Anfragen, die an einen neuen Dienst gesendet werden, bei jeder Erhöhung der Rate erhöht werden soll. Das heißt, Sie geben die Größe des Inkrements entweder als Anzahl der Anfragen pro Sekunde oder als Prozentsatz der Last an, die zu diesem Zeitpunkt von den vorhandenen Diensten getragen wird. Wenn dieser Wert auf 0 (Null) festgelegt ist, wird der langsame Start für neue Dienste nicht ausgeführt.

Hinweis: In einem automatisierten Langsamstartmodus ist das letzte Inkrement kleiner als der angegebene Wert, wenn der angegebene Wert den neuen Dienst stärker belasten würde als bei den anderen Diensten.

-

Das Inkrementintervall in Sekunden. Wenn dieser Wert auf 0 (Null) gesetzt ist, wird die Last nicht automatisch erhöht. Sie müssen es manuell erhöhen.

Bei einem automatisierten langsamen Start wird ein Dienst aus der langsamen Startphase herausgenommen, wenn eine der folgenden Bedingungen zutrifft:

- Die tatsächliche Anforderungsrate ist niedriger als die neue Serviceanforderungsrate.

- Der Dienst empfängt in drei aufeinanderfolgenden Inkrementintervallen keinen Datenverkehr.

- Die Anforderungsrate wurde um das 200-fache erhöht.

- Der Prozentsatz des Datenverkehrs, den der neue Dienst empfangen muss, ist größer oder gleich 100.

Beim manuellen langsamen Start verbleibt der Dienst in der langsamen Startphase, bis Sie ihn aus dieser Phase herausnehmen.

Manueller langsamer Start

Wenn Sie die Last eines neuen Dienstes manuell erhöhen möchten, geben Sie kein Inkrementintervall für den virtuellen Lastausgleichsserver an. Geben Sie nur die neue Serviceanforderungsrate und die Einheiten an. Ohne Angabe eines Intervalls erhöht die Appliance die Last nicht regelmäßig. Es hält die Last des neuen Dienstes auf dem Wert, der durch die Kombination aus der neuen Serviceanforderungsrate und den Einheiten angegeben wird, bis Sie einen der Parameter manuell ändern. Wenn Sie beispielsweise die neue Dienstanforderungsrate und die Einheitenparameter auf 25 bzw. „pro Sekunde“ festlegen, hält die Appliance die Last für den neuen Dienst bei 25 Anfragen pro Sekunde, bis Sie einen der Parameter ändern. Wenn Sie möchten, dass der neue Dienst den langsamen Startmodus verlässt und so viele Anfragen empfängt wie die vorhandenen Dienste, setzen Sie den neuen Parameter für die Dienstanforderungsrate auf 0.

Nehmen wir als Beispiel an, dass Sie einen virtuellen Server verwenden, um im Round-Robin-Modus zwei Dienste, Service1 und Service2, auszugleichen. Gehen Sie außerdem davon aus, dass der virtuelle Server 240 Anfragen pro Sekunde empfängt und dass er die Last gleichmäßig auf die Dienste verteilt. Wenn der Konfiguration ein neuer Dienst, Service3, hinzugefügt wird, sollten Sie dessen Last möglicherweise manuell durch Werte von 10, 20 und 40 Anfragen pro Sekunde erhöhen, bevor Sie ihm seinen vollen Anteil an der Last senden. Die folgende Tabelle zeigt die Werte, auf die Sie die drei Parameter einstellen.

Tabelle 1. Parameterwerte

| Parameter | Wert |

|---|---|

| Intervall in Sekunden | 0 |

| Neue Serviceanforderungsrate | 10, 20, 40 und 0, in von Ihnen gewählten Intervallen |

| Einheiten für die neue Serviceanforderungsrate | Anfragen pro Sekunde |

Wenn Sie den neuen Parameter für die Serviceanforderungsrate auf 0 setzen, wird Service3 nicht mehr als neuer Dienst betrachtet und erhält seinen vollen Anteil an der Last.

Gehen Sie davon aus, dass Sie während der Anlaufphase für Service3 einen weiteren Dienst, Service4, hinzufügen. In diesem Beispiel wird Service4 hinzugefügt, wenn der neue Parameter für die Serviceanforderungsrate auf 40 gesetzt ist. Daher beginnt Service4, 40 Anfragen pro Sekunde zu empfangen.

Die folgende Tabelle zeigt die Lastverteilung der Dienste während des in diesem Beispiel beschriebenen Zeitraums.

Tabelle 2. Lastverteilung auf Diensten bei manueller Erhöhung der Last

| neue Serviceanforderungsrate = 10 Anfragen/Sekunde (Service3Added) | neue Serviceanforderungsrate = 20 Anfragen/Sekunde | neue Serviceanforderungsrate = 40 Anfragen/Sekunde (Service4Added) | neue Dienstanforderungsrate = 0 Anfragen/Sekunde (neue Dienste verlassen den langsamen Startmodus) | |

|---|---|---|---|---|

| Service1 | 115 | 110 | 80 | 60 |

| Service2 | 115 | 110 | 80 | 60 |

| Service3 | 10 | 20 | 40 | 60 |

| Service4 | - | - | 40 | 60 |

| Gesamtzahl der Anforderungen/Sekunde (Last auf dem virtuellen Server) | 240 | 240 | 240 | 240 |

Automatisierter langsamer Start

Wenn Sie möchten, dass die Appliance die Last eines neuen Dienstes automatisch in bestimmten Intervallen erhöht, bis der Dienst als fähig angesehen werden kann, seinen vollen Anteil der Last zu verarbeiten, legen Sie den neuen Parameter für die Serviceanfrage, den Einheitenparameter und das Inkrementintervall fest. Wenn alle Parameter auf andere Werte als 0 eingestellt sind, erhöht die Appliance die Belastung eines neuen Dienstes im angegebenen Intervall um den Wert der neuen Serviceanforderungsrate, bis der Dienst seinen vollen Anteil an der Last erhält.

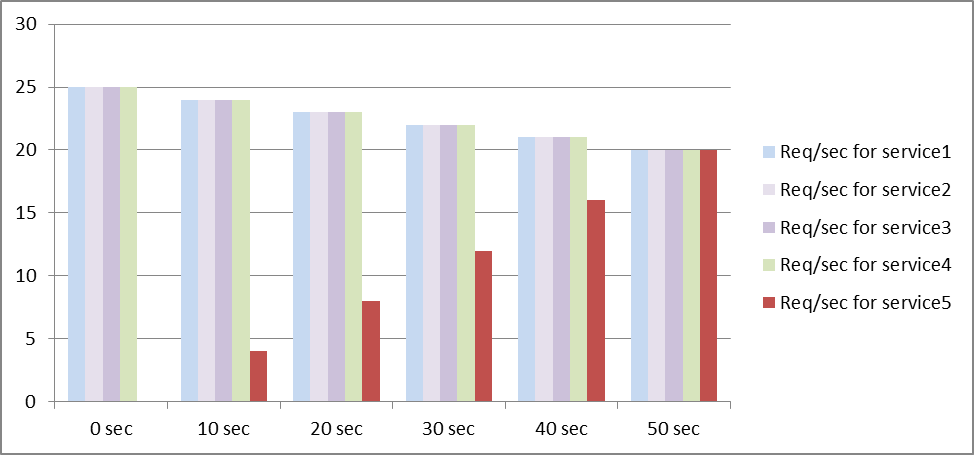

Angenommen, vier Dienste, Service1, Service2, Service3 und Service4, sind an einen virtuellen Lastausgleichsserver vserver1 gebunden. Gehen Sie außerdem davon aus, dass vserver1 100 Anfragen pro Sekunde empfängt und die Last gleichmäßig auf die Dienste verteilt (25 Anfragen pro Sekunde pro Dienst). Wenn Sie der Konfiguration einen fünften Dienst, Service5, hinzufügen, möchten Sie möglicherweise, dass die Appliance dem neuen Dienst in den ersten 10 Sekunden 4 Anfragen pro Sekunde, in den nächsten 10 Sekunden 8 Anfragen pro Sekunde usw. sendet, bis sie 20 Anfragen pro Sekunde empfängt. Für diese Anforderung zeigt die folgende Tabelle die Werte, auf die Sie die drei Parameter festlegen:

Tabelle 3. Parameterwerte

| Parameter | Wert |

|---|---|

| Intervall in Sekunden | 10 |

| Wert erhöhen | 4 |

| Einheiten für die neue Serviceanforderungsrate | Anfragen pro Sekunde |

Mit dieser Konfiguration empfängt der neue Dienst 50 Sekunden, nachdem er hinzugefügt wurde oder sein Status von DOWN auf UP geändert wurde, so viele Anfragen wie die vorhandenen Dienste. In jedem Intervall in diesem Zeitraum verteilt die Appliance die überschüssigen Anfragen, die ohne schrittweise Inkremente an den neuen Dienst gesendet worden wären, an die vorhandenen Server. Ohne schrittweise Inkremente hätte beispielsweise jeder Dienst, einschließlich Service5, jeweils 20 Anfragen pro Sekunde erhalten. In schrittweisen Schritten verteilt die Appliance in den ersten 10 Sekunden, wenn Service5 nur 4 Anfragen pro Sekunde empfängt, die überschüssigen 16 Anfragen pro Sekunde an die vorhandenen Dienste, was zu dem in der folgenden Tabelle und Abbildung dargestellten Verteilungsmuster über den Zeitraum von 50 Sekunden führt. Nach Ablauf der 50-Sekunden-Periode wird Service5 nicht mehr als neuer Dienst betrachtet und erhält seinen normalen Anteil am Traffic.

Tabelle 4. Lastverteilungsmuster auf allen Diensten für den Zeitraum von 50 Sekunden unmittelbar nach dem Hinzufügen von Service5

| 0 Sekunden | 10 Sekunden | 20 Sekunden | 30 Sekunden | 40 Sekunden | 50 Sekunden | |

|---|---|---|---|---|---|---|

| Anforderung/Sekunde für Service 1 | 25 | 24 | 23 | 22 | 21 | 20 |

| Anforderung/Sekunde für Service 2 | 25 | 24 | 23 | 22 | 21 | 20 |

| Anforderung/Sekunde für Service 3 | 25 | 24 | 23 | 22 | 21 | 20 |

| Anforderung/Sekunde für Service 4 | 25 | 24 | 23 | 22 | 21 | 20 |

| Anforderung/Sekunde für Service 5 | 0 | 4 | 8 | 12 | 16 | 20 |

| Gesamtzahl der Anforderungen/Sekunde (Last auf dem virtuellen Server) | 100 | 100 | 100 | 100 | 100 | 100 |

Abbildung 1. Diagramm des Lastverteilungsmusters für alle Dienste für den 50-Sekunden-Zeitraum unmittelbar nach dem Hinzufügen von Service5

Eine alternative Anforderung besteht möglicherweise darin, dass die Appliance Service5 25% der Auslastung der vorhandenen Dienste in den ersten 5 Sekunden, 50% in den nächsten 5 Sekunden usw. sendet, bis 20 Anforderungen pro Sekunde empfangen wird. Für diese Anforderung zeigt die folgende Tabelle die Werte, auf die Sie die drei Parameter festlegen.

Tabelle 5. Parameterwerte

| Parameter | Wert |

|---|---|

| Intervall in Sekunden | 5 |

| Wert erhöhen | 25 |

| Einheiten für die neue Serviceanforderungsrate | Prozent |

Mit dieser Konfiguration empfängt der Dienst 20 Sekunden, nachdem er hinzugefügt wurde oder sein Status von DOWN auf UP geändert wurde, so viele Anfragen wie die vorhandenen Dienste. Die Verkehrsverteilung während der Anlaufphase für den neuen Dienst ist identisch mit der zuvor beschriebenen, wobei die Einheit für die Schrittweite „Anfragen pro Sekunde“ war.

Setze die Parameter für den langsamen Start

Sie legen die Parameter für den langsamen Start fest, indem Sie entweder den Befehl set lb vserver oder den add lb vserver Befehl verwenden. Der folgende Befehl dient zum Festlegen von langsamen Startparametern beim Hinzufügen eines virtuellen Servers.

So konfigurieren Sie schrittweise Lastinkremente für einen neuen Dienst mithilfe der Befehlszeilenschnittstelle

Geben Sie an der Befehlszeile die folgenden Befehle ein, um schrittweise Lasterhöhungen für einen Dienst zu konfigurieren und die Konfiguration zu überprüfen:

add lb vserver <name> <serviceType> <IPAddress> <port> [-newServiceRequest <positive_integer>] [<newServiceRequestUnit>] [-newServiceRequestIncrementInterval <positive_integer>]

show lb vserver <name>

<!--NeedCopy-->

Beispiel

set lb vserver BR_LB -newServiceRequest 5 PER_SECOND -newServiceRequestIncrementInterval 10

Done

show lb vserver BR_LB

BR_LB (192.0.2.33:80) - HTTP Type: ADDRESS

State: UP

...

...

New Service Startup Request Rate: 5 PER_SECOND, Increment Interval: 10

...

...

Done

<!--NeedCopy-->

So konfigurieren Sie schrittweise Lastinkremente für einen neuen Dienst mithilfe des Konfigurationsprogramms

- Navigieren Sie zu Traffic Management > Load Balancing > Virtuelle Serverund öffnen Sie einen virtuellen Server.

- Wählen Sie unter Erweiterte Einstellungen die Option Methode aus und stellen Sie die folgenden Parameter für einen langsamen Start ein:

- Neue Anforderungsrate für Dienststarts.

- Neue Service Request Unit.

- Inkrementierungsintervall.

Teilen

Teilen

This Preview product documentation is Cloud Software Group Confidential.

You agree to hold this documentation confidential pursuant to the terms of your Cloud Software Group Beta/Tech Preview Agreement.

The development, release and timing of any features or functionality described in the Preview documentation remains at our sole discretion and are subject to change without notice or consultation.

The documentation is for informational purposes only and is not a commitment, promise or legal obligation to deliver any material, code or functionality and should not be relied upon in making Cloud Software Group product purchase decisions.

If you do not agree, select I DO NOT AGREE to exit.