-

Bereitstellen einer NetScaler VPX- Instanz

-

Optimieren der Leistung von NetScaler VPX auf VMware ESX, Linux KVM und Citrix Hypervisors

-

Unterstützung für die Erhöhung des NetScaler VPX-Speicherplatzes

-

NetScaler VPX-Konfigurationen beim ersten Start der NetScaler-Appliance in der Cloud anwenden

-

Verbessern der SSL-TPS-Leistung auf Public-Cloud-Plattformen

-

Gleichzeitiges Multithreading für NetScaler VPX in öffentlichen Clouds konfigurieren

-

Installieren einer NetScaler VPX Instanz auf einem Bare-Metal-Server

-

Installieren einer NetScaler VPX-Instanz auf Citrix Hypervisor

-

Installieren einer NetScaler VPX-Instanz auf VMware ESX

-

NetScaler VPX für die Verwendung der VMXNET3-Netzwerkschnittstelle konfigurieren

-

NetScaler VPX für die Verwendung der SR-IOV-Netzwerkschnittstelle konfigurieren

-

Migration des NetScaler VPX von E1000 zu SR-IOV- oder VMXNET3-Netzwerkschnittstellen

-

NetScaler VPX für die Verwendung der PCI-Passthrough-Netzwerkschnittstelle konfigurieren

-

-

Installieren einer NetScaler VPX-Instanz in der VMware Cloud auf AWS

-

Installieren einer NetScaler VPX-Instanz auf Microsoft Hyper-V-Servern

-

Installieren einer NetScaler VPX-Instanz auf der Linux-KVM-Plattform

-

Voraussetzungen für die Installation virtueller NetScaler VPX-Appliances auf der Linux-KVM-Plattform

-

Provisioning der virtuellen NetScaler-Appliance mit OpenStack

-

Provisioning der virtuellen NetScaler-Appliance mit Virtual Machine Manager

-

Konfigurieren virtueller NetScaler-Appliances für die Verwendung der SR-IOV-Netzwerkschnittstelle

-

Provisioning der virtuellen NetScaler-Appliance mit dem virsh-Programm

-

Provisioning der virtuellen NetScaler-Appliance mit SR-IOV auf OpenStack

-

-

Bereitstellen einer NetScaler VPX-Instanz auf AWS

-

Bereitstellen einer eigenständigen NetScaler VPX-Instanz auf AWS

-

Bereitstellen eines VPX-HA-Paar in derselben AWS-Verfügbarkeitszone

-

Bereitstellen eines VPX Hochverfügbarkeitspaars mit privaten IP-Adressen in verschiedenen AWS-Zonen

-

Schützen von AWS API Gateway mit NetScaler Web Application Firewall

-

Konfigurieren einer NetScaler VPX-Instanz für die Verwendung der SR-IOV-Netzwerkschnittstelle

-

Konfigurieren einer NetScaler VPX-Instanz für die Verwendung von Enhanced Networking mit AWS ENA

-

Bereitstellen einer NetScaler VPX Instanz unter Microsoft Azure

-

Netzwerkarchitektur für NetScaler VPX-Instanzen auf Microsoft Azure

-

Mehrere IP-Adressen für eine eigenständige NetScaler VPX-Instanz konfigurieren

-

Hochverfügbarkeitssetup mit mehreren IP-Adressen und NICs konfigurieren

-

Hochverfügbarkeitssetup mit mehreren IP-Adressen und NICs über PowerShell-Befehle konfigurieren

-

NetScaler-Hochverfügbarkeitspaar auf Azure mit ALB im Floating IP-Deaktiviert-Modus bereitstellen

-

Konfigurieren Sie eine NetScaler VPX-Instanz für die Verwendung von Azure Accelerated Networking

-

Konfigurieren Sie HA-INC-Knoten mithilfe der NetScaler-Hochverfügbarkeitsvorlage mit Azure ILB

-

NetScaler VPX-Instanz auf der Azure VMware-Lösung installieren

-

Eigenständige NetScaler VPX-Instanz auf der Azure VMware-Lösung konfigurieren

-

NetScaler VPX-Hochverfügbarkeitssetups auf Azure VMware-Lösung konfigurieren

-

Konfigurieren von GSLB in einem Active-Standby-Hochverfügbarkeitssetup

-

Konfigurieren von Adresspools (IIP) für eine NetScaler Gateway Appliance

-

Erstellen Sie ein Support-Ticket für die VPX-Instanz in Azure

-

NetScaler VPX-Instanz auf der Google Cloud Platform bereitstellen

-

Bereitstellen eines VPX-Hochverfügbarkeitspaars auf der Google Cloud Platform

-

VPX-Hochverfügbarkeitspaars mit privaten IP-Adressen auf der Google Cloud Platform bereitstellen

-

NetScaler VPX-Instanz auf Google Cloud VMware Engine bereitstellen

-

Unterstützung für VIP-Skalierung für NetScaler VPX-Instanz auf GCP

-

-

Bereitstellung und Konfigurationen von NetScaler automatisieren

-

Lösungen für Telekommunikationsdienstleister

-

Authentifizierung, Autorisierung und Überwachung des Anwendungsverkehrs

-

Wie Authentifizierung, Autorisierung und Auditing funktionieren

-

Grundkomponenten der Authentifizierung, Autorisierung und Audit-Konfiguration

-

Web Application Firewall-Schutz für virtuelle VPN-Server und virtuelle Authentifizierungsserver

-

Lokales NetScaler Gateway als Identitätsanbieter für Citrix Cloud

-

Authentifizierungs-, Autorisierungs- und Überwachungskonfiguration für häufig verwendete Protokolle

-

-

-

-

Erweiterte Richtlinienausdrücke konfigurieren: Erste Schritte

-

Erweiterte Richtlinienausdrücke: Arbeiten mit Datum, Uhrzeit und Zahlen

-

Erweiterte Richtlinienausdrücke: Analysieren von HTTP-, TCP- und UDP-Daten

-

Erweiterte Richtlinienausdrücke: Analysieren von SSL-Zertifikaten

-

Erweiterte Richtlinienausdrücke: IP- und MAC-Adressen, Durchsatz, VLAN-IDs

-

Erweiterte Richtlinienausdrücke: Stream-Analytics-Funktionen

-

Zusammenfassende Beispiele für fortgeschrittene politische Ausdrücke

-

Tutorial-Beispiele für erweiterte Richtlinien für das Umschreiben

-

-

-

Anwendungsfall — Binden der Web App Firewall-Richtlinie an einen virtuellen VPN-Server

-

-

-

-

Verwalten eines virtuellen Cache-Umleitungsservers

-

Statistiken für virtuelle Server zur Cache-Umleitung anzeigen

-

Aktivieren oder Deaktivieren eines virtuellen Cache-Umleitungsservers

-

Direkte Richtlinieneinschläge auf den Cache anstelle des Ursprungs

-

Verwalten von Clientverbindungen für einen virtuellen Server

-

Externe TCP-Integritätsprüfung für virtuelle UDP-Server aktivieren

-

-

Übersetzen die Ziel-IP-Adresse einer Anfrage in die Ursprungs-IP-Adresse

-

-

Verwalten des NetScaler Clusters

-

Knotengruppen für gepunktete und teilweise gestreifte Konfigurationen

-

Entfernen eines Knotens aus einem Cluster, der mit Cluster-Link-Aggregation bereitgestellt wird

-

Überwachen von Fehlern bei der Befehlsausbreitung in einer Clusterbereitstellung

-

VRRP-Interface-Bindung in einem aktiven Cluster mit einem einzigen Knoten

-

-

Konfigurieren von NetScaler als nicht-validierenden sicherheitsbewussten Stub-Resolver

-

Jumbo-Frames Unterstützung für DNS zur Handhabung von Reaktionen großer Größen

-

Zwischenspeichern von EDNS0-Client-Subnetzdaten bei einer NetScaler-Appliance im Proxymodus

-

Anwendungsfall — Konfiguration der automatischen DNSSEC-Schlüsselverwaltungsfunktion

-

Anwendungsfall — wie man einen kompromittierten aktiven Schlüssel widerruft

-

-

GSLB-Entitäten einzeln konfigurieren

-

Anwendungsfall: Bereitstellung einer Domänennamen-basierten Autoscale-Dienstgruppe

-

Anwendungsfall: Bereitstellung einer IP-Adressbasierten Autoscale-Dienstgruppe

-

-

-

IP-Adresse und Port eines virtuellen Servers in den Request-Header einfügen

-

Angegebene Quell-IP für die Back-End-Kommunikation verwenden

-

Quellport aus einem bestimmten Portbereich für die Back-End-Kommunikation verwenden

-

Quell-IP-Persistenz für Back-End-Kommunikation konfigurieren

-

Lokale IPv6-Linkadressen auf der Serverseite eines Load Balancing-Setups

-

Erweiterte Load Balancing-Einstellungen

-

Allmählich die Belastung eines neuen Dienstes mit virtuellem Server-Level erhöhen

-

Anwendungen vor Verkehrsspitzen auf geschützten Servern schützen

-

Bereinigung von virtuellen Server- und Dienstverbindungen ermöglichen

-

Persistenzsitzung auf TROFS-Diensten aktivieren oder deaktivieren

-

Externe TCP-Integritätsprüfung für virtuelle UDP-Server aktivieren

-

Standortdetails von der Benutzer-IP-Adresse mit der Geolocation-Datenbank abrufen

-

Quell-IP-Adresse des Clients beim Verbinden mit dem Server verwenden

-

Limit für die Anzahl der Anfragen pro Verbindung zum Server festlegen

-

Festlegen eines Schwellenwerts für die an einen Dienst gebundenen Monitore

-

Grenzwert für die Bandbreitenauslastung durch Clients festlegen

-

-

-

Lastausgleichs für häufig verwendete Protokolle konfigurieren

-

Anwendungsfall 5: DSR-Modus beim Verwenden von TOS konfigurieren

-

Anwendungsfall 6: Lastausgleich im DSR-Modus für IPv6-Netzwerke mit dem TOS-Feld konfigurieren

-

Anwendungsfall 7: Konfiguration des Lastenausgleichs im DSR-Modus mithilfe von IP Over IP

-

Anwendungsfall 8: Lastausgleich im Einarmmodus konfigurieren

-

Anwendungsfall 9: Lastausgleich im Inlinemodus konfigurieren

-

Anwendungsfall 10: Lastausgleich von Intrusion-Detection-System-Servern

-

Anwendungsfall 11: Netzwerkverkehr mit Listenrichtlinien isolieren

-

Anwendungsfall 12: Citrix Virtual Desktops für den Lastausgleich konfigurieren

-

Anwendungsfall 13: Konfiguration von Citrix Virtual Apps and Desktops für den Lastausgleich

-

Anwendungsfall 14: ShareFile-Assistent zum Lastausgleich Citrix ShareFile

-

Anwendungsfall 15: Konfiguration des Layer-4-Lastenausgleichs auf der NetScaler Appliance

-

-

SSL-Offload und Beschleunigung

-

Unterstützungsmatrix für Serverzertifikate auf der ADC-Appliance

-

Unterstützung für Intel Coleto SSL-Chip-basierte Plattformen

-

Unterstützung für Thales Luna Network Hardwaresicherheitsmodul

-

-

-

CloudBridge Connector-Tunnels zwischen zwei Rechenzentren konfigurieren

-

CloudBridge Connector zwischen Datacenter und AWS Cloud konfigurieren

-

CloudBridge Connector Tunnels zwischen einem Rechenzentrum und Azure Cloud konfigurieren

-

CloudBridge Connector Tunnels zwischen Datacenter und SoftLayer Enterprise Cloud konfigurieren

-

-

Konfigurationsdateien in einem Hochverfügbarkeitssetup synchronisieren

-

Hochverfügbarkeitsknoten in verschiedenen Subnetzen konfigurieren

-

Beschränken von Failovers, die durch Routenmonitore im Nicht-INC-Modus verursacht werden

-

HA-Heartbeat-Meldungen auf einer NetScaler-Appliance verwalten

-

NetScaler in einem Hochverfügbarkeitssetup entfernen und ersetzen

This content has been machine translated dynamically.

Dieser Inhalt ist eine maschinelle Übersetzung, die dynamisch erstellt wurde. (Haftungsausschluss)

Cet article a été traduit automatiquement de manière dynamique. (Clause de non responsabilité)

Este artículo lo ha traducido una máquina de forma dinámica. (Aviso legal)

此内容已经过机器动态翻译。 放弃

このコンテンツは動的に機械翻訳されています。免責事項

이 콘텐츠는 동적으로 기계 번역되었습니다. 책임 부인

Este texto foi traduzido automaticamente. (Aviso legal)

Questo contenuto è stato tradotto dinamicamente con traduzione automatica.(Esclusione di responsabilità))

This article has been machine translated.

Dieser Artikel wurde maschinell übersetzt. (Haftungsausschluss)

Ce article a été traduit automatiquement. (Clause de non responsabilité)

Este artículo ha sido traducido automáticamente. (Aviso legal)

この記事は機械翻訳されています.免責事項

이 기사는 기계 번역되었습니다.책임 부인

Este artigo foi traduzido automaticamente.(Aviso legal)

这篇文章已经过机器翻译.放弃

Questo articolo è stato tradotto automaticamente.(Esclusione di responsabilità))

Translation failed!

Optimieren der Leistung von NetScaler VPX auf VMware ESX, Linux KVM und Citrix Hypervisors

Die Leistung von NetScaler VPX hängt stark vom Hypervisor, den zugewiesenen Systemressourcen und den Hostkonfigurationen ab. Um die gewünschte Leistung zu erzielen, befolgen Sie zunächst die Empfehlungen im VPX-Datenblatt und optimieren Sie es dann mithilfe der in diesem Dokument enthaltenen Best Practices weiter.

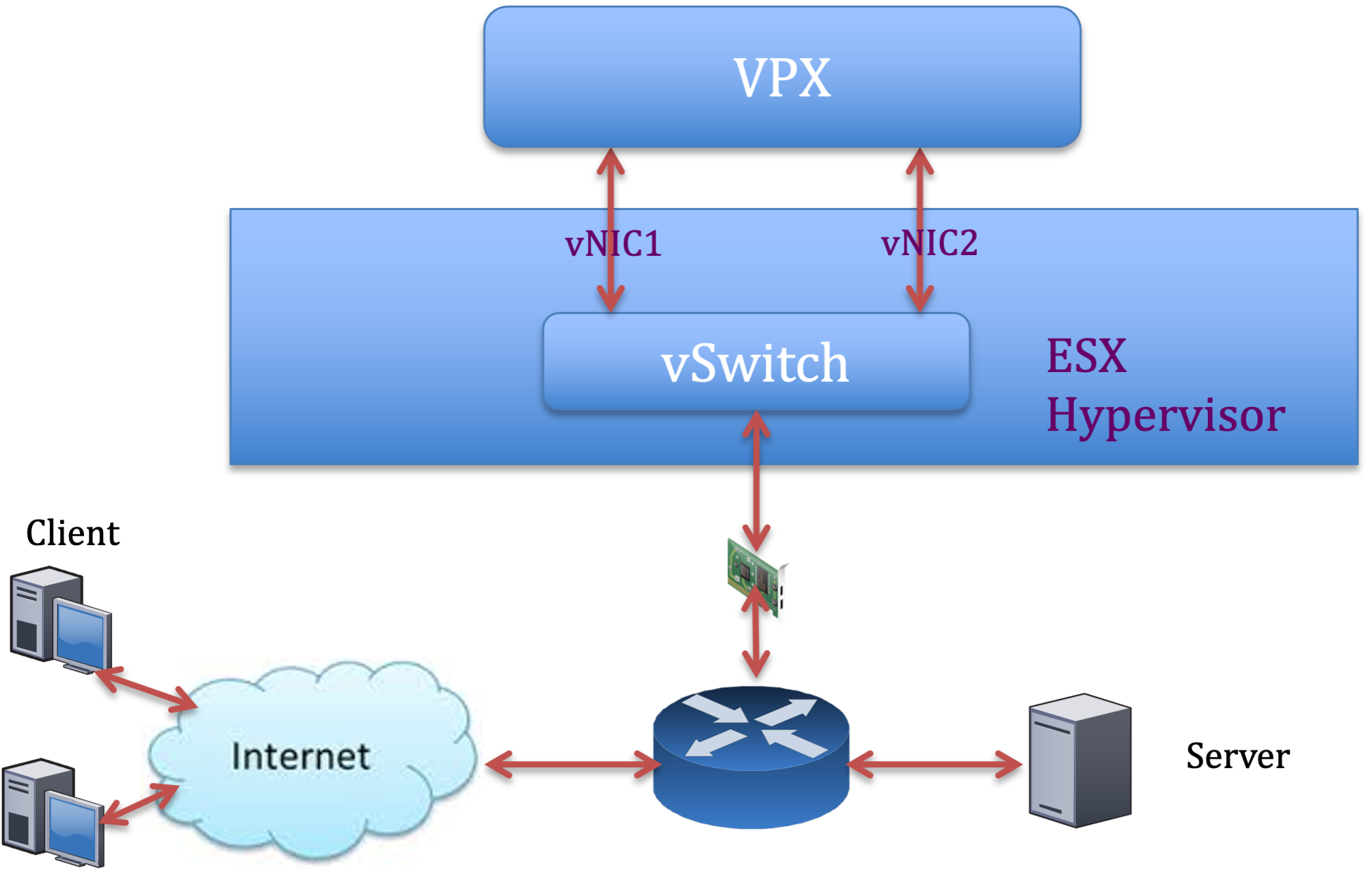

NetScaler VPX-Instanz auf VMware ESX-Hypervisoren

Dieser Abschnitt enthält Details zu konfigurierbaren Optionen und Einstellungen sowie andere Vorschläge, mit denen Sie eine optimale Leistung der NetScaler VPX-Instanz auf VMware ESX-Hypervisoren erzielen können.

- Empfohlene Konfiguration auf ESX-Hosts

- NetScaler VPX mit E1000-Netzwerkschnittstellen

- NetScaler VPX mit VMXNET3-Netzwerkschnittstellen

- NetScaler VPX mit SR-IOV- und PCI Passthrough-Netzwerkschnittstellen

Empfohlene Konfiguration auf ESX-Hosts

Befolgen Sie diese Empfehlungen, um eine hohe Leistung für VPX mit E1000-, VMXNET3-, SR-IOV- und PCI-Passthrough-Netzwerkschnittstellen zu erzielen:

- Die Gesamtzahl der auf dem ESX-Host bereitgestellten virtuellen CPUs (vCPUs) muss kleiner oder gleich der Gesamtzahl der physischen CPUs (PCPUs) auf dem ESX-Host sein.

-

Affinität und CPU-Affinität für ungleichmäßigen Speicherzugriff (NUMA) müssen festgelegt werden, damit der ESX-Host gute Ergebnisse erzielt.

− Um die NUMA-Affinität eines Vmnic zu ermitteln, melden Sie sich lokal oder remote beim Host an und geben Sie Folgendes ein:

#vsish -e get /net/pNics/vmnic7/properties | grep NUMA Device NUMA Node: 0 <!--NeedCopy-->- Informationen zum Festlegen der NUMA- und vCPU-Affinität für eine VM finden Sie in der VMware-Dokumentation

NetScaler VPX mit E1000-Netzwerkschnittstellen

Nehmen Sie die folgenden Einstellungen auf dem VMware ESX-Host vor:

- Erstellen Sie auf dem VMware ESX-Host zwei vNICs aus einem pNIC vSwitch. Mehrere vNICs erstellen mehrere Empfangsthreads (Rx) auf dem ESX-Host. Dies erhöht den Rx-Durchsatz der pNIC-Schnittstelle.

- Aktivieren Sie VLANs auf der vSwitch-Portgruppenebene für jede von Ihnen erstellte vNIC.

- Um den vNIC-Übertragungsdurchsatz (Tx) zu erhöhen, verwenden Sie einen separaten Tx-Thread im ESX-Host pro vNIC. Verwenden Sie den folgenden ESX-Befehl:

-

Für ESX Version 5.5:

esxcli system settings advanced set –o /Net/NetTxWorldlet –i <!--NeedCopy--> -

Für ESX ab Version 6.0:

esxcli system settings advanced set -o /Net/NetVMTxType –i 1 <!--NeedCopy-->

-

-

Um den vNIC Tx-Durchsatz weiter zu erhöhen, verwenden Sie einen separaten Tx-Vervollständigungs-Thread und Rx-Threads pro Gerät (NIC) -Warteschlange. Verwenden Sie den folgenden ESX-Befehl:

esxcli system settings advanced set -o /Net/NetNetqRxQueueFeatPairEnable -i 0 <!--NeedCopy-->

Hinweis:

Stellen Sie sicher, dass Sie den VMware ESX-Host neu starten, um die aktualisierten Einstellungen zu übernehmen.

Zwei vNICs pro pNIC-Bereitstellung

Im Folgenden finden Sie ein Beispiel für Topologie und Konfigurationsbefehle für das Bereitstellungsmodell mit zwei vNICs pro pNIC, das eine bessere Netzwerkleistung bietet.

NetScaler VPX Beispielkonfiguration:

Um die in der vorherigen Beispieltopologie gezeigte Bereitstellung zu erreichen, führen Sie die folgende Konfiguration auf der NetScaler VPX-Instanz durch:

-

Binden Sie auf Clientseite das SNIP (1.1.1.2) an die Netzwerkschnittstelle 1/1 und aktivieren Sie den VLAN-Tag-Modus.

bind vlan 2 -ifnum 1/1 –tagged bind vlan 2 -IPAddress 1.1.1.2 255.255.255.0 <!--NeedCopy--> -

Binden Sie auf der Serverseite das SNIP (2.2.2.2) an die Netzwerkschnittstelle 1/1 und aktivieren Sie den VLAN-Tag-Modus.

bind vlan 3 -ifnum 1/2 –tagged bind vlan 3 -IPAddress 2.2.2.2 255.255.255.0 <!--NeedCopy--> -

Fügen Sie einen virtuellen HTTP-Server (1.1.1.100) hinzu und binden Sie ihn an einen Dienst (2.2.2.100).

add lb vserver v1 HTTP 1.1.1.100 80 -persistenceType NONE -Listenpolicy None -cltTimeout 180 add service s1 2.2.2.100 HTTP 80 -gslb NONE -maxClient 0 -maxReq 0 -cip DISABLED -usip NO -useproxyport YES -sp ON -cltTimeout 180 -svrTimeout 360 -CKA NO -TCPB NO -CMP NO bind lb vserver v1 s1 <!--NeedCopy-->

Hinweis:

Stellen Sie sicher, dass Sie die folgenden beiden Einträge in die Routentabelle aufnehmen:

- 1.1.1.0/24 Subnetz mit Gateway, das auf SNIP zeigt 1.1.1.2

- 2.2.2.0/24 Subnetz mit Gateway, das auf SNIP zeigt 2.2.2.2

NetScaler VPX mit VMXNET3-Netzwerkschnittstellen

Um eine hohe Leistung für VPX mit VMXNET3-Netzwerkschnittstellen zu erzielen, nehmen Sie die folgenden Einstellungen auf dem VMware ESX-Host vor:

- Erstellen Sie zwei vNICs aus einem pNIC vSwitch. Mehrere vNICs erstellen mehrere Rx-Threads im ESX-Host. Dies erhöht den Rx-Durchsatz der pNIC-Schnittstelle.

- Aktivieren Sie VLANs auf der vSwitch-Portgruppenebene für jede von Ihnen erstellte vNIC.

- Um den vNIC-Übertragungsdurchsatz (Tx) zu erhöhen, verwenden Sie einen separaten Tx-Thread im ESX-Host pro vNIC. Verwenden Sie die folgenden ESX-Befehle:

- Für ESX Version 5.5:

esxcli system settings advanced set –o /Net/NetTxWorldlet –i <!--NeedCopy-->- Für ESX ab Version 6.0:

esxcli system settings advanced set -o /Net/NetVMTxType –i 1 <!--NeedCopy-->

Führen Sie auf dem VMware ESX-Host die folgende Konfiguration durch:

- Erstellen Sie auf dem VMware ESX-Host zwei vNICs aus einem pNIC vSwitch. Mehrere vNICs erstellen mehrere Tx- und Rx-Threads im ESX-Host. Dies erhöht den Tx- und Rx-Durchsatz der pNIC-Schnittstelle.

- Aktivieren Sie VLANs auf der vSwitch-Portgruppenebene für jede von Ihnen erstellte vNIC.

-

Um den Tx-Durchsatz einer vNIC zu erhöhen, verwenden Sie einen separaten Tx-Vervollständigungs-Thread und Rx-Threads pro Gerät (NIC) -Warteschlange. Verwenden Sie den folgenden Befehl:

esxcli system settings advanced set -o /Net/NetNetqRxQueueFeatPairEnable -i 0 <!--NeedCopy--> -

Konfigurieren Sie eine VM für die Verwendung eines Übertragungs-Threads pro vNIC, indem Sie der Konfiguration der VM die folgende Einstellung hinzufügen:

ethernetX.ctxPerDev = "1" <!--NeedCopy--> -

Konfigurieren Sie eine VM so, dass sie bis zu 8 Übertragungs-Threads pro vNIC verwendet, indem Sie der Konfiguration der VM die folgende Einstellung hinzufügen:

ethernetX.ctxPerDev = "3" <!--NeedCopy-->Hinweis:

Eine Erhöhung der Übertragungs-Threads pro vNIC erfordert mehr CPU-Ressourcen (bis zu 8) auf dem ESX-Host. Stellen Sie sicher, dass genügend CPU-Ressourcen verfügbar sind, bevor Sie die obigen Einstellungen vornehmen.

Weitere Informationen finden Sie unter Best Practices für die Leistungsoptimierung von Telekommunikations- und NFV-Workloads in vSphere

Hinweis:

Stellen Sie sicher, dass Sie den VMware ESX-Host neu starten, um die aktualisierten Einstellungen zu übernehmen.

Sie können VMXNET3 als Bereitstellung mit zwei vNICs pro pNIC konfigurieren. Weitere Informationen finden Sie unter Zwei vNICs pro pNIC-Bereitstellung.

Konfiguration der Multi-Queue- und RSS-Unterstützung auf VMware ESX für VMXNET3-Geräte

Standardmäßig unterstützt das VMXNET3-Gerät nur 8 Rx- und Tx-Warteschlangen. Wenn die Anzahl der vCPUs auf dem VPX 8 überschreitet, wird die Anzahl der für eine VMXNET3-Schnittstelle konfigurierten Rx- und Tx-Warteschlangen standardmäßig auf 1 gesetzt. Sie können bis zu 19 Rx- und Tx-Warteschlangen für VMXNET3-Geräte konfigurieren, indem Sie bestimmte Konfigurationen auf ESX ändern. Diese Option erhöht die Leistung und die gleichmäßige Verteilung der Pakete über die vCPUs der VPX-Instanz.

Hinweis:

Ab NetScaler Version 13.1 Build 48.x unterstützt NetScaler VPX bis zu 19 Rx- und Tx-Warteschlangen auf ESX für VMXNET3-Geräte.

Voraussetzungen:

Um bis zu 19 Rx- und Tx-Warteschlangen auf ESX für VMXNET3-Geräten zu konfigurieren, stellen Sie sicher, dass die folgenden Voraussetzungen erfüllt sind:

- Die NetScaler VPX-Version ist 13.1 Build 48.X und höher.

- NetScaler VPX ist mit einer virtuellen Maschine der Hardwareversion 17 und höher konfiguriert, die von VMware ESX 7.0 und höher unterstützt wird.

Konfigurieren Sie VMXNET3-Schnittstellen für die Unterstützung von mehr als 8 Rx- und Tx-Warteschlangen:

- Öffnen Sie die Konfigurationsdatei der virtuellen Maschine (.vmx).

-

Geben Sie die Anzahl der Rx- und TX-Warteschlangen an, indem Sie die

ethernetX.maxRxQueuesWerteethernetX.maxTxQueuesund konfigurieren (wobei X die Anzahl der zu konfigurierenden virtuellen NICs ist). Die maximale Anzahl der konfigurierten Warteschlangen darf nicht größer als die Anzahl der vCPUs in der virtuellen Maschine sein.Hinweis:

Eine Erhöhung der Anzahl der Warteschlangen erhöht auch den Prozessor-Overhead auf dem ESX-Host. Stellen Sie daher sicher, dass ausreichend CPU-Ressourcen auf dem ESX-Host verfügbar sind, bevor Sie die Warteschlangen erhöhen. Sie können die maximale Anzahl der unterstützten Warteschlangen in Szenarien erhöhen, in denen die Anzahl der Warteschlangen als Leistungsengpass identifiziert wird. In diesen Situationen empfehlen wir, die Anzahl der Warteschlangen schrittweise zu erhöhen. Zum Beispiel von 8 bis 12, dann bis 16, dann bis 20 und so weiter. Bewerten Sie die Leistung bei jeder Einstellung, anstatt sie direkt bis zur Höchstgrenze zu erhöhen.

NetScaler VPX mit SR-IOV- und PCI Passthrough-Netzwerkschnittstellen

Um eine hohe Leistung für VPX mit SR-IOV- und PCI-Passthrough-Netzwerkschnittstellen zu erzielen, siehe Empfohlene Konfiguration auf ESX-Hosts.

Nutzungsrichtlinien für den VMware ESXi Hypervisor

-

Wir empfehlen Ihnen, eine VPX-Instanz auf lokalen Festplatten des Servers oder auf SAN-basierten Speichervolumes bereitzustellen.

Weitere Informationen finden Sie im Abschnitt VMware ESXi CPU Considerations im Dokument Performance Best Practices for VMware vSphere 6.5. Hier ist ein Auszug:

-

Es wird nicht empfohlen, virtuelle Maschinen mit hohem CPU- oder Speicherbedarf auf einem überlasteten Host oder Cluster bereitzustellen.

-

In den meisten Umgebungen ermöglicht ESXi eine erhebliche CPU-Überbelegung, ohne die Leistung der virtuellen Maschine zu beeinträchtigen. Auf einem Host können Sie mehr vCPUs ausführen als die Gesamtzahl der physischen Prozessorkerne in diesem Host.

-

Wenn ein ESXi-Host CPU-gesättigt wird, d.h. die virtuellen Maschinen und andere Lasten auf dem Host alle CPU-Ressourcen verlangen, die der Host hat, funktionieren latenzsensitive Workloads möglicherweise nicht gut. Reduzieren Sie in diesem Fall beispielsweise die CPU-Last, indem Sie einige virtuelle Maschinen ausschalten oder sie auf einen anderen Host migrieren (oder DRS erlauben, sie automatisch zu migrieren).

-

NetScaler empfiehlt, die neueste Hardwarekompatibilitätsversion zu verwenden, um die neuesten Funktionen des ESXi Hypervisors für die virtuelle Maschine nutzen zu können. Weitere Informationen zur Hardware- und ESXi-Versionskompatibilität finden Sie in der VMware-Dokumentation.

-

Der NetScaler VPX ist eine latenzempfindliche, leistungsstarke virtuelle Appliance. Um die erwartete Leistung zu erbringen, benötigt die Appliance vCPU-Reservierung, Speicherreservierung und vCPU-Pinning auf dem Host. Außerdem muss Hyper-Threading auf dem Host deaktiviert werden. Wenn der Host diese Anforderungen nicht erfüllt, können die folgenden Probleme auftreten:

- Failover mit hoher Verfügbarkeit

- CPU-Spitze innerhalb der VPX-Instanz

- Trägheit beim Zugriff auf die VPX-CLI

- Absturz des Pitboss-Daemons

- Paket wird gelöscht

- Niedriger Durchsatz

-

Ein Hypervisor gilt als übermäßig bereitgestellt, wenn eine der folgenden beiden Bedingungen erfüllt ist:

-

Die Gesamtzahl der auf dem Host bereitgestellten virtuellen Kerne (vCPU) ist größer als die Gesamtzahl der physischen Kerne (pCPUs).

-

Die Gesamtzahl der bereitgestellten VMs verbrauchen mehr vCPUs als die Gesamtzahl der pCPUs.

Wenn eine Instanz übermäßig bereitgestellt wird, garantiert der Hypervisor möglicherweise nicht die für die Instanz reservierten Ressourcen (wie CPU, Speicher und andere) aufgrund von Hypervisor-Planungs-Overheads, Fehlern oder Einschränkungen mit dem Hypervisor. **Dieses Verhalten kann zu einem Mangel an CPU-Ressourcen für NetScaler führen und zu den im ersten Punkt unter Nutzungsrichtlinien genannten Problemen führen. Wir empfehlen den Administratoren, die Tenancy des Hosts so zu reduzieren, dass die Gesamtzahl der auf dem Host bereitgestellten vCPUs kleiner oder gleich der Gesamtzahl der pCPUs ist.

Beispiel:

Wenn für den ESX-Hypervisor der Parameter

%RDY%einer VPX-vCPU in der Befehlsausgabeesxtopgrößer als 0 ist, wird für den ESX-Host ein Planungsaufwand gemeldet, der zu latenzbedingten Problemen für die VPX-Instanz führen kann.Reduzieren Sie in einer solchen Situation die Mandanten auf dem Host, sodass

%RDY%immer auf 0 zurückkehrt. Wenden Sie sich alternativ an den Hypervisor-Anbieter, um den Grund für die Nichteinhaltung der Ressourcenreservierung zu ermitteln.

-

Befehle zur Steuerung der CPU-Auslastung der Paket-Engine

Sie können zwei Befehle (set ns vpxparam und show ns vpxparam) verwenden, um das CPU-Auslastungsverhalten von VPX-Instanzen in Hypervisor- und Cloud-Umgebungen zu steuern:

-

set ns vpxparam [-cpuyield (YES | NO | DEFAULT)] [-masterclockcpu1 (YES | NO)]Erlauben Sie jeder VM, die CPU-Ressourcen zu verwenden, die einer anderen VM zugewiesen sind, aber nicht verwendet werden.

Parameter für

Set ns vpxparam:-cpuyield: Freigabe von zugewiesenen, aber nicht genutzten CPU-Ressourcen.

-

YES: Erlauben Sie, dass zugewiesene, aber ungenutzte CPU-Ressourcen von einer anderen VM verwendet werden.

-

NEIN: Reservieren Sie alle CPU-Ressourcen für die VM, der sie zugewiesen wurden. Diese Option zeigt in Hypervisor- und Cloud-Umgebungen einen höheren Prozentsatz für die VPX-CPU-Auslastung.

-

DEFAULT: Nein.

Hinweis:

Auf allen NetScaler VPX-Plattformen beträgt die vCPU-Auslastung auf dem Hostsystem 100 Prozent. Verwenden Sie den Befehl

set ns vpxparam –cpuyield YES, um diese Verwendung zu überschreiben.Wenn Sie die Clusterknoten auf “yield” setzen möchten, müssen Sie die folgenden zusätzlichen Konfigurationen für CCO durchführen:

- Wenn ein Cluster gebildet wird, werden alle Knoten auf “yield=default” gesetzt.

- Wenn ein Cluster unter Verwendung der Knoten gebildet wird, die bereits auf “yield=YES” eingestellt sind, werden die Knoten mit “yield=DEFAULT” zum Cluster hinzugefügt.

Hinweis:

Wenn Sie die Clusterknoten auf “yield=YES” setzen möchten, können Sie erst nach der Bildung des Clusters konfigurieren, aber nicht bevor der Cluster gebildet wurde.

-masterclockcpu1: Sie können die Haupttaktquelle von CPU0 (Management-CPU) auf CPU1 verschieben. Dieser Parameter hat die folgenden Optionen:

-

YES: Erlauben Sie der VM, die Haupttaktquelle von CPU0 auf CPU1 zu verschieben.

-

NO: VM verwendet CPU0 für die Haupttaktquelle. Standardmäßig ist CPU0 die Haupttaktquelle.

-

-

show ns vpxparamDieser Befehl zeigt die aktuellen

vpxparamEinstellungen an.

NetScaler VPX-Instanz auf Linux-KVM-Plattform

Dieser Abschnitt enthält Details zu konfigurierbaren Optionen und Einstellungen sowie andere Vorschläge, mit denen Sie eine optimale Leistung der NetScaler VPX-Instanz auf der Linux-KVM-Plattform erzielen können.

- Leistungseinstellungen für KVM

- NetScaler VPX mit PV-Netzwerkschnittstellen

- NetScaler VPX mit SR-IOV und Fortville PCIe Passthrough-Netzwerkschnittstellen

Leistungseinstellungen für KVM

Nehmen Sie die folgenden Einstellungen auf dem KVM-Host vor:

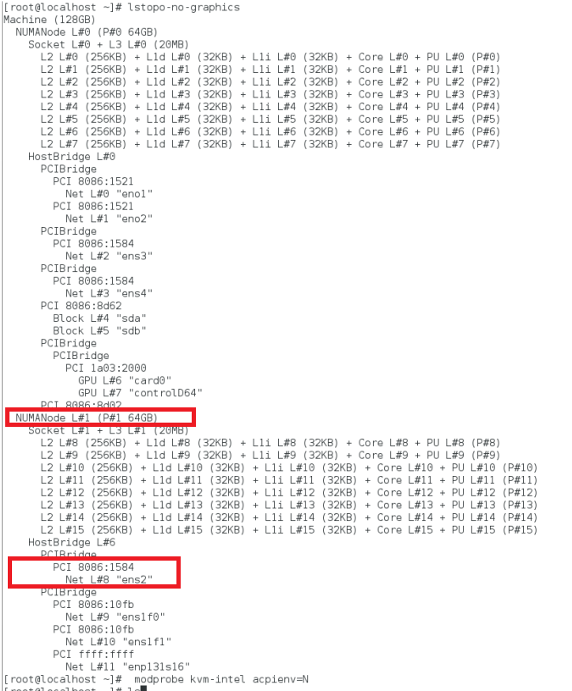

Finden Sie die NUMA-Domäne der NIC mit dem Befehl lstopo:

Stellen Sie sicher, dass der Speicher für den VPX und die CPU an derselben Stelle angeheftet ist. In der folgenden Ausgabe ist die 10G-NIC “ens2” an die NUMA-Domäne #1 gebunden.

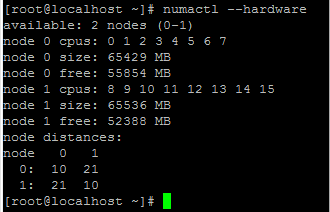

Weisen Sie den VPX-Speicher aus der NUMA-Domäne zu.

Der numactl Befehl gibt die NUMA-Domäne an, von der der Speicher zugewiesen wird. In der folgenden Ausgabe werden etwa 10 GB RAM vom NUMA-Knoten #0 zugewiesen.

Gehen Sie folgendermaßen vor, um die NUMA-Knotenzuordnung zu ändern.

-

Bearbeiten Sie die XML des VPX auf dem Host.

/etc/libvirt/qemu/<VPX_name>.xml <!--NeedCopy--> -

Fügen Sie das folgende Tag hinzu:

<numatune> <memory mode="strict" nodeset="1"/> This is the NUMA domain name </numatune> <!--NeedCopy--> -

Fahren Sie den VPX herunter.

-

Führen Sie den folgenden Befehl aus:

virsh define /etc/libvirt/qemu/<VPX_name>.xml <!--NeedCopy-->Dieser Befehl aktualisiert die Konfigurationsinformationen für die VM mit den NUMA-Knotenzuordnungen.

-

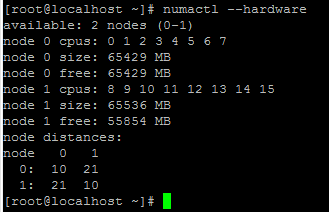

Schalten Sie den VPX ein. Überprüfen Sie dann die

numactl –hardwareBefehlsausgabe auf dem Host, um die aktualisierten Speicherzuweisungen für den VPX zu sehen.

Pin vCPUs von VPX an physische Kerne.

-

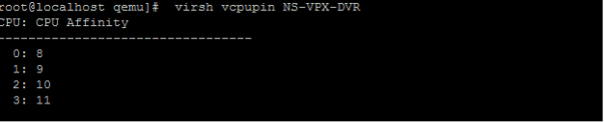

Um die vCPU zu pCPU-Zuordnungen einer VPX anzuzeigen, geben Sie den folgenden Befehl ein

virsh vcpupin <VPX name> <!--NeedCopy-->

Die vCPUs 0−4 werden physikalischen Kernen 8−11 zugeordnet.

-

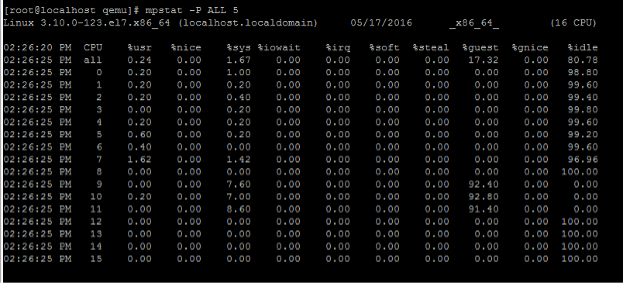

Um die aktuelle pCPU-Nutzung anzuzeigen, geben Sie den folgenden Befehl ein:

mpstat -P ALL 5 <!--NeedCopy-->

In dieser Ausgabe ist 8 Management-CPU und 9−11 Paket-Engines.

-

Um die vCPU auf pCPU-Pinning zu ändern, gibt es zwei Möglichkeiten.

-

Ändern Sie es zur Laufzeit, nachdem der VPX mit dem folgenden Befehl hochgefahren wurde:

virsh vcpupin <VPX name> <vCPU id> <pCPU number> virsh vcpupin NetScaler-VPX-XML 0 8 virsh vcpupin NetScaler-VPX-XML 1 9 virsh vcpupin NetScaler-VPX-XML 2 10 virsh vcpupin NetScaler-VPX-XML 3 11 <!--NeedCopy--> -

Um statische Änderungen an der VPX vorzunehmen, bearbeiten Sie die

.xmlDatei wie zuvor mit den folgenden Tags:-

Bearbeiten Sie die XML-Datei des VPX auf dem Host

/etc/libvirt/qemu/<VPX_name>.xml <!--NeedCopy--> -

Fügen Sie das folgende Tag hinzu:

<vcpu placement='static' cpuset='8-11'>4</vcpu> <cputune> <vcpupin vcpu='0' cpuset='8'/> <vcpupin vcpu='1' cpuset='9'/> <vcpupin vcpu='2' cpuset='10'/> <vcpupin vcpu='3' cpuset='11'/> </cputune> <!--NeedCopy--> -

Fahren Sie den VPX herunter.

-

Aktualisieren Sie die Konfigurationsinformationen für die VM mit den NUMA-Knotenzuordnungen mithilfe des folgenden Befehls:

virsh define /etc/libvirt/qemu/ <VPX_name>.xml <!--NeedCopy--> -

Schalten Sie den VPX ein. Überprüfen Sie dann die

virsh vcpupin <VPX name>Befehlsausgabe auf dem Host, um das aktualisierte CPU-Pinning zu sehen.

-

-

Eliminieren Sie Host-Interrupt-Overhead.

-

Erkennt VM_EXITS mithilfe des

kvm_statBefehls.Auf Hypervisor-Ebene werden Host-Interrupts denselben PCPUs zugeordnet, auf denen die vCPUs des VPX angeheftet sind. Dies kann dazu führen, dass vCPUs auf dem VPX regelmäßig rausgeschmissen werden.

Verwenden Sie den

kvm_statBefehl, um die VM-Exits zu finden, die von VMs durchgeführt wurden, auf denen der Host ausgeführt wird[root@localhost ~]# kvm_stat -1 | grep EXTERNAL kvm_exit(EXTERNAL_INTERRUPT) 1728349 27738 [root@localhost ~]# <!--NeedCopy-->Ein höherer Wert in der Größenordnung von 1+M weist auf ein Problem hin.

Wenn eine einzelne VM vorhanden ist, beträgt der erwartete Wert 30−100 K. Alles andere kann darauf hinweisen, dass ein oder mehrere Host-Interrupt-Vektoren derselben pCPU zugeordnet sind.

-

Erkennen Sie Host-Interrupts und migrieren Sie Host-Interrupts.

Wenn Sie den

concatenateBefehl für die Datei “/proc/interrupts” ausführen, werden alle Host-Interrupt-Zuordnungen angezeigt. Wenn ein oder mehrere aktive IRQs derselben pCPU zugeordnet werden, erhöht sich der entsprechende Zähler.Verschieben Sie alle Interrupts, die sich mit den PCPUs Ihres NetScaler VPX überschneiden, auf ungenutzte PCPUs:

echo 0000000f > /proc/irq/55/smp_affinity 0000000f - - > it is a bitmap, LSBs indicates that IRQ 55 can only be scheduled on pCPUs 0 – 3 <!--NeedCopy--> -

Deaktivieren Sie das IRQ Guthaben

Deaktivieren Sie den IRQ-Balance-Daemon, damit im laufenden Betrieb keine Umschuldung erfolgt.

service irqbalance stop service irqbalance show - To check the status service irqbalance start - Enable if needed <!--NeedCopy-->Stellen Sie sicher, dass Sie den

kvm_statBefehl ausführen, um sicherzustellen, dass es nicht viele Zähler gibt.

NetScaler VPX mit PV-Netzwerkschnittstellen

Sie können Para-Virtualization (PV), SR-IOV und PCIe-Passthrough-Netzwerkschnittstellen als Zwei vNICs pro pNIC-Bereitstellung konfigurieren. Weitere Informationen finden Sie unter Zwei vNICs pro pNIC-Bereitstellung.

Gehen Sie folgendermaßen vor, um eine optimale Leistung von PV (virtio) -Schnittstellen zu erzielen:

- Identifizieren Sie die NUMA-Domäne, zu der der PCIe-Steckplatz/die NIC gehört.

- Der Speicher und die vCPU für den VPX müssen an dieselbe NUMA-Domäne angeheftet sein.

- Der Vhost-Thread muss an die CPUs in derselben NUMA-Domäne gebunden sein.

Binden Sie die virtuellen Host-Threads an die entsprechenden CPUs:

-

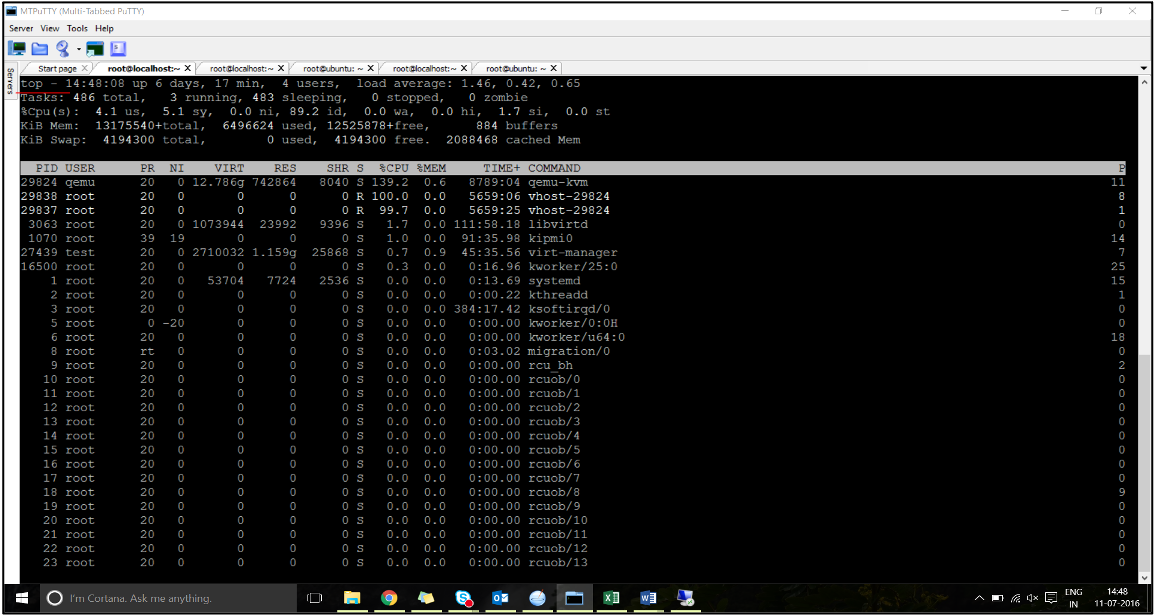

Sobald der Verkehr gestartet wurde, führen Sie den

topBefehl auf dem Host aus.

- Identifizieren Sie die Affinität des virtuellen Host-Prozesses (benannt als

vhost-<pid-of-qemu>). -

Binden Sie die vHost-Prozesse mit dem folgenden Befehl an die zuvor identifizierten physischen Kerne in der NUMA-Domäne:

taskset –pc <core-id> <process-id> <!--NeedCopy-->Beispiel:

taskset –pc 12 29838 <!--NeedCopy--> -

Die Prozessorkerne, die der NUMA-Domäne entsprechen, können mit dem folgenden Befehl identifiziert werden:

[root@localhost ~]# virsh capabilities | grep cpu <cpu> </cpu> <cpus num='8'> <cpu id='0' socket_id='0' core_id='0' siblings='0'/> <cpu id='1' socket_id='0' core_id='1' siblings='1'/> <cpu id='2' socket_id='0' core_id='2' siblings='2'/> <cpu id='3' socket_id='0' core_id='3' siblings='3'/> <cpu id='4' socket_id='0' core_id='4' siblings='4'/> <cpu id='5' socket_id='0' core_id='5' siblings='5'/> <cpu id='6' socket_id='0' core_id='6' siblings='6'/> <cpu id='7' socket_id='0' core_id='7' siblings='7'/> </cpus> <cpus num='8'> <cpu id='8' socket_id='1' core_id='0' siblings='8'/> <cpu id='9' socket_id='1' core_id='1' siblings='9'/> <cpu id='10' socket_id='1' core_id='2' siblings='10'/> <cpu id='11' socket_id='1' core_id='3' siblings='11'/> <cpu id='12' socket_id='1' core_id='4' siblings='12'/> <cpu id='13' socket_id='1' core_id='5' siblings='13'/> <cpu id='14' socket_id='1' core_id='6' siblings='14'/> <cpu id='15' socket_id='1' core_id='7' siblings='15'/> </cpus> <cpuselection/> <cpuselection/> <!--NeedCopy-->

Binden Sie den QEMU-Prozess an den entsprechenden physikalischen Kern:

- Identifizieren Sie die physikalischen Kerne, auf denen der QEMU-Prozess läuft. Weitere Informationen finden Sie in der vorhergehenden Ausgabe.

-

Binden Sie den QEMU-Prozess mit dem folgenden Befehl an dieselben physikalischen Kerne, an die Sie die vCPUs binden:

taskset –pc 8-11 29824 <!--NeedCopy-->

NetScaler VPX mit SR-IOV und Fortville PCIe Passthrough-Netzwerkschnittstellen

Gehen Sie folgendermaßen vor, um eine optimale Leistung der SR-IOV- und Fortville PCIe-Passthrough-Netzwerkschnittstellen zu erzielen:

- Identifizieren Sie die NUMA-Domäne, zu der der PCIe-Steckplatz/die NIC gehört.

- Der Speicher und die vCPU für den VPX müssen an dieselbe NUMA-Domäne angeheftet sein.

Beispiel für eine VPX-XML-Datei für vCPU und Speicher-Pinning für Linux KVM:

<domain type='kvm'>

<name>NetScaler-VPX</name>

<uuid>138f7782-1cd3-484b-8b6d-7604f35b14f4</uuid>

<memory unit='KiB'>8097152</memory>

<currentMemory unit='KiB'>8097152</currentMemory>

<vcpu placement='static'>4</vcpu>

<cputune>

<vcpupin vcpu='0' cpuset='8'/>

<vcpupin vcpu='1' cpuset='9'/>

<vcpupin vcpu='2' cpuset='10'/>

<vcpupin vcpu='3' cpuset='11'/>

</cputune>

<numatune>

<memory mode='strict' nodeset='1'/>

</numatune>

</domain>

<!--NeedCopy-->

NetScaler VPX-Instanz auf Citrix Hypervisors

Dieser Abschnitt enthält Details zu konfigurierbaren Optionen und Einstellungen sowie andere Vorschläge, mit denen Sie eine optimale Leistung der NetScaler VPX-Instanz auf Citrix Hypervisors erzielen können.

- Leistungseinstellungen für Citrix Hypervisors

- NetScaler VPX mit SR-IOV-Netzwerkschnittstellen

- NetScaler VPX mit paravirtualisierten Schnittstellen

Leistungseinstellungen für Citrix Hypervisors

Finden Sie die NUMA-Domäne der NIC mit dem Befehl “xl”:

xl info -n

<!--NeedCopy-->

Pin vCPUs von VPX an physische Kerne.

xl vcpu-pin <Netsclaer VM Name> <vCPU id> <physical CPU id>

<!--NeedCopy-->

Überprüfen Sie die Bindung von vCPUs.

xl vcpu-list

<!--NeedCopy-->

Weisen Sie NetScaler VMs mehr als 8 vCPUs zu.

Führen Sie zum Konfigurieren von mehr als 8 vCPUs die folgenden Befehle von der Citrix Hypervisor-Konsole aus:

xe vm-param-set uuid=your_vms_uuid VCPUs-max=16

xe vm-param-set uuid=your_vms_uuid VCPUs-at-startup=16

<!--NeedCopy-->

NetScaler VPX mit SR-IOV-Netzwerkschnittstellen

Gehen Sie folgendermaßen vor, um eine optimale Leistung der SR-IOV-Netzwerkschnittstellen zu erzielen:

- Identifizieren Sie die NUMA-Domäne, an die der PCIe-Steckplatz oder die NIC gebunden ist.

- Stecken Sie den Speicher und die vCPU für den VPX an dieselbe NUMA-Domäne an.

- Binden Sie die Domain-0 vCPU an die verbleibende CPU.

NetScaler VPX mit paravirtualisierten Schnittstellen

Für eine optimale Leistung werden zwei vNICs pro pNIC und eine vNIC pro pNIC-Konfiguration empfohlen, wie in anderen PV-Umgebungen.

Gehen Sie folgendermaßen vor, um eine optimale Leistung paravirtualisierter (Netfront) Schnittstellen zu erzielen:

- Identifizieren Sie die NUMA-Domäne, zu der der PCIe-Steckplatz oder die NIC gehört.

- Stecken Sie den Speicher und die vCPU für den VPX an dieselbe NUMA-Domäne an.

- Binden Sie die Domain-0 vCPU an die verbleibende CPU derselben NUMA-Domäne.

- Pin Host Rx/Tx-Threads von vNIC an Domain-0 vCPUs.

Host-Threads an Domain-0 vCPUs anheften:

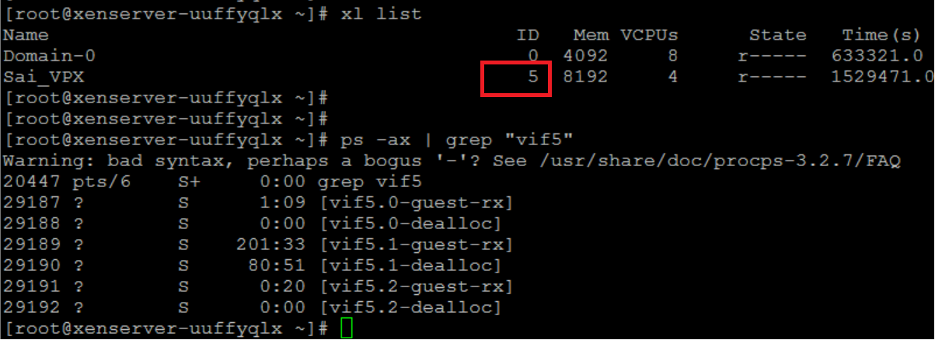

- Suchen Sie die Xen-ID des VPX mithilfe des

xl listBefehls auf der Citrix Hypervisor Hostshell. -

Identifizieren Sie Host-Threads mithilfe des folgenden Befehls:

ps -ax | grep vif <Xen-ID> <!--NeedCopy-->Im folgenden Beispiel zeigen diese Werte an:

- vif5.0 − Die Threads für die erste Schnittstelle, die VPX in XenCenter (Verwaltungsschnittstelle) zugewiesen ist.

- vif5.1 − Die Threads für die zweite Schnittstelle, die VPX usw. zugewiesen ist.

-

Stecken Sie die Threads mit dem folgenden Befehl an Domain-0 vCPUs an:

taskset –pc <core-id> <process-id> <!--NeedCopy-->Beispiel:

taskset -pc 1 29189 <!--NeedCopy-->

Teilen

Teilen

This Preview product documentation is Cloud Software Group Confidential.

You agree to hold this documentation confidential pursuant to the terms of your Cloud Software Group Beta/Tech Preview Agreement.

The development, release and timing of any features or functionality described in the Preview documentation remains at our sole discretion and are subject to change without notice or consultation.

The documentation is for informational purposes only and is not a commitment, promise or legal obligation to deliver any material, code or functionality and should not be relied upon in making Cloud Software Group product purchase decisions.

If you do not agree, select I DO NOT AGREE to exit.