-

Bereitstellen einer NetScaler ADC VPX- Instanz

-

Support-Matrix und Nutzungsrichtlinien

-

Optimieren der Leistung von NetScaler ADC VPX auf VMware ESX, Linux KVM und Citrix Hypervisors

-

Installieren einer NetScaler ADC VPX Instanz auf einem Bare-Metal-Server

-

Installieren einer NetScaler ADC VPX-Instanz auf Citrix Hypervisor

-

Installieren einer NetScaler ADC VPX-Instanz in der VMware Cloud auf AWS

-

Installieren einer NetScaler ADC VPX-Instanz auf Microsoft Hyper-V-Servern

-

Installieren einer NetScaler ADC VPX-Instanz auf der Linux-KVM-Plattform

-

Bereitstellen einer NetScaler ADC VPX-Instanz auf AWS

-

Bereitstellen einer eigenständigen NetScaler ADC VPX-Instanz auf AWS

-

Bereitstellen eines VPX-HA-Paar in derselben AWS-Verfügbarkeitszone

-

Bereitstellen eines VPX Hochverfügbarkeitspaars mit privaten IP-Adressen in verschiedenen AWS-Zonen

-

Bereitstellen einer NetScaler ADC VPX-Instanz auf AWS Outposts

-

Konfigurieren einer NetScaler ADC VPX-Instanz für die Verwendung der SR-IOV-Netzwerkschnittstelle

-

Konfigurieren einer NetScaler ADC VPX-Instanz für die Verwendung von Enhanced Networking mit AWS ENA

-

Bereitstellen einer NetScaler ADC VPX-Instanz auf Microsoft Azure

-

Netzwerkarchitektur für NetScaler ADC VPX-Instanzen auf Microsoft Azure

-

Mehrere IP-Adressen für eine eigenständige NetScaler ADC VPX-Instanz konfigurieren

-

Hochverfügbarkeitssetup mit mehreren IP-Adressen und NICs konfigurieren

-

Hochverfügbarkeitssetup mit mehreren IP-Adressen und NICs über PowerShell-Befehle konfigurieren

-

NetScaler ADC VPX-Instanz für beschleunigte Azure-Netzwerke konfigurieren

-

HA-INC-Knoten über die Citrix Hochverfügbarkeitsvorlage mit Azure ILB konfigurieren

-

NetScaler ADC VPX-Instanz auf der Azure VMware-Lösung installieren

-

Konfigurieren von GSLB in einem Active-Standby-Hochverfügbarkeitssetup

-

Konfigurieren von Adresspools (IIP) für eine NetScaler Gateway Appliance

-

NetScaler ADC VPX-Instanz auf der Google Cloud Platform bereitstellen

-

Bereitstellung und Konfigurationen von NetScaler ADC automatisieren

-

-

Lösungen für Telekommunikationsdienstleister

-

Authentifizierung, Autorisierung und Überwachung des Anwendungsverkehrs

-

Wie Authentifizierung, Autorisierung und Auditing funktionieren

-

Grundkomponenten der Authentifizierung, Autorisierung und Audit-Konfiguration

-

Lokal NetScaler Gateway als Identitätsanbieter für Citrix Cloud

-

Authentifizierungs-, Autorisierungs- und Überwachungskonfiguration für häufig verwendete Protokolle

-

-

-

-

Konfigurieren von erweiterten Richtlinienausdrücken: Erste Schritte

-

Erweiterte Richtlinienausdrücke: Arbeiten mit Datumsangaben, Zeiten und Zahlen

-

Erweiterte Richtlinienausdrücke: Analysieren von HTTP-, TCP- und UDP-Daten

-

Erweiterte Richtlinienausdrücke: Analysieren von SSL-Zertifikaten

-

Erweiterte Richtlinienausdrücke: IP- und MAC-Adressen, Durchsatz, VLAN-IDs

-

Erweiterte Richtlinienausdrücke: Stream-Analytics-Funktionen

-

Zusammenfassende Beispiele für Standardsyntaxausdrücke und -richtlinien

-

Tutorial Beispiele für Standardsyntaxrichtlinien für Rewrite

-

Migration von Apache mod_rewrite-Regeln auf die Standardsyntax

-

-

-

-

-

-

-

-

Verwalten eines virtuellen Cache-Umleitungsservers

-

Statistiken für virtuelle Server zur Cache-Umleitung anzeigen

-

Aktivieren oder Deaktivieren eines virtuellen Cache-Umleitungsservers

-

Direkte Richtlinieneinschläge auf den Cache anstelle des Ursprungs

-

Verwalten von Clientverbindungen für einen virtuellen Server

-

Externe TCP-Integritätsprüfung für virtuelle UDP-Server aktivieren

-

-

Übersetzen die Ziel-IP-Adresse einer Anfrage in die Ursprungs-IP-Adresse

-

-

Unterstützung für NetScaler ADC-Konfiguration in einem Cluster

-

Verwalten des NetScaler ADC Clusters

-

Knotengruppen für gepunktete und teilweise gestreifte Konfigurationen

-

Entfernen eines Knotens aus einem Cluster, der mit Cluster-Link-Aggregation bereitgestellt wird

-

Überwachen von Fehlern bei der Befehlsausbreitung in einer Clusterbereitstellung

-

VRRP-Interface-Bindung in einem aktiven Cluster mit einem einzigen Knoten

-

-

-

Konfigurieren von NetScaler ADC als nicht-validierenden sicherheitsbewussten Stub-Resolver

-

Jumbo-Frames Unterstützung für DNS zur Handhabung von Reaktionen großer Größen

-

Zwischenspeichern von EDNS0-Client-Subnetzdaten bei einer NetScaler ADC-Appliance im Proxymodus

-

-

GSLB-Entitäten einzeln konfigurieren

-

Anwendungsfall: Bereitstellung einer Domänennamen-basierten Autoscale-Dienstgruppe

-

Anwendungsfall: Bereitstellung einer IP-Adressbasierten Autoscale-Dienstgruppe

-

-

-

IP-Adresse und Port eines virtuellen Servers in den Request-Header einfügen

-

Angegebene Quell-IP für die Back-End-Kommunikation verwenden

-

Quellport aus einem bestimmten Portbereich für die Back-End-Kommunikation verwenden

-

Quell-IP-Persistenz für Back-End-Kommunikation konfigurieren

-

Lokale IPv6-Linkadressen auf der Serverseite eines Load Balancing-Setups

-

Erweiterte Load Balancing-Einstellungen

-

Allmählich die Belastung eines neuen Dienstes mit virtuellem Server-Level erhöhen

-

Anwendungen vor Verkehrsspitzen auf geschützten Servern schützen

-

Bereinigung von virtuellen Server- und Dienstverbindungen ermöglichen

-

Persistenzsitzung auf TROFS-Diensten aktivieren oder deaktivieren

-

Externe TCP-Integritätsprüfung für virtuelle UDP-Server aktivieren

-

Standortdetails von der Benutzer-IP-Adresse mit der Geolocation-Datenbank abrufen

-

Quell-IP-Adresse des Clients beim Verbinden mit dem Server verwenden

-

Limit für die Anzahl der Anfragen pro Verbindung zum Server festlegen

-

Festlegen eines Schwellenwerts für die an einen Dienst gebundenen Monitore

-

Grenzwert für die Bandbreitenauslastung durch Clients festlegen

-

-

-

Lastausgleichs für häufig verwendete Protokolle konfigurieren

-

Anwendungsfall 5: DSR-Modus beim Verwenden von TOS konfigurieren

-

Anwendungsfall 6: Lastausgleich im DSR-Modus für IPv6-Netzwerke mit dem TOS-Feld konfigurieren

-

Anwendungsfall 7: Konfiguration des Lastenausgleichs im DSR-Modus mithilfe von IP Over IP

-

Anwendungsfall 8: Lastausgleich im Einarmmodus konfigurieren

-

Anwendungsfall 9: Lastausgleich im Inlinemodus konfigurieren

-

Anwendungsfall 10: Lastausgleich von Intrusion-Detection-System-Servern

-

Anwendungsfall 11: Netzwerkverkehr mit Listenrichtlinien isolieren

-

Anwendungsfall 12: Citrix Virtual Desktops für den Lastausgleich konfigurieren

-

Anwendungsfall 13: Citrix Virtual Apps für den Lastausgleich konfigurieren

-

Anwendungsfall 14: ShareFile-Assistent zum Lastausgleich Citrix ShareFile

-

Anwendungsfall 15: Layer-4-Lastausgleich auf der NetScaler ADC-Appliance konfigurieren

-

SSL-Offload und Beschleunigung

-

Unterstützung des TLSv1.3-Protokolls wie in RFC 8446 definiert

-

Unterstützungsmatrix für Serverzertifikate auf der ADC-Appliance

-

Unterstützung für Intel Coleto SSL-Chip-basierte Plattformen

-

Unterstützung für Thales Luna Network Hardwaresicherheitsmodul

-

-

-

-

CloudBridge Connector-Tunnels zwischen zwei Rechenzentren konfigurieren

-

CloudBridge Connector zwischen Datacenter und AWS Cloud konfigurieren

-

CloudBridge Connector Tunnels zwischen einem Rechenzentrum und Azure Cloud konfigurieren

-

CloudBridge Connector Tunnels zwischen Datacenter und SoftLayer Enterprise Cloud konfigurieren

-

-

Konfigurationsdateien in einem Hochverfügbarkeitssetup synchronisieren

-

Hochverfügbarkeitsknoten in verschiedenen Subnetzen konfigurieren

-

Beschränken von Failovers, die durch Routenmonitore im Nicht-INC-Modus verursacht werden

-

HA-Heartbeat-Meldungen auf einer NetScaler ADC-Appliance verwalten

-

NetScaler ADC in einem Hochverfügbarkeitssetup entfernen und ersetzen

This content has been machine translated dynamically.

Dieser Inhalt ist eine maschinelle Übersetzung, die dynamisch erstellt wurde. (Haftungsausschluss)

Cet article a été traduit automatiquement de manière dynamique. (Clause de non responsabilité)

Este artículo lo ha traducido una máquina de forma dinámica. (Aviso legal)

此内容已经过机器动态翻译。 放弃

このコンテンツは動的に機械翻訳されています。免責事項

이 콘텐츠는 동적으로 기계 번역되었습니다. 책임 부인

Este texto foi traduzido automaticamente. (Aviso legal)

Questo contenuto è stato tradotto dinamicamente con traduzione automatica.(Esclusione di responsabilità))

This article has been machine translated.

Dieser Artikel wurde maschinell übersetzt. (Haftungsausschluss)

Ce article a été traduit automatiquement. (Clause de non responsabilité)

Este artículo ha sido traducido automáticamente. (Aviso legal)

この記事は機械翻訳されています.免責事項

이 기사는 기계 번역되었습니다.책임 부인

Este artigo foi traduzido automaticamente.(Aviso legal)

这篇文章已经过机器翻译.放弃

Questo articolo è stato tradotto automaticamente.(Esclusione di responsabilità))

Translation failed!

Support-Matrix und Nutzungsrichtlinien

In diesem Dokument werden die verschiedenen Hypervisoren und Funktionen aufgeführt, die auf einer Citrix ADC VPX-Instanz unterstützt werden. Das Dokument beschreibt auch ihre Nutzungsrichtlinien und bekannte Einschränkungen.

Tabelle 1. VPX-Instanz auf Citrix Hypervisor

| Citrix Hypervisor Version | SysID | VPX Modelle |

|---|---|---|

| 8.2 unterstützt ab 13.0 64.x, 8.0, 7.6, 7.1 | 450000 | VPX 10, VPX 25, VPX 200, VPX 1000, VPX 3000, VPX 5000, VPX 8000, VPX 10G, VPX 15G, VPX 25G, VPX 40G |

Tabelle 2. VPX-Instanz auf dem VMware ESXi-Hypervisor

Die folgenden VPX-Modelle mit 450010 (Sys ID) unterstützen die in der Tabelle aufgeführten VMware ESX-Versionen.

VPX-Modelle: VPX 10, VPX 25, VPX 200, VPX 1000, VPX 3000, VPX 5000, VPX 8000, VPX 10G, VPX 15G, VPX 25G, VPX 40G und VPX 100G.

| ESXi-Version | ESXi-Veröffentlichungsdatum im Format MM/DD/YYYY

|

ESXi-Build-Nummer | Citrix ADC VPX-Version |

|---|---|---|---|

| ESXi 8.0 Update 2 | 09/21/2023 | 22380479 | 13.0-92.x und höhere Builds |

| ESXi 8.0-Aktualisierung 1 | 04/18/2023 | 21495797 | Versionen 13.0-90.x und höher |

| ESXi 8.0c | 03/30/2023 | 21493926 | Versionen 13.0-90.x und höher |

| ESXi 8.0 | 10/11/2022 | 20513097 | Versionen 13.0-90.x und höher |

| ESXi 7.0 Aktualisierung 3n | 07/06/2023 | 21930508 | Versionen 13.0-91.x und höher |

| ESXi 7.0 Update 3m | 05/03/2023 | 21686933 | Versionen 13.0-91.x und höher |

| ESXi 7.0 Update 3i | 12/08/2022 | 20842708 | Versionen 13.0-90.x und höher |

| ESXi 7.0-Update 3f | 07/12/2022 | 20036589 | Versionen 13.0-86.x und höher |

| ESXi 7.0-Update 3d | 03/29/2022 | 19482537 | Versionen 13.0-86.x und höher |

| ESXi 7.0 3c aktualisieren | 01/27/2022 | 19193900 | Versionen 13.0-85.x und höher |

| ESXi 7.0 aktualisiert 2d | 09/14/2021 | 18538813 | Versionen 13.0-83.x und höher |

| ESXi 7.0 Update 2a | 12/17/2020 | 17867351 | Versionen 13.0-82.x und höher |

| ESXi 6.7 P04 | 11/19/2020 | 17167734 | Versionen 13.0-67.x und höher |

| ESXi 6.7 P03 | 08/20/2020 | 16713306 | Versionen 13.0-67.x und höher |

| ESXi 6.7 P02 | 04/28/2020 | 16075168 | Versionen 13.0-67.x und höher |

| ESXi 6.7 Aktualisierung 3 | 08/20/2019 | 14320388 | Versionen 13.0-58.x und höher |

| ESXi 6.5 U1g | 3/20/2018 | 7967591 | 13.0 47.x und höhere Builds |

Hinweis:

Jede ESXi-Patch-Unterstützung wird für die in der obigen Tabelle angegebene Citrix ADC VPX-Version validiert und gilt für alle höheren Builds der Citrix ADC 13.0-Version.

Tabelle 3. VPX auf Microsoft Hyper-V

| Hyper-V-Version | SysID | VPX Modelle |

|---|---|---|

| 2012, 2012R2, 2016, 2019 | 450020 | VPX 10, VPX 25, VPX 200, VPX 1000, VPX 3000 |

VPX-Instanz auf Nutanix AHV

NetScaler VPX wird auf Nutanix AHV durch die Citrix Ready-Partnerschaft unterstützt. Citrix Ready ist ein Technologiepartnerprogramm, das Software- und Hardwareanbieter bei der Entwicklung und Integration ihrer Produkte mit der NetScaler-Technologie für digitale Workspace, Netzwerke und Analysen unterstützt.

Weitere Informationen zu einer schrittweisen Methode zur Bereitstellung einer NetScaler VPX-Instanz auf Nutanix AHV finden Sie unter Deploying aNetScaler VPX auf Nutanix AHV.

Unterstützung durch Dritte:

Wenn Sie Probleme mit der Integration eines bestimmten Drittanbieters (Nutanix AHV) in einer NetScaler-Umgebung haben, wenden Sie sich direkt an den Drittanbieter-Partner (Nutanix).

Wenn der Partner feststellt, dass das Problem offenbar bei NetScaler liegt, kann er sich an den NetScaler-Support wenden, um weitere Unterstützung zu erhalten. Eine dedizierte technische Ressource von Partnern arbeitet mit dem NetScaler-Support zusammen, bis das Problem behoben ist.

Weitere Informationen finden Sie unter Häufig gestellte Fragen zum Citrix Ready-Partnerprogramm.

Tabelle 4. VPX-Instanz auf generischem KVM

| Generische KVM-Version | SysID | VPX Modelle |

|---|---|---|

| RHEL 7.6, RHEL 8.0, RHEL 9.3 | 450070

|

VPX 10, VPX 25, VPX 200, VPX 1000, VPX 3000, VPX 5000, VPX 8000, VPX 10 G, VPX 15 G. VPX 25G, VPX 40G, VPX 100G

|

| Ubuntu 16.04, Ubuntu 18.04, RHV 4.2 |

Zu beachtende Punkte:

Berücksichtigen Sie bei der Verwendung von KVM-Hypervisoren die folgenden Punkte.

-

Die VPX-Instanz ist für Hypervisor Releaseversionen in Tabelle 1−4 und nicht für Patch-Releases innerhalb einer Version qualifiziert. Es wird jedoch erwartet, dass die VPX-Instanz nahtlos mit Patch-Versionen einer unterstützten Version funktioniert. Wenn dies nicht der Fall ist, öffnen Sie einen Supportfall für die Fehlerbehebung und das Debuggen.

-

Verwenden Sie die Befehle

ip link, um RHEL 8.2-Netzwerkbrücken zu konfigurieren. - Bevor Sie RHEL 7.6 verwenden, führen Sie die folgenden Schritte auf dem KVM-Host aus:

-

Bearbeiten Sie /etc/default/grub und hängen Sie

"kvm_intel.preemption_timer=0"an die VariableGRUB_CMDLINE_LINUXan. -

Generieren Sie grub.cfg mit dem Befehl

"# grub2-mkconfig -o /boot/grub2/grub.cfg"neu. -

Starten Sie den Hostcomputer neu.

-

-

Bevor Sie Ubuntu 18.04 verwenden, führen Sie die folgenden Schritte auf dem KVM-Host aus:

- Bearbeiten Sie /etc/default/grub und hängen Sie

"kvm_intel.preemption_timer=0"an die VariableGRUB_CMDLINE_LINUXan. - Generieren Sie grub.cfg mit dem Befehl

"# grub-mkconfig -o /boot/grub/grub.cfg “neu. - Starten Sie den Hostcomputer neu.

- Bearbeiten Sie /etc/default/grub und hängen Sie

Tabelle 5. VPX-Instanz auf AWS

| AWS-Version | SysID | VPX Modelle |

|---|---|---|

| – | 450040 | VPX 10, VPX 200, VPX 1000, VPX 3000, VPX 5000, VPX BYOL, VPX 8000, VPX 10G, VPX 15G und VPX 25G sind nur mit BYOL mit EC2-Instanztypen (C5, M5 und C5n) verfügbar |

Hinweis:

Das VPX 25G-Angebot bietet nicht den gewünschten 25G-Durchsatz in AWS, kann jedoch im Vergleich zum VPX 15G-Angebot eine höhere SSL-Transaktionsrate bieten.

Tabelle 6. VPX-Instanz auf Azure

| Azure-Version | SysID | VPX Modelle |

|---|---|---|

| – | 450020 | VPX 10, VPX 200, VPX 1000, VPX 3000, VPX 5000, VPX BYOL |

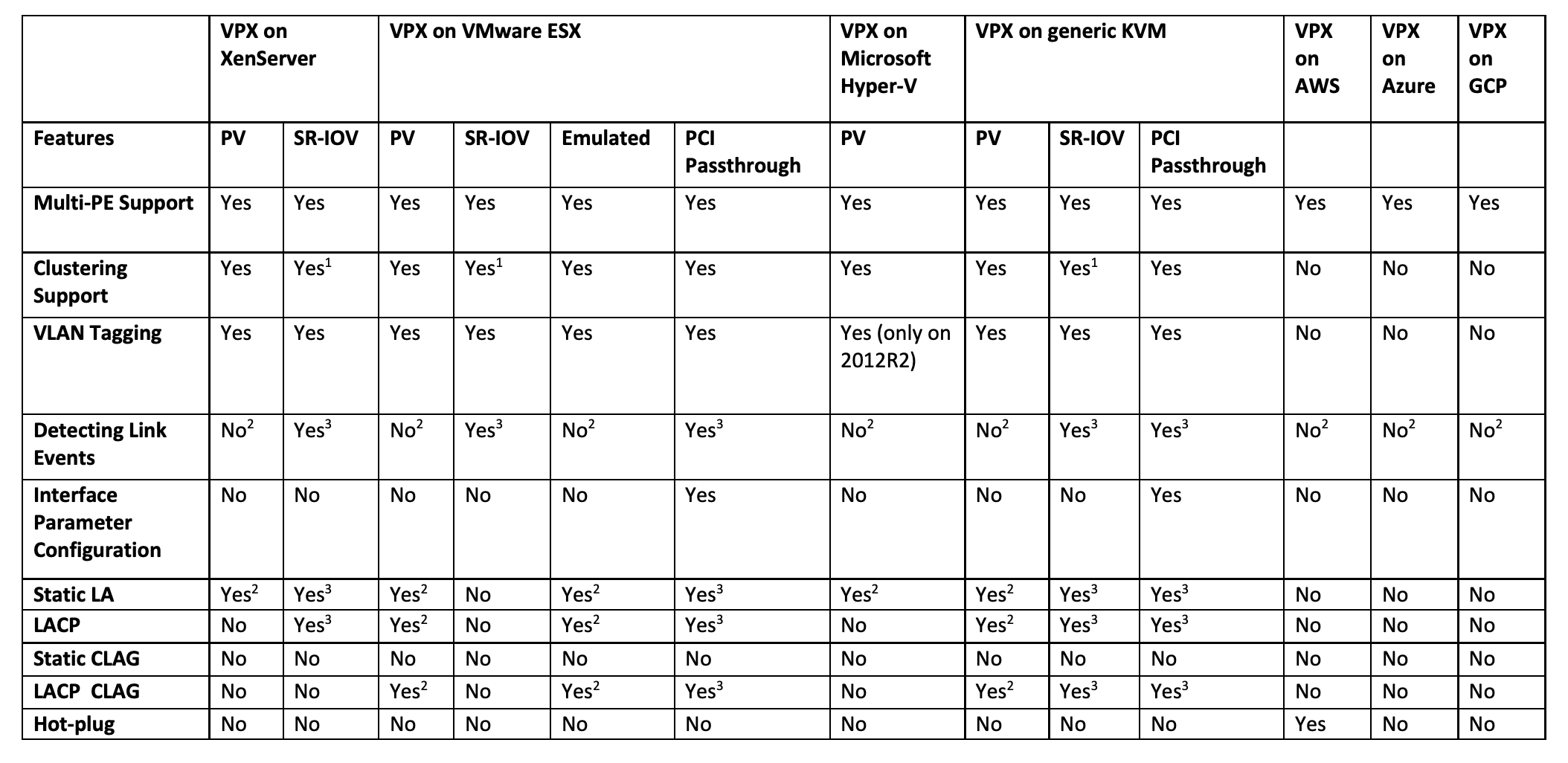

Tabelle 7. VPX-Feature-Matrix

Die in der vorstehenden Tabelle verwendeten hochgestellten Zahlen (1, 2, 3) beziehen sich auf die folgenden Punkte mit entsprechender Nummerierung:

-

Clustering-Unterstützung ist auf SRIOV für clientseitige und serverseitige Schnittstellen und nicht für die Rückwandplatine verfügbar.

-

Interface DOWN Ereignisse werden in Citrix ADC VPX-Instanzen nicht aufgezeichnet.

-

Für statische LA wird möglicherweise weiterhin Datenverkehr auf der Schnittstelle gesendet, deren physischer Status DOWN ist.

-

Für LACP kennt das Peer-Gerät das Interface DOWN-Ereignis basierend auf dem LACP-Timeout-Mechanismus.

- Kurzes Timeout: 3 Sekunden

- Langes Timeout: 90 Sekunden

-

Teilen Sie für LACP keine Schnittstellen zwischen VMs.

-

Bei dynamischem Routing hängt die Konvergenzzeit vom Routingprotokoll ab, da Linkereignisse nicht erkannt werden.

-

Die überwachte statische Route-Funktionalität schlägt fehl, wenn Sie keine Monitore an statische Routen binden, da der Routenstatus vom VLAN-Status abhängt. Der VLAN-Status hängt vom Verbindungsstatus ab.

-

Eine teilweise Fehlererkennung erfolgt bei hoher Verfügbarkeit nicht, wenn ein Verbindungsfehler vorliegt. Eine Hohe-Verfügbarkeit-Split-Brain-Bedingung kann auftreten, wenn ein Verbindungsfehler vorliegt.

-

Wenn ein Linkereignis (Deaktivieren/Aktivieren, Zurücksetzen) von einer VPX-Instanz generiert wird, ändert sich der physische Status des Links nicht. Bei statischer LA wird jeder vom Peer initiierte Datenverkehr auf der Instanz gelöscht.

-

Damit die VLAN-Tagging-Funktion funktioniert, gehen Sie folgendermaßen vor:

Legen Sie auf VMware ESX die VLAN-ID der Portgruppe auf dem vSwitch des VMware ESX-Servers auf 1-4095 fest. Weitere Informationen zum Festlegen einer VLAN-ID auf dem vSwitch des VMware ESX-Servers finden Sie unter VMware ESX Server 3 802.1Q VLAN Solutions.

-

Tabelle 8. Unterstützte Browser

| Betriebssystem | Browser und Versionen |

|---|---|

| Windows 7 | Internet Explorer-8, 9, 10 und 11; Mozilla Firefox 3.6.25 und höher; Google Chrome-15 und höher |

| Windows 64-Bit | Internet Explorer − 8, 9; Google Chrome − 15 und höher |

| MAC | Mozilla Firefox - 12 und höher; Safari - 5.1.3; Google Chrome - 15 und höher |

Richtlinien für die Verwendung

Folgen Sie diesen Nutzungsrichtlinien:

- Wir empfehlen Ihnen, eine VPX-Instanz auf lokalen Datenträgern des Servers oder auf SAN-basierten Speichervolumes bereitzustellen.

Weitere Informationen zu VMware ESXi CPU-Überlegungen im Dokument Performance Best Practices for VMware vSphere 6.5. Hier ist ein Auszug:

-

Es wird nicht empfohlen, dass virtuelle Maschinen mit hohem CPU/Speicherbedarf auf einem Host/Cluster sind, der überbelegt ist.

-

In den meisten Umgebungen ermöglicht ESXi eine erhebliche CPU-Überbelegung, ohne die Leistung der virtuellen Maschine zu beeinträchtigen. Auf einem Host können Sie mehr vCPUs ausführen als die Gesamtzahl der physischen Prozessorkerne in diesem Host.

-

Wenn ein ESXi-Host CPU-gesättigt wird, d.h. die virtuellen Maschinen und andere Lasten auf dem Host alle CPU-Ressourcen verlangen, die der Host hat, funktionieren latenzsensitive Workloads möglicherweise nicht gut. In diesem Fall möchten Sie möglicherweise die CPU-Last reduzieren, indem Sie beispielsweise einige virtuelle Maschinen ausschalten oder auf einen anderen Host migrieren oder DRS erlauben, sie automatisch zu migrieren.

-

Citrix empfiehlt die neueste Hardwarekompatibilitätsversion, um die neuesten Funktionen des ESXi-Hypervisors für die virtuelle Maschine nutzen zu können. Weitere Informationen zur Hardware- und ESXi-Versionskompatibilität finden Sie in der VMware-Dokumentation.

-

Der Citrix ADC VPX ist eine latenzempfindliche, leistungsstarke virtuelle Appliance. Um die erwartete Leistung zu erzielen, benötigt die Appliance eine vCPU-Reservierung, Speicherreservierung und vCPU-Pinning auf dem Host. Außerdem muss Hyper-Threading auf dem Host deaktiviert werden. Wenn der Host diese Anforderungen nicht erfüllt, treten Probleme wie Hochverfügbarkeitsfailover, CPU-Anstieg innerhalb der VPX-Instanz, Trägheit beim Zugriff auf die VPX CLI, Absturz des Pitboss-Daemons, Paketausfälle und ein niedriger Durchsatz auf.

Ein Hypervisor gilt als übermäßig bereitgestellt, wenn eine der folgenden beiden Bedingungen erfüllt ist:

-

Die Gesamtzahl der auf dem Host bereitgestellten virtuellen Kerne (vCPU) ist größer als die Gesamtzahl der physischen Kerne (pCPUs).

-

Die Gesamtzahl der bereitgestellten VMs verbrauchen mehr vCPUs als die Gesamtzahl der pCPUs.

Wenn eine Instanz übermäßig bereitgestellt wird, garantiert der Hypervisor möglicherweise nicht die für die Instanz reservierten Ressourcen (wie CPU, Speicher und andere) aufgrund von Hypervisor-Planungs-Overheads, Fehlern oder Einschränkungen mit dem Hypervisor. Dieses Verhalten kann zu einem Mangel an CPU-Ressource für Citrix ADC führen und zu den im ersten Punkt unter den Nutzungsrichtlinien genannten Problemen führen. Als Administratoren wird empfohlen, die Mandanten auf dem Host zu reduzieren, sodass die Gesamtanzahl der auf dem Host bereitgestellten vCPUs kleiner oder gleich der Gesamtzahl der pCPUs ist.

Beispiel

Wenn für ESX-Hypervisor der Parameter

%RDY%einer VPX-vCPU in der Befehlsausgabe vonesxtopgrößer als 0 ist, wird für den ESX-Host Zeitplanungsoverhead angegeben, was zu Latenzproblemen für die VPX-Instanz führen kann.Reduzieren Sie in einer solchen Situation die Mandanten auf dem Host, sodass

%RDY%immer auf 0 zurückkehrt. Wenden Sie sich alternativ an den Hypervisor-Anbieter, um den Grund für die Nichteinhalten der durchgeführten Ressourcenreservierung zu prüfen. - Hot Adding wird nur für PV- und SRIOV-Schnittstellen mit Citrix ADC auf AWS unterstützt. VPX-Instanzen mit ENA-Schnittstellen unterstützen kein Hot-Plug, und das Verhalten der Instanzen kann unvorhersehbar sein, wenn Hot-Plugging versucht wird.

- Das heiße Entfernen entweder über die AWS-Webkonsole oder die AWS CLI-Schnittstelle wird mit PV-, SRIOV- und ENA-Schnittstellen für Citrix ADC nicht unterstützt. Das Verhalten der Instanzen kann unvorhersehbar sein, wenn versucht wird, Hot-Removal durchzuführen.

Befehle zur Steuerung der CPU-Auslastung der Paket-Engine

Sie können zwei Befehle (set ns vpxparam und show ns vpxparam) verwenden, um das CPU-Auslastungsverhalten von VPX-Instanzen in Hypervisor- und Cloud-Umgebungen zu steuern:

-

set ns vpxparam [-cpuyield (YES | NO | DEFAULT)] [-masterclockcpu1 (YES | NO)]Erlauben Sie jeder VM, CPU-Ressourcen zu verwenden, die einer anderen VM zugewiesen wurden, aber nicht verwendet werden.

Parameter für

Set ns vpxparam:-cpuyield: Freigabe von zugewiesenen, aber nicht genutzten CPU-Ressourcen.

-

YES: Erlauben Sie, dass zugewiesene, aber ungenutzte CPU-Ressourcen von einer anderen VM verwendet werden.

-

NO: Reservieren Sie alle CPU-Ressourcen für die VM, der sie zugewiesen wurden. Diese Option zeigt einen höheren Prozentsatz in Hypervisor- und Cloud-Umgebungen für die VPX-CPU-Auslastung.

-

DEFAULT: Nein.

Hinweis:

Auf allen Citrix ADC VPX-Plattformen beträgt die vCPU-Auslastung auf dem Hostsystem 100 Prozent. Geben Sie den Befehl

set ns vpxparam –cpuyield YESein, um diese Verwendung zu überschreiben.Wenn Sie die Clusterknoten auf “yield” setzen möchten, müssen Sie die folgenden zusätzlichen Konfigurationen für CCO durchführen:

- Wenn ein Cluster gebildet wird, erhalten alle Knoten “yield=DEFAULT”.

- Wenn ein Cluster unter Verwendung der Knoten gebildet wird, die bereits auf “yield=YES” eingestellt sind, werden die Knoten mit “yield=DEFAULT” zum Cluster hinzugefügt.

Hinweis:

Wenn Sie die Clusterknoten auf “yield=YES” setzen möchten, können Sie erst nach der Bildung des Clusters konfigurieren, aber nicht bevor der Cluster gebildet wurde.

-masterclockcpu1: Sie können die Haupttaktquelle von CPU0 (Management-CPU) auf CPU1 verschieben. Dieser Parameter hat die folgenden Optionen:

-

YES: Erlauben Sie der VM, die Haupttaktquelle von CPU0 auf CPU1 zu verschieben.

-

NO: VM verwendet CPU0 für die Haupttaktquelle. Standardmäßig ist CPU0 die Haupttaktquelle.

-

-

show ns vpxparamZeigt die aktuellen

vpxparam-Einstellungen an.

Andere Referenzen

-

Für Citrix Ready-Produkte besuchen Sie Citrix Ready Marketplace.

-

Informationen zum Citrix Ready-Produktsupport finden Sie auf der FAQ-Seite.

-

Informationen zu VMware ESX-Hardwareversionen finden Sie unter Upgrade von VMware Tools.

Teilen

Teilen

This Preview product documentation is Cloud Software Group Confidential.

You agree to hold this documentation confidential pursuant to the terms of your Cloud Software Group Beta/Tech Preview Agreement.

The development, release and timing of any features or functionality described in the Preview documentation remains at our sole discretion and are subject to change without notice or consultation.

The documentation is for informational purposes only and is not a commitment, promise or legal obligation to deliver any material, code or functionality and should not be relied upon in making Cloud Software Group product purchase decisions.

If you do not agree, select I DO NOT AGREE to exit.